Cómo evitar el desgobierno de la IA en las organizaciones

Hablar de una organización orientada a los datos está de moda, y hacer uso de IA también. ¿Cómo puede hacer la organización para encarar ambos desafíos de una manera orgánica y sistemática?

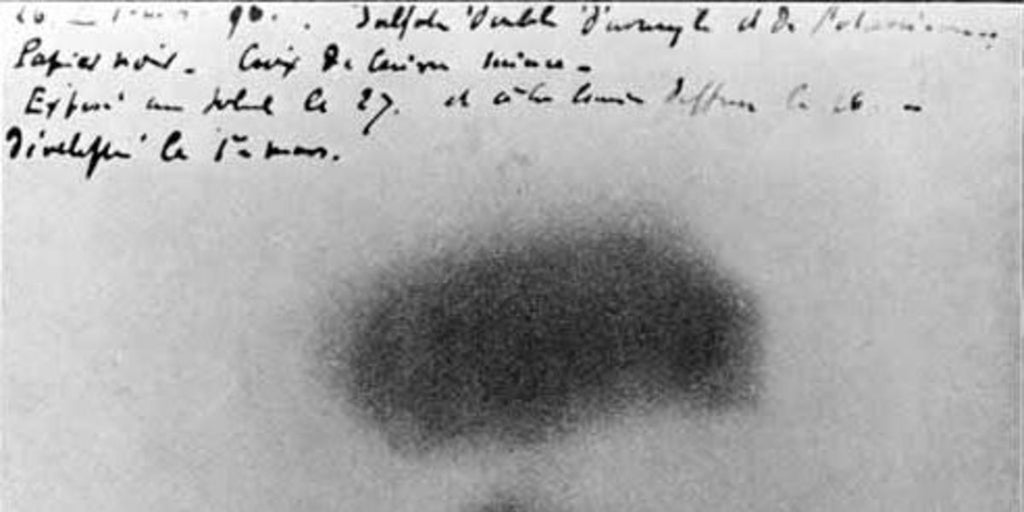

Las organizaciones se están moviendo lentamente hacia un mundo donde las aplicaciones basadas en IA van a ser cada vez más comunes y frecuentes. Al igual que las TI, la inteligencia artificial es una tecnología de propósito general que está transformando muchísimas actividades de la vida cotidiana: desde el teclado predictivo de nuestro teléfono, hasta las recomendaciones de temas musicales en base a nuestras preferencias, o la clasificación de imágenes para la detección temprana de supuestos tumores, o la sugerencia sobre cómo ahorrar tiempos en un proceso administrativo.

Su potencial transformador es tan grande que las organizaciones están cada vez más "acorraladas" a incorporar la IA en su operación normal y habitual para aprovechar las ventajas que estas ofrecen. Sin embargo, por ser una tecnología tan novedosa, la IA también requiere de mecanismos, procesos y políticas que aseguren el beneficio por los resultados obtenidos.

Como cualquier otro software, la IA toma ciertos inputs para generar determinados outputs. ¿Quién no ha escuchado hablar alguna vez la sigla GIGO (por su sigla en inglés): Garbage In, Garbage Out? Si lo que entra es "basura" (de mala calidad) lo que obtendremos también será de mala calidad. Pues la IA no está exenta de esta regla universal aplicable al software.

Por eso las organizaciones deben establecer una práctica de gobierno de la IA que facilite su incorporación en las operaciones cotidianas para entender cabalmente la complejidad de los inputs necesarios y la confiabilidad de los outputs obtenidos. Recordemos que la IA se basa en modelos probabilísticos, y por lo tanto, toda respuesta está atada a un cierto grado de certidumbre que el software de IA -por lo general- no nos informa.

Veamos un ejemplo simple: con una aplicación de IA podemos estimar cuándo se producirá el próximo quiebre de stock de un determinado producto. Ahora bien, nuestra actitud será muy distinta si el resultado del cómputo es "próximo quiebre de stock del producto X en 37 días" versus "próximo quiebre de stock del producto X en 37 días con un grado de confianza del 26%". En el primer caso, probablemente ni siquiera nos preocuparemos de validar el dato resultante, porque "como lo dice el sistema" confiamos ciegamente en que el cómputo es correcto.

Pero si contáramos con la información proporcionada por la segunda respuesta, rápidamente nos daríamos cuenta de que la estimación estará mal en 1 de cada 4 veces... o sea, es poco confiable para tomar decisiones de negocio que impliquen inversiones considerables de recursos.

Entonces, ¿cómo se aumenta el grado de confianza de las respuestas de IA? Hay básicamente dos maneras: la primera es asegurando la calidad de los inputs, es decir, de los datos que se usan como parámetros de entrada del cómputo que hace el modelo, y la segunda es la precisión del modelo de cálculo implementado por la IA.

Un excelente modelo con malos inputs adolece de GIGO. Y tener datos perfectos que se usan para alimentar un modelo mediocre también produce resultados de dudosa confiabilidad.

Estas dos formas de asegurar los resultados de las aplicaciones de IA (la calidad de los inputs y la calidad del modelo) se abordan de maneras complementarias. Para tener modelos de buena calidad el equipo de TI de la organización debe empezar a conformar un equipo de científicos de datos.

Por otro lado, para mejorar la calidad de los inputs es que se deben establecer políticas de gobierno del ciclo de vida de la información, ya que los datos que alimentan los modelos tienen un ciclo de vida desde su creación hasta que se lo da de baja o elimina porque ya carece de vigencia (por ejemplo, como cuando se deja de comercializar un producto por obsolescencia).

El equipo de científicos de datos debe primero entender a qué se dedica la organización para encontrar los mejores algoritmos a implementar en un modelo que sea específico para el caso de uso que se busca mejorar. La cantidad de algoritmos de IA existentes es muy dependiente no sólo del tipo de problemática de que se trata, sino que también de los datos con los que se cuenta para trabajar. A veces, un modelo determinado es excelente para resolver alguna cuestión particular, pero requiere muchos datos de prueba, y la empresa no cuenta con tal volumen de información, por lo que su aplicación resulta imposible en ese contexto.

Una posible Oficina de Gestión de la IA podría encargarse de aglutinar al equipo de científicos de datos para asegurar su entrenamiento en las problemáticas y desafíos del negocio, a fin de que optimicen el impacto de los modelos en beneficio del negocio. Por otro lado, con los ingenieros de datos deberían asegurar que la infraestructura de información es la apropiada para soportar todo el ciclo de vida de los datos que alimentan a dichos modelos, de tal manera que se maximice la calidad de los resultados obtenidos.

Establecer un catálogo de servicios de esta Oficina de Gestión de la IA sería la manera de ofrecer un "menú de servicios" que las unidades y funciones del negocio puedan elegir, como la carta de un restaurante. Medir la madurez de la arquitectura de información de cada área del negocio sería un servicio esencial para saber qué se le puede ofrecer en términos de modelos. Del mismo modo, es indispensable que esta Oficina colabore con las áreas de Personas para ir cerrando las brechas de formación que puedan existir en el camino hacia una organización orientada a los datos.

Nota del autor: ninguna plataforma de IA fue utilizada en la redacción de este artículo