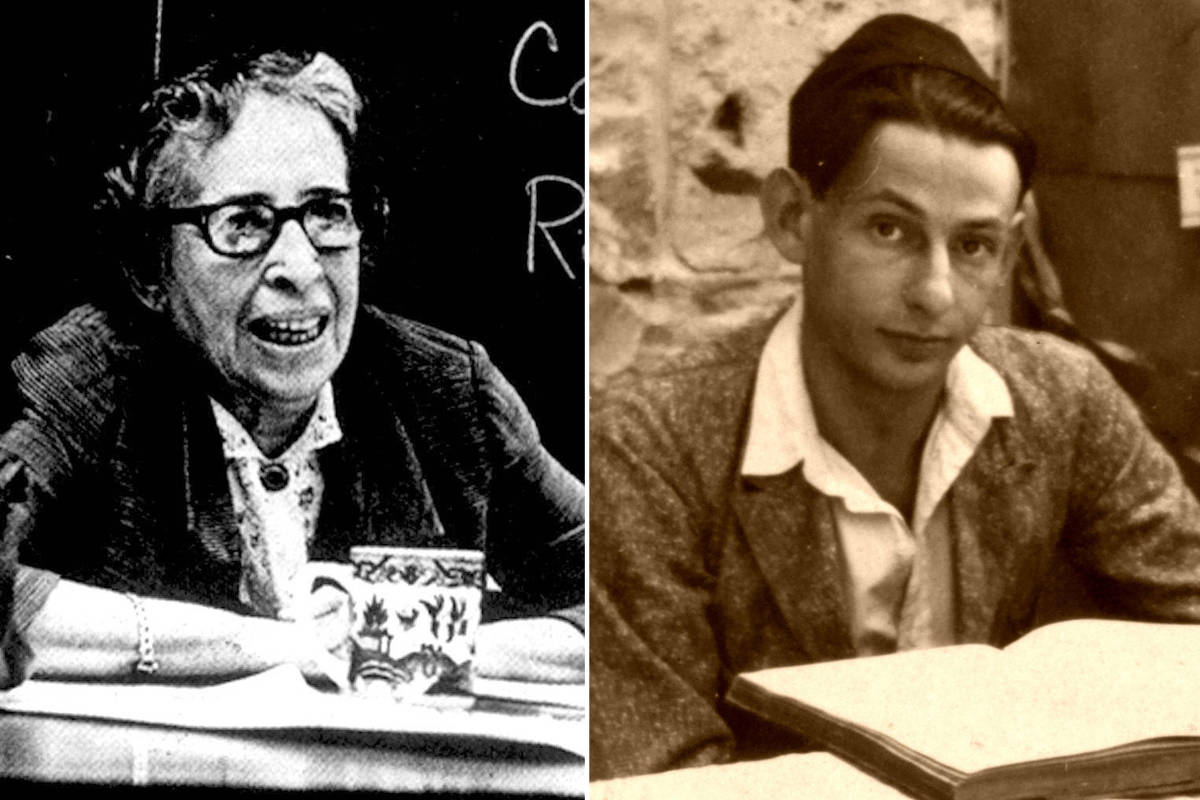

Tom Chatfield, filósofo e colunista da BBC: “Num futuro próximo, muitos tipos de conteúdo digital serão perfeitamente falsificados pela IA”

Em entrevista à Marketeer, filósofo deixou claro que a tecnologia, por mais avançada que seja, continua a ser um reflexo das nossas escolhas e que o verdadeiro desafio está em mantermos aquilo que nos torna humanos.

A propósito da celebração dos 10 anos da LTP, consultora que combina análise avançada e experiência em IA e estratégia de negócio, a inteligência artificial foi, invariavelmente, um tema em destaque no evento que assinalou o marco. Um dos momentos mais marcantes foi a participação de Tom Chatfield — filósofo britânico focado em tecnologia, escritor, colunista da BBC e uma das vozes mais respeitadas no debate contemporâneo sobre tecnologia.

Reconhecido pela sua capacidade de tornar acessíveis questões complexas sobre ética, cultura digital e pensamento crítico, Chatfield falou com a Marketeer sobre o impacto crescente da IA na sociedade, sobretudo nas gerações mais jovens, e alertou para a necessidade urgente de cultivarmos uma relação mais consciente e crítica com estas ferramentas.

Numa conversa profunda, mas acessível, o filósofo deixou claro que a tecnologia, por mais avançada que seja, continua a ser um reflexo das nossas escolhas — e que o verdadeiro desafio está em mantermos aquilo que nos torna humanos.

Como podemos cultivar o pensamento crítico numa era dominada por algoritmos que moldam aquilo que vemos (especialmente entre as gerações mais jovens)?

O pensamento crítico exige, fundamentalmente, uma pausa para introspeção: questionar como e por que acreditamos que certas coisas são verdadeiras, e reconhecer o que sabemos e o que não sabemos com certeza. Isto contrasta com o pensamento acrítico, onde aceitamos informações pelo seu valor facial sem avaliar a sua razoabilidade ou justificação — algo perigosamente fácil de fazer quando confrontados com a fluência impressionante das ferramentas de IA. Cultivar o pensamento crítico passa, em parte, por alimentar a curiosidade e a vontade de explorar para além do óbvio: investigar o “porquê” e o “como”, integrando a tecnologia nesse processo em vez de terceirizar completamente o nosso esforço cognitivo.

Como é que as gerações atuais e futuras podem ser preparadas para lidar com os sistemas de IA — que se estão a tornar cada vez mais norma — mantendo o pensamento crítico e tirando bom proveito destas ferramentas?

O ponto crucial é que vivemos numa época em que quase qualquer pergunta pode ser respondida de forma imediata e plausível pela tecnologia — por isso, temos de garantir que estamos a fazer perguntas que realmente valem a pena. A IA não nos pode dizer que propósitos devemos seguir, quais devem ser as nossas prioridades, nem o que os nossos sentimentos e ética nos dizem sobre o mundo e sobre os outros. Este tipo de reflexão crítica, criativa, empática e ética só se tornará mais importante.

Qual considera ser o maior dilema ético atualmente no que diz respeito à inteligência artificial?

A ética da IA está ligada às organizações e indivíduos que a criam, mantêm e dela lucram — e aos preconceitos que, de forma intencional ou acidental, são incorporados nestes sistemas hiper-poderosos. O dilema está em como podemos, coletivamente, compreender, controlar e regular entidades com um poder fantástico, e no que significa pensar de forma rica mas realista sobre as suas capacidades. Precisamos de desmistificar a IA e reconhecer que, apesar da sua complexidade, continua a ser parte do mundo tecnológico criado pelos humanos: um artefacto composto por dados, cabos, processadores e necessidades energéticas.

No caso dos sistemas autónomos de IA, quem deve ser responsabilizado quando algo corre mal? Acredita que devia haver uma discussão mais profunda e pública sobre este tema?

É necessário olhar, em primeiro lugar, para as pessoas que treinam e criam os sistemas, e acredito que devem ser responsabilizadas — não tanto pelo que utilizadores individuais fazem com as suas criações, mas sim pelo que significa criar mecanismos transparentes e responsáveis para identificar e mitigar danos. Uma discussão pública informada e bons princípios de design devem andar de mãos dadas: precisamos de mecanismos para identificar como e por que razão algo correu mal, como é que acidentes ou abusos ocorreram, e permitir que as partes afetadas reconheçam atempadamente o que estão a experienciar. Confiança, transparência e responsabilidade estão interligadas — tal como opacidade, desconfiança e manipulação.

Na sua perspetiva, quais são as qualidades humanas que a IA nunca conseguirá desenvolver? Acredita que estas são as áreas onde os humanos vão sempre superar as máquinas?

As IAs não têm corpo. São, creio eu, formas de inteligência sem mente, no sentido em que lhes falta individualidade e identidade própria — para não falar de verdadeira empatia, personalidade e os impulsos biológicos que nos ligam ao mundo natural. Em muitos aspetos, é um erro de categoria usar o mesmo termo para inteligência humana e artificial. Se não tivessem ingerido enormes quantidades da nossa linguagem, nada teríamos em comum — o “mundo” delas é feito de padrões multidimensionais desenhados em dados. Superaremos sempre as máquinas no que toca a ser humanos, a ser sensorial e exclusivamente nós próprios, com a nossa fragilidade, desejos e ligações amorosas. Para além disso, hesito em afirmar mais.

Tem-se falado muito sobre o chamado “brain rot”. Acredita que existe um risco real de que a IA possa corroer ou substituir aspetos essenciais da cognição humana?

Certamente que há riscos quando se trata de terceirizar aspetos do pensamento crítico, da interpretação do mundo, da comunicação, e assim por diante. Como escritor, lamento o declínio da leitura como atividade cultural sustentada, pois aprender a perder-se nas palavras é uma experiência tão bela quanto profunda. Mas não quero ser demasiado apressado a desvalorizar a resiliência e o brilho humano. Enquanto espécie, reinventamo-nos constantemente, há dezenas de milhares de anos. Ser humano é mudar, aprender, adaptar-se — e usar de forma inteligente tudo o que a tecnologia e o ambiente nos oferecem. Isso não vai mudar, ainda que nós mudemos.

A IA será mais uma ameaça ou uma vantagem para a política na próxima década? E de que forma?

Tem um poder imenso para quem estiver disposto a usá-lo: tanto ao nível da persuasão explícita como da manipulação e análise subtil. Vejo ameaças significativas às formas atuais de política através de campanhas de influência, bots persuasivos indistinguíveis de indivíduos reais, ciberataques e conteúdos manipulados algoritimicamente que distorcem a perceção da realidade. No entanto, a IA é também uma ferramenta poderosa para gerar conhecimento, resolver problemas, ajudar pessoas, construir pontes — não quero perder-me em visões apocalípticas. Os deepfakes, por exemplo, não subverteram a democracia da forma que alguns previam. Talvez focarmo-nos excessivamente na tecnologia seja, por si só, um erro, quando as pessoas estão mais preocupadas com empregos, guerras, segurança, o mundo natural, as suas comunidades. O que as pessoas realmente valorizam não está no ecrã, mesmo quando parece estar: a tecnologia é sempre, no fundo, um reflexo de algum medo ou esperança humana.

À medida que a IA se envolve cada vez mais na criação de conteúdos, acredita que podemos chegar a um ponto em que se torne quase impossível distinguir a verdade da manipulação? Ou pensa que iremos desenvolver ferramentas cada vez mais eficazes para detetar isso?

Os humanos, coletivamente, conseguem ser surpreendentemente bons a identificar insinceridade e engano com o tempo — ainda que, no curto prazo, sejamos assustadoramente fáceis de enganar! Acredito que muitos tipos de conteúdo digital serão perfeitamente falsificados pela IA num futuro próximo. Isso criará novas necessidades e escassez em torno da verificação por triangulação com outros fatores: indicadores fiáveis de identidade, presença física, biometria, marcas de autenticidade, detalhes infalsificáveis, encriptação, e assim por diante. Suspeito que estaremos à altura do desafio, embora possamos perder bastante confiança e passar por alguns escândalos pelo caminho. O que mais temo não é a ausência de verdade, mas sim a indiferença para com ela: a proliferação de realidades paralelas dentro das quais cada um escolhe o conjunto de narrativas ideologicamente mais convenientes. Sem um terreno comum, é difícil que uma sociedade democrática funcione — e demasiado fácil que uma autoritária o consiga.

Como podemos encontrar um equilíbrio entre exigir maior transparência aos algoritmos utilizados pelas grandes plataformas e, ao mesmo tempo, não sufocar a inovação?

Exigir que as pessoas expliquem as suas ações e sejam responsabilizadas por elas não é o mesmo que sufocar a inovação. Na prática, não se pode prever o que virá a seguir, e tentar antecipar isso pode mergulhar tudo em anos de debates legais. Por isso, é necessário um debate informado e o máximo possível de transparência e mecanismos de reparação em torno dos danos, sem impor requisitos regulatórios monolíticos.

Na sua opinião, qual é a questão mais urgente que deveríamos estar a colocar sobre a inteligência artificial — mas ainda não estamos?

Quando é que não queremos usá-la? Que limites devemos impor à IA não por razões de eficiência ou segurança, mas em termos de prazer, conexão humana, ou simplesmente da qualidade do tempo e das experiências que desejamos ter? Adoro experimentar tecnologia com os meus filhos. Mas também adoro estar com eles de forma simples, lúdica, empática, sem mediação de nada. Precisamos de tempo e espaço para simplesmente ser, como seres humanos, para nos conectarmos connosco próprios e com o mundo. Nem tudo tem de ser justificado em termos de ganhos e perdas mensuráveis.