IdentifAI smaschera i falsi dell’intelligenza artificiale

MENTRE LE APPLICAZIONI di Intelligenza artificiale proliferano, urge correre ai ripari e avere anche strumenti digitali, in grado di de-generare,...

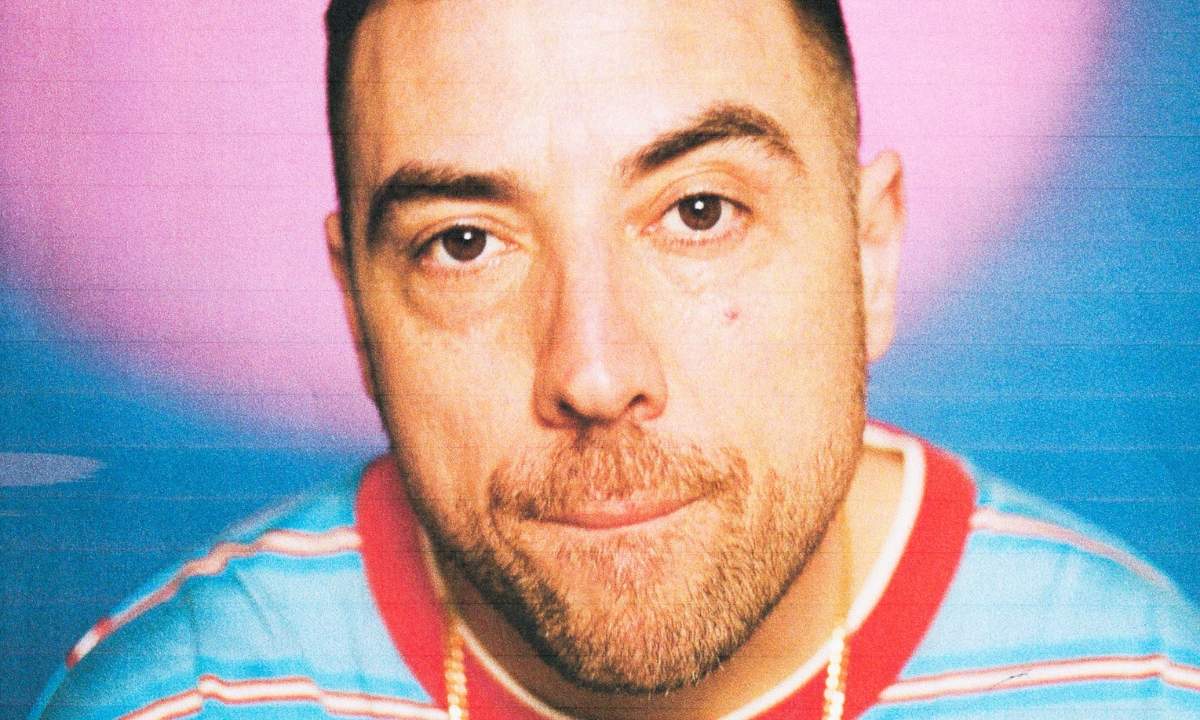

MENTRE LE APPLICAZIONI di Intelligenza artificiale proliferano, urge correre ai ripari e avere anche strumenti digitali, in grado di de-generare, cioè di identificare in maniera univoca l’intervento degli algoritmi intelligenti. Nasce da questa idea IdentifAi, startup innovativa con sede a Milano, specializzata nella definizione e nel training di modelli (de)generativi per identificare l’origine di contenuti potenzialmente generati da sistemi di intelligenza artificiale. "L’avanzamento tecnologico in ambito generative AI causerà un avvicinamento tra il mondo fisico e quello digitale rendendoli indistinguibili ad occhio umano", spiega Marco Ramilli, cofondatore di IdentifAI. "Credo sia nostro diritto essere informati, in ogni momento, su ciò che utilizziamo per alimentare la nostra mente, che a sua volta dirige la nostra opinione".

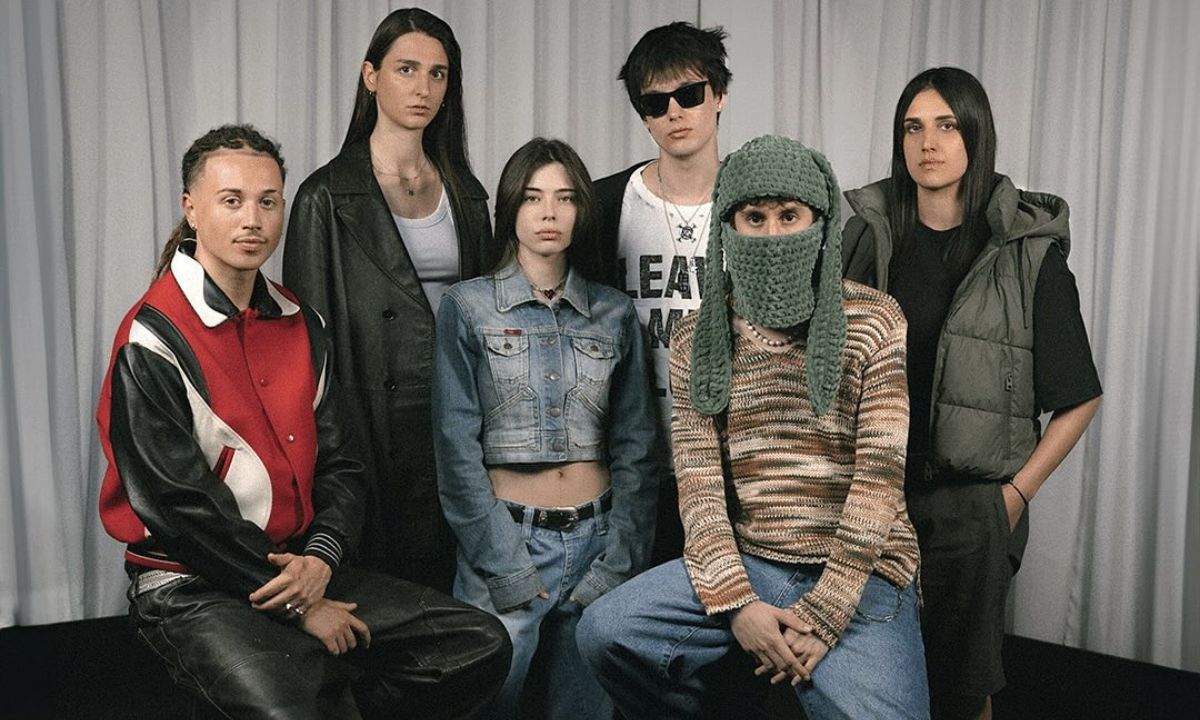

Per modello degenerativo IdentifAI intende un proprio modello generativo addestrato per identificare un artefatto, sia esso una immagine, un video, un suono o un testo, realizzato da una intelligenza artificiale. Un sistema decostruttore, basato sulla probabilità dell’accadimento di ogni singolo pixel. "Nel mondo iperconnesso di oggi, l’affidabilità delle immagini, dei video e delle voci sta diventando un fattore critico di sicurezza e di stabilità economica per organizzazioni ed individui", aggiunge l’altro cofondatore di IdentifAi, Marco Castaldo. "La nostra startup nasce con l’obiettivo di proteggere aziende, media e istituzioni da una minaccia crescente: la manipolazione dei contenuti digitali tramite intelligenza artificiale. I deepfake sono, infatti, un rischio tecnologico con un crescente impatto economico, qualcosa in grado di compromettere la credibilità delle fonti di informazione, mettere in crisi i processi di verifica online delle identità personali, indebolire la reputazione e dunque la fiducia in organizzazioni di qualsiasi settore e dimensione, manipolare e inquinare i sistemi politici. Tutto questo ci ha spinti ad occuparci di immagini e video alterati. Ora, con l’avanzare delle tecnologie vocali sintetiche, estendiamo la nostra capacità di verificare l’autenticità di contenuti digitali anche all’analisi e alla verifica delle voci umane", spiega ancora Castaldo.

Qualche esempio? Sono i due fondatori della startup milanese a farli "Prendiamo un contenuto falso ben realizzato e come questo possa influenzare l’andamento di un titolo in borsa, generare disinformazione in campagna elettorale, danneggiare brand consolidati. Un contenuto ben fatto falso può per esempio consentire ad un criminale di passare per qualcun altro ed ottenere informazioni critiche e strategiche, bypassando le barriere informatiche che le organizzazioni hanno alzato negli anni contro il cyber crime. Oppure potrebbe terrorizzare un anziano che crede di parlare con il figlio o con il nipote che chiede un bonifico urgentissimo", spiegano Ramilli e Castaldo. Per questo "rilevare e certificare l’autenticità dei contenuti digitali non è più solo una questione etica o legale: è un’esigenza economica e di sicurezza generale. Il mercato della verifica dei contenuti è in forte espansione e la domanda di strumenti affidabili cresce ogni giorno. Il nostro lavoro si inserisce in questa transizione da un mondo dove la verità era in quello che vedevamo e sentivamo, ad uno nel quale il vero e il falso sono sempre più difficili da distinguere", conclude Castaldo. La startup si avvale della collaborazione delle università di Bologna e di Napoli, con le quali sono stati lanciati progetti di ricerca.