Si en inteligencia artificial no hay moat, sus creadores no capturarán el valor de la mejora de productividad

Chatbot Arena se ha convertido en el benchmark que suelo mirar primero para entender el nivel de un modelo conversacional.

Chatbot Arena se ha convertido en el benchmark que suelo mirar primero para entender el nivel de un modelo conversacional.

En lugar de un conjunto de pruebas estandarizado (que suelen tener el problema de la contaminación, que los modelos hayan podido integrarlos en los datos de entrenamientos), Chatbot Arena se guía por las vibraciones, la experiencia subjetiva de los usuarios que catan a ciegas dos IAs diferentes y valoran.

En el último año lo que ha sucedido con su tablón de ganadores es fácil de resumir. Cada vez que un nuevo chatbot se erigía en el mejor, en un par de semanas solía aparecer un nuevo contendiente que, por poco, le superaba. Los distintos laboratorios lanzan sus modelos antes de lanzarlos al mercado, a veces versiones con apenas modificaciones, sólo para poder afirmar que “tenemos al mejor”.

Si analizamos los últimos meses nos hemos llevado sorpresas con modelos de Deepseek, el lanzamiento de Grok 3, el de Claude 3.7 y, por último, el de GPT-4.5. Que cada uno mejorara lo anterior, o al menos lo igualara, que ninguno haya logrado establecer una diferencia palpable nos indica a las claras que, de momento, no han logrado un moat.

Cuando hablamos de moat (foso) en negocio y tecnología hablamos de una ventaja competitiva sostenible que protege a una empresa frente a sus competidoras. El ejemplo clásico es el de Intel y la arquitectura x86: como la industria de ordenadores de consumo con Windows se construyó sobre ella, esa propiedad intelectual constituía una ventaja que le otorgó décadas de bonanza.

No hay moat que cien años dure. Intel es buen ejemplo: si pierdes primero el mercado móvil frente a ARM y la computación para la inteligencia artificial después frente a Nvidia, acabas quedándote atrás. Lo mismo podemos pensar de Google con el buscador, de Apple con el control del iPhone o de Meta con las redes sociales.

Promo

¿Te gusta la tecnología y su industria? Deberías estar leyendo EsencialTech

La tecnología avanza a una gran velocidad pero, ¿cómo estar al día sin perder horas filtrando información irrelevante? En EsencialTech envían cada día un resumen de lo esencial: innovación, inteligencia artificial, gadgets y más. Nada de artículos eternos ni tecnicismos innecesarios: simplemente las claves para entender el mundo tech, de forma breve y directa. Empieza, como yo, tu día bien informado, sin necesidad de perder tiempo. Suscríbete ahora.

En los grandes modelos de la IA generativa nadie ha conseguido ese moat. Es cierto que tenemos que OpenAI suele adelantarse al resto y que o3 no ha sido igualado hasta el momento. Pero la aparición de otros modelos razonadores, sumados a que GPT-4.5 no parece descollar en nada frente a la competencia me lleva a pensar que no hay ningún avance ni técnicas propias que no puedan ser replicados.

En Google así lo pensaban en 2023 y sus argumentos siguen siendo válidos. Aunque cada vez las empresas de AI son menos dadas a compartir sus avances, basta con que se sepan los principios que guían sus productos para que el resto pueda replicarlos. Con saber que es posible aplicar aprendizaje por refuerzo a los LLMs y que mejoran con más tiempo “para pensar” ya tienen suficiente.

Es más, Deepseek nos mostró otro aspecto relevante: el moat derivado de la inversión y la acumulación de datacenters y miles de tarjetas Nvidia tampoco es tal. Es cuestión de meses que otros sean capaces de igualar el nivel del mejor modelo de OpenAI y, además, de ofrecer su IA de forma abierta.

¿Qué implicaciones tiene esto? De momento tenemos que las empresas de IA tienen un camino de la rentabilidad mucho más duro: sigue siendo caro entrenar y ejecutar los modelos. Al mismo tiempo, al no ser capaces de diferenciarse tenemos que Grok 3 nos lo están regalando a pesar de los enormes costes y que los precios de las APIs de Gemini o GPT-4 descienden a cada poco.

Debemos diferenciar entre el valor generado y la capacidad para capturarlo

Sabemos que integrar la IA actual produce mejoras de productividad y que la expectativa es que lo haga mucho más. La gran pregunta es quién va a hacerse con la plusvalía generada. Un ejemplo de la era de internet: la transmisión de datos a alta velocidad es imprescindible, pero en la economía digital las telecos han hecho negocio… pero no tanto como las empresas en la capa de sistema operativo móvil o aplicación. Es mejor ser Instagram que ser Orange o Vodafone: a la hora de transmitir bits, no hay diferenciación entre ellos (actualmente sí la hay con Telefónica, que empeora su servicio cuando lo ordenan Javier Tebas y LaLiga).

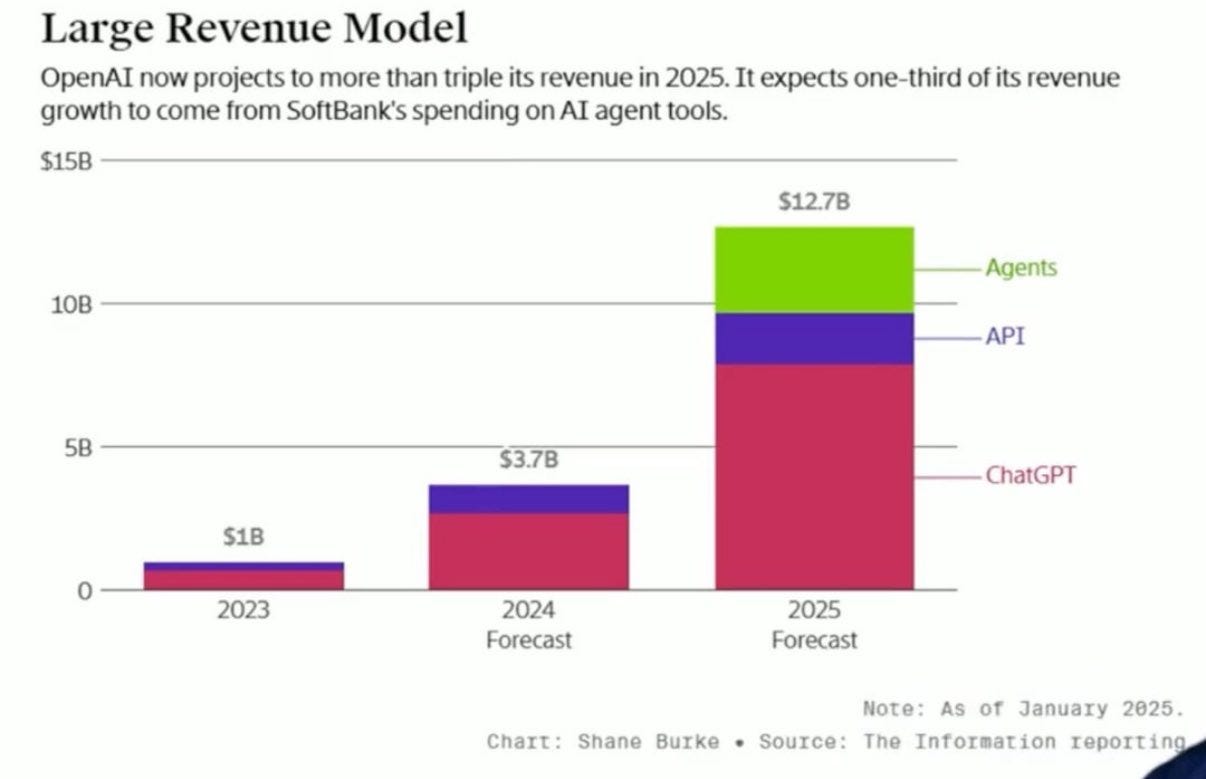

En la estrategia y proyección económica de OpenAi podemos ver por donde quieren lograr esa diferenciación. Ser menos una empresa “plataforma” que sirve inteligencia artificial vía API para que otros construyan aplicaciones, ser más una empresa de servicios a la que usuarios finales (particulares, empresas) acceden para consultar a sus modelos y, sobre todo, sus agentes.

¿Puede construir un foso defensivo OpenAi y capturar el valor generado por la inteligencia artificial a partir de sus agentes? La noticia de que pretenden cobrar hasta 20000 dólares al mes por alguno de ellos nos indica que ellos creen que sí.

Como en los modelos grandes de lenguaje, aquí también llevan al menos una ventaja de meses. Cada vez estoy más enganchado a su Deep Research y ninguna de las alternativas de Google, Perplexity o Grok me parece que esté a su nivel.

¿Son meses de ventaja o el resto les igualará porque alcanzarán el nivel del modelo utilizado, o3?. Veamos al cocientífico de Google, basado en Gemini y en una arquitectura de agentes. En un par de días planteó la hipótesis que a microbiólogos llevó años alcanzar. Todavía no he podido probar Manus, pero el laboratorio chino que lo ha creado presume: hemos alcanzado el nivel de agente de Deep Research de OpenAI.

Sam Altman apuntó a que 2025 era el año en el que los agentes de inteligencia artificial se iban a “unir a la fuerza laboral” Es el momento en el que se empiezan a automatizar empleos de cuello blanco y, por tanto, eclosiona el gran negocio de esta era.

¿Esto es real? Tenemos algún caso que apunta a que vamos en esa dirección. Según The Information, Novo Nordisk ha utilizado Claude 3.5 Sonnet para convertir una de las tareas farmacéuticas más tediosas y costosas -la redacción de documentos normativos delicados- en algo asombrosamente más rápido y eficaz. Los informes de estudios clínicos, que antes tardaban 15 semanas y requerían más de 50 redactores médicos especializados, ahora se pueden redactar en menos de 10 minutos, supervisados por sólo tres expertos humanos.

Al utilizar un modelo comercial con un coste de apenas 20 dólares al mes, Novo Nordisk muestra que sería la propia empresa quien capture en gran medida la mejora de productividad: esos empleados podrían ser amortizados, despedidos, o recolocados y enfocados a otras tareas aumentando la producción de la empresa. Y todo ello a bajo coste.

La pregunta, por tanto, es si con agentes que acometan tareas más complejos las empresas de inteligencia artificial como OpenAI serán capaces de diferenciarse y quedarse con gran parte de ese ahorro salarial del resto de industrias. Si atendemos a la historia de los dos últimos años en IA, mi apuesta sería que no.

¿Y en gran consumo? Javier Pastor analizaba la presentación de Alexa + en una clave negativa hacia Amazon. Mi posición en el último episodio monos estocásticos es diferente. Si los modelos se van a igualar y nadie consigue dar con un elemento científico-técnico no replicable, entonces la gran ventaja en el público masivo la tendrá quien domine la distribución.

Es mejor escenario para Apple con Siri y iPhone, para Google con Android y Microsoft con Windows o para Amazon con Alexa +. Incluso para Meta e Instagram y Whatsapp. No tanto para OpenAI, Anthropic o Mistral, las “nativas de inteligencia artificial”.

Si en inteligencia artificial no hay moat, sus creadores no capturarán el valor de la mejora de productividad. Quedarán en una posición de la cadena de valor en la que es difícil diferenciarse y, como en otras tecnología generalistas (la electricidad, internet), el gran negocio está en otra parte.

_general.jpg?v=63913670931)