Microsoft presenta BitNet, un LLM che sfida i giganti dell'AI con soli 400 MB

Microsoft presenta BitNet, un modello AI efficiente che compete con i migliori usando soli 400MB e senza GPU, grazie alla quantizzazione ternaria

Microsoft ha svelato BitNet b1.58 2B4T, un modello linguistico di grandi dimensioni progettato per un'efficienza sorprendente. La sua peculiarità? Invece di utilizzare i tradizionali numeri in virgola mobile a 16 o 32 bit per rappresentare ogni parametro, BitNet si affida a soli tre valori discreti: -1, 0 e +1. Questa tecnica, denominata quantizzazione ternaria, permette di archiviare ogni "peso" in appena 1,58 bit. Il risultato è un modello che riduce drasticamente l'utilizzo di memoria e che può operare con molta più agilità su hardware standard, bypassando la necessità di costose GPU di fascia alta solitamente indispensabili per l'AI su larga scala.

Il team di General Artificial Intelligence di Microsoft ha messo a punto BitNet b1.58 2B4T, un sistema con due miliardi di parametri – i valori interni che consentono al modello di comprendere e generare il linguaggio. Per compensare la sua precisione ridotta, il modello è stato addestrato su un vastissimo insieme di dati composto da quattro trilioni di token, un volume di informazioni paragonabile al contenuto di 33 milioni di libri. Questo addestramento intensivo permette a BitNet di competere – e in alcuni casi superare – altri modelli di dimensioni simili, come Llama 3.2 1B di Meta, Gemma 3 1B di Google e Qwen 2.5 1.5B di Alibaba.

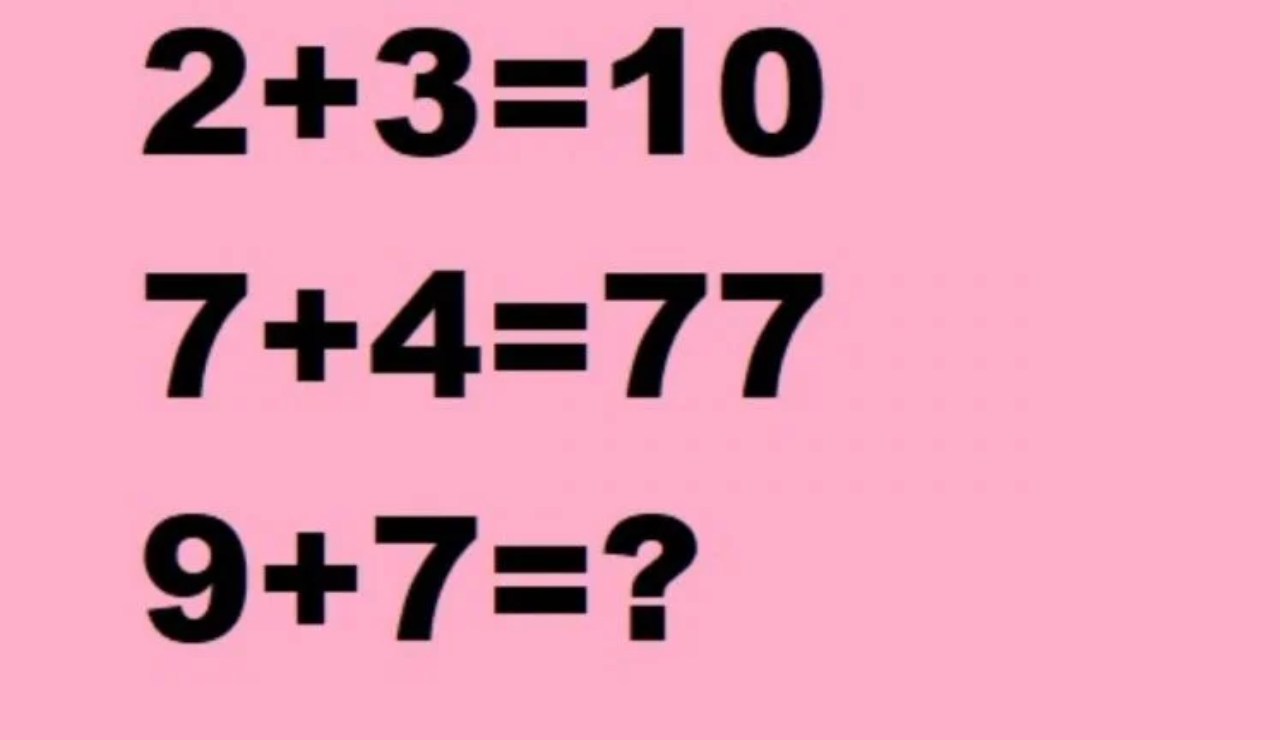

Le prove comparative hanno evidenziato le notevoli capacità di BitNet b1.58 2B4T in diverse attività, tra cui problemi di matematica elementare e quesiti che richiedono ragionamento di buon senso. In alcune valutazioni, ha persino ottenuto risultati migliori dei suoi concorrenti.