Intelligenza artificiale e bambini, De Martin (Politecnico di Torino): “Dico no, non hanno gli strumenti per capire”

Il docente di ingegneria informatica e co-direttore del Centro Nexa su Internet e società: “Nessun pregiudizio ma deve valere il principio di precauzione. Ecco quali sono i rischi”

Torino, 10 maggio 2025 - Intelligenza artificiale e bambini. Juan Carlos De Martin, professore di Ingegneria informatica e co-direttore del Centro Nexa su Internet e società al Politecnico di Torino, voce autorevole in questo campo, autore del libro ‘Contro lo smartphone. Per una tecnologia più democratica’: cosa risponde di fronte a questa associazione?

“Con una domanda. Mi chiedo: perché? Perché i bambini dovrebbero usarla? Perché questi nuovi servizi dovrebbero essere utili per i minori? Nell’ambito digitale, più che in altri, vengono sviluppati prodotti. Poi ci si chiede, ma questo a che cosa potrebbe servire? Con un percorso inverso rispetto a quello che capita normalmente con la tecnologia, storicamente parlando. Di solito c’è un problema e ci si ingegna per cercare la soluzione”.

Quale deve essere il limite d’età per avere accesso all’intelligenza artificiale?

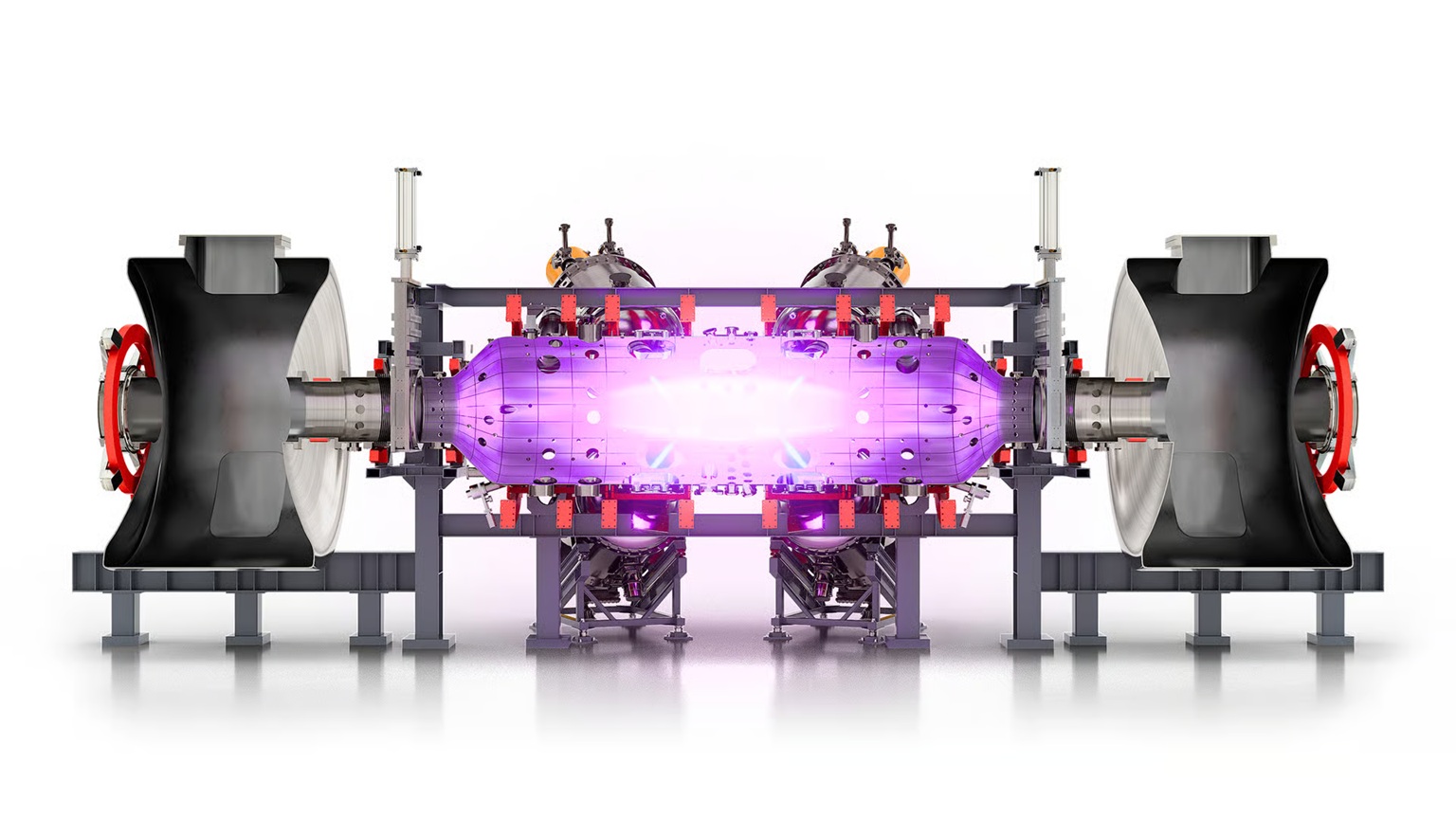

“Nel caso dei minori, applicherei sicuramente il principio di precauzione. Tanti adulti passano ore sostanzialmente a giocare con l’Ia, a meravigliarsi, guarda un po’ cosa ha fatto. Invece l’impatto ambientale è tutt’altro che trascurabile. Ogni giochetto in realtà brucia petrolio”.

Dire ‘grazie’ e ‘per favore’ a ChatGpt costa milioni di dollari per la potenza di calcolo richiesta, ha appena ricordato il seo di OpenAi, Sam Altman.

“Infatti non è innocuo, il costo del giochino lo paga il pianeta. Tornando ai minori, ho tre figlie e mi chiedo: non è ben chiaro a cosa serva, ha un impatto, non capiamo le implicazioni, ad esempio di privacy. Il porre domande a questi strumenti, come fare anche ricerche su Google, trasmette informazioni anche molto sensibili su di noi, a seconda di ciò che chiediamo. Perché da quello si possono dedurre i nostri orientamenti in tutti i campi. Quindi c’è un aspetto di privacy rilevante. E sui minori c’è un’altra questione. Visto che sono strumenti di così facile utilizzo, che forniscono risposte così accattivanti, c’è il rischio che vengano presi come oracoli. La conclusione potrebbe essere, mi ha risposto, di sicuro sarà giusto, di sicuro sarà così…”.

Gli psicologi avvertono: i ragazzi usano sempre più spesso l’Ia come terapeuta.

“Non solo. Altre applicazioni sono il compagno o il fidanzato virtuale. E ci sono anche servizi a pagamento”.

Negli Stati Uniti una madre ha fatto causa a due colossi tecnologici, la sua accusa è terribile: un chatbot avrebbe provocato il suicidio del figlio 14enne.

“Parliamo di uno strumento accattivante, che fra l’altro è gentile, mi chiede scusa e per favore... Mi dice qualcosa e lo fa in un italiano tendenzialmente corretto, che sembra tutto logico. Quindi questo è un rischio. Ci si disabitua a capire cosa sono le fonti, a consultarle, ad arrivare alla nostra sintesi personale. Questo, in realtà, dovrebbe essere il percorso di scuola e università. Che dovrebbero darci gli strumenti per accedere anche a fonti primarie per poi criticamente metterle insieme e costruire il nostro punto di vista. Se arriva qualcuno che ci dice, non ti preoccupare, io so già tutto, e ce lo scodella come una sorta di super bignami, velocissimo e accattivante, questo rischia anche di produrre un abbassamento considerevole delle nostre capacità critiche”.

Quindi è un pericolo educativo?

“Sì, per tutti. Anche per un adulto che chiede, dimmi cosa sta succedendo in quel Paese. A maggior ragione, per i minori. Quando sento parlare di applicare questi servizi in ambito educativo, sono molto scettico. Perché qualcuno mi dovrebbe dire: c’è questo problema e introducendo certi strumenti lo risolviamo o cogliamo un’opportunità. Ma non ho ancora letto una pagina che argomenti tutti i passaggi in modo chiaro. C’è una specie di entusiasmo acritico. Dobbiamo usarla perché dobbiamo usarla, dobbiamo usarla perché è nuova”.

Come si trova il filo della storia?

“Questi sono prodotti come tutti gli altri e quindi si applicano le regole che già esistono a tutela dei consumatori, per esempio. Cosa che spesso viene dimenticata. C’è una specie di eccezionalismo digitale, quasi che si fosse al di fuori di tutti gli schemi. Invece le norme ci sono. Naturalmente ci dev’essere qualcuno che le fa applicare. Quindi non dobbiamo pensare che questi prodotti siano extra legem. Quel che vale per il tagliaerba vale anche per ChatGpt. In passato questo concetto è stato ribadito dalla Federal Trade Commission americana, la presidente giustamente diceva, i nuovi servizi sono prodotti”.

Quindi per l’accesso ai minori che regole servono?

“Di solito questa domanda mi viene rivolta su smartphone o social media. Lì c’è un’evidenza abbastanza robusta, la frequentazione delle piattaforme crea una serie di problemi psicologici ai ragazzi. Anche nel caso dell’Ia, insisto, serve un principio di precauzione. Fino a quando qualcuno non argomenta in maniera chiara i vantaggi e ci dice che gli effetti negativi sono stati studiati e sono ragionevoli. Direi: mettiamo l’onere della prova su chi propone”.

Principio di precauzione. Quindi social, smartphone e Ia solo da una certa età in poi.

“Sì, anche perché non esistono telefonini per bambini. Quello che usa un minore è lo stesso che utilizza un adulto, una macchina che raccoglie una quantità sterminata di dati. Ci sembra ragionevole che a distanza di 18 anni dal primo smartphone della Apple nessun regolatore abbia ancora detto, se queste cose vanno in mano ai bambini, devono essere oggetti diversi da quelli invasivi? Questo dovrebbe essere buon senso ma a quanto pare gli interessi sono troppo alti...”.

Una preside ha raccontato al nostro giornale: 9 bambini su 10 a 6 anni dicono di usare il telefonino.

“Qui c’è un problema sociale importante. Se in una classe tutti hanno lo smartphone, diventa molto difficile dire al proprio figlio, no tu non ce l’avrai. Un’iniziativa importante che mi piace sempre ricordare è quella dei Patti digitali, promossa da un docente della Bicocca, Marco Gui. Ormai anni fa ha capito, da sociologo, che c’era un problema importante. Bisogna decidere collettivamente come muoversi, nelle classi e nelle scuole. Ormai centinaia di istituti in tutta Italia hanno adottato questi modelli. Così si evita il problema del bambino che dice, perché io no?”.

Che consiglio darebbe ai genitori?

“Non farei utilizzare l’intelligenza artificiale ai bambini. Perché non hanno assolutamente gli strumenti cognitivi per capire che cosa sta succedendo. Per loro diventa una situazione magica. Si scrive qualcosa e magicamente salta fuori la risposta. Invece loro hanno bisogno, proprio in quell’età, di capire come si arriva alla conoscenza. Di capire che cos’è, come viene prodotta e trasmessa. Hanno un rapporto molto sano con i libri, sanno che li ha scritti qualcuno, con il tempo devono imparare a porsi in maniera critica anche verso quello strumento, che pure non è un oracolo. E poi c’è una componente molto importante: quello che è scritto in un libro è riconducibile a esseri umani in carne e ossa, identificabili. Invece nel caso dell’Ia non c’è un essere umano che si prende la responsabilità di quel che sta scrivendo. Semplicemente è una macchina che sembra funzionare”.