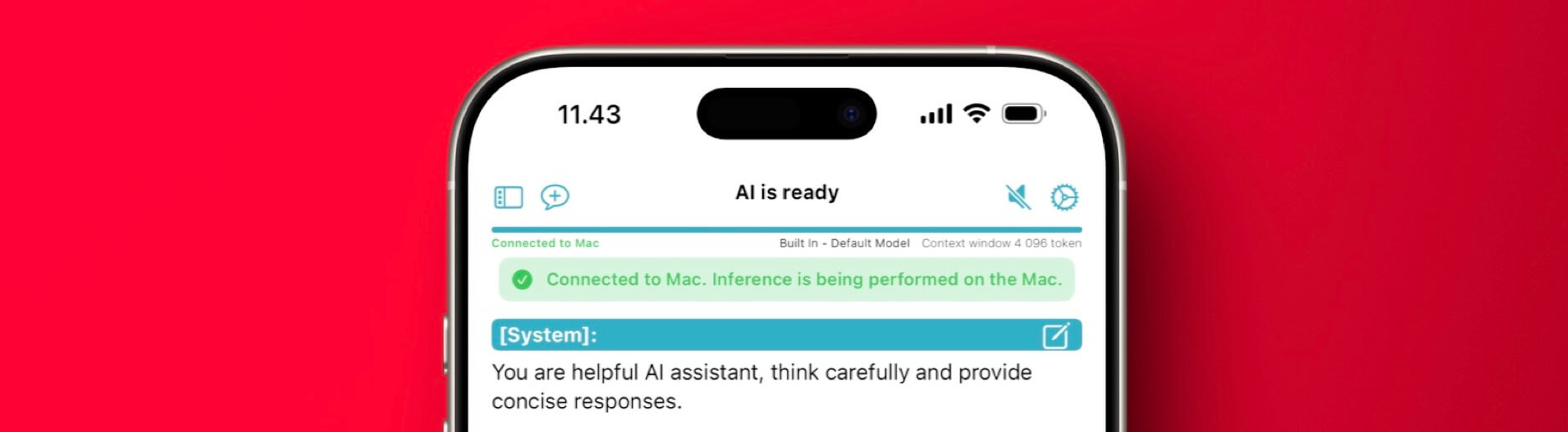

„On-Device AI“ spricht lokale KI-Modelle am Mac vom iPhone aus an

Ergänzend zu „lokale LLM-Sprachmodelle auch unterwegs“: On-Device AI beinhaltet direkt einen Server Mode, der eure (An-)Fragen vom iPhone auf dem eigenen Mac rechnet – gleichermaßen ein privates „Private Cloud Compute“. Dort laufen leistungsfähigere Modelle, die auf mehr Arbeitsspeicher zugreifen und die den Stromverbrauch nicht interessieren. Mit Tailscale (+ Exit Node) klappt das von überall aus, solangeweiterlesen

Ergänzend zu „lokale LLM-Sprachmodelle auch unterwegs“: On-Device AI beinhaltet direkt einen Server Mode, der eure (An-)Fragen vom iPhone auf dem eigenen Mac rechnet – gleichermaßen ein privates „Private Cloud Compute“.

Dort laufen leistungsfähigere Modelle, die auf mehr Arbeitsspeicher zugreifen und die den Stromverbrauch nicht interessieren. Mit Tailscale (+ Exit Node) klappt das von überall aus, solange der Mac erreichbar ist.

Aber wie bereits gestern angesprochen: Natürlich sollte Apple eine solche Funktionalität zwischen seinen Computern selbst anbieten.

Wenn du Artikel wie diesen magst, unterstütze mich doch mit einem Abo für iPhoneBlog #one. Alle Abonnent:innen erhalten jede Woche ein exklusives „Gewusst-wie”-Video, den Zugriff auf alle schon veröffentlichten Episoden sowie die Einladung zu einer ganz besonderen Community in einem privaten Slack-Kanal.

![Warum die Google Search Console eines der wichtigsten Relaunch-Werkzeuge ist [Search Camp 368]](https://blog.bloofusion.de/wp-content/uploads/2025/02/Search-Camp-Canva-368.png)

,regionOfInterest=(304,150)&hash=f4eabf6a9da0b65f4383d679ca1aa22780743e52a2ffee6f685c115ca62c1093#)

,regionOfInterest=(1583,497)&hash=fa2800f33aafa7c91e463da4017a08a6cf6c7d39f1fd8700ed1c444ed5cef348#)

,regionOfInterest=(981,663)&hash=4d4735059cc4c4b615911f464c7b575b0baeae84d724e35e70e7e545678eeca5#)

,regionOfInterest=(1052,620)&hash=d86daa22dd227a37a23f707db004fd490cbf0a35ab8e15249da28ffd65ec969c#)