Construye un Pipeline de Evaluación Automatizado para Soluciones de IA Generativa con Amazon Nova

Los modelos de lenguaje de gran tamaño (LLMs) han emergido como herramientas esenciales en una amplia gama de aplicaciones industriales, […]

Los modelos de lenguaje de gran tamaño (LLMs) han emergido como herramientas esenciales en una amplia gama de aplicaciones industriales, desde la mejora de la interacción con clientes hasta la automatización de procesos empresariales. Sin embargo, la implementación de estos modelos en escenarios reales presenta importantes retos, especialmente en términos de precisión, equidad, relevancia y la mitigación de las llamadas «alucinaciones» (cuando un modelo genera información incorrecta o engañosa). Una evaluación exhaustiva del rendimiento y de las salidas de estos modelos es vital para asegurar la confianza y seguridad en su utilización.

El papel de la evaluación en el ciclo de vida de las aplicaciones de inteligencia artificial generativa es crucial, similar al del aprendizaje automático tradicional. Disponer de metodologías de evaluación robustas permite tomar decisiones informadas sobre la selección de modelos y prompts. Pese a ello, la evaluación de los LLMs es un proceso complejo y demandante en recursos debido a su capacidad para generar texto libre. Si bien la evaluación humana otorga apreciaciones valiosas, resulta costosa y difícil de escalar, incrementando así la demanda por marcos de evaluación automatizados altamente escalables que pueden integrarse en el desarrollo de aplicaciones, al estilo de las pruebas unitarias y de integración en el desarrollo de software.

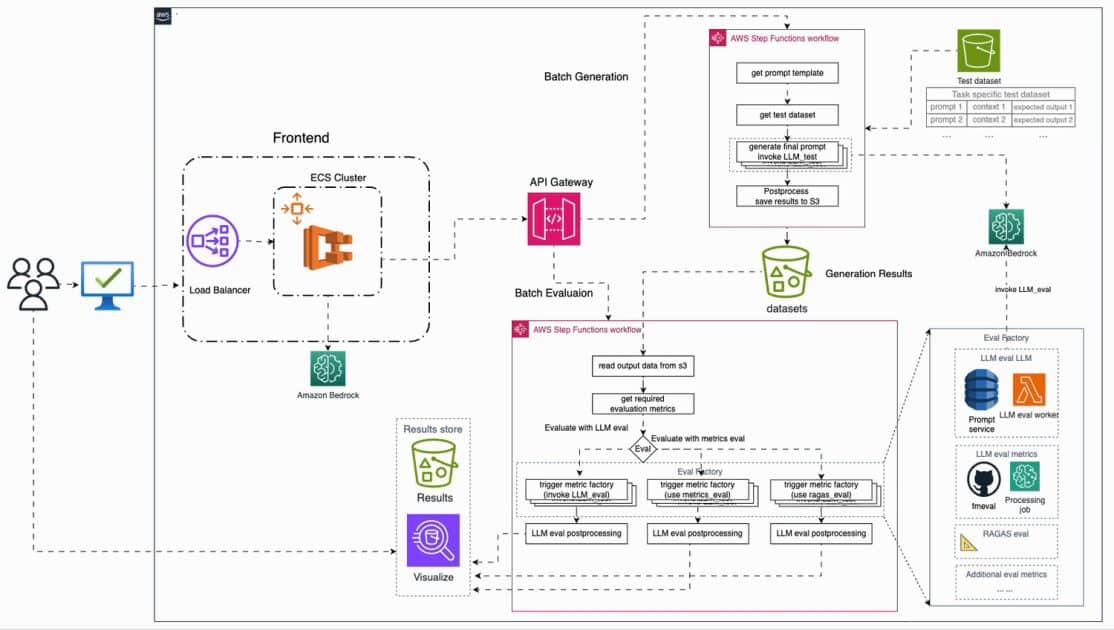

En respuesta a estos desafíos, se ha introducido un nuevo marco de evaluación automatizado que puede desplegarse en AWS. Este sistema facilita la integración de múltiples LLMs, el uso de métricas de evaluación personalizadas y permite una monitorización continua del rendimiento de los modelos. Se presentan métricas de evaluación como «LLM como juez», utilizando los nuevos modelos de Amazon Nova, que gracias a sus avanzadas capacidades y baja latencia, ofrecen evaluaciones escalables. Además, cuenta con una interfaz amigable que facilita su uso.

Antes de implementar procesos de evaluación para soluciones de inteligencia artificial generativa, es esencial establecer métricas y criterios claros de evaluación, así como reunir un conjunto de datos representativos. Este conjunto debe incluir muestras diversas y, si es posible, valores de verdad generados por expertos. El tamaño del conjunto de datos depende de la aplicación específica, pero debe abarcar casos relevantes y diversos. Este desarrollo puede ser un proceso iterativo, mejorado continuamente con nuevas muestras y enriquecido con ejemplos donde el rendimiento del modelo sea deficiente.

Las métricas de evaluación se categorizan generalmente en tres grandes áreas. Las métricas basadas en latencia comprenden medidas como el tiempo de generación de respuesta. El costo se refiere al gasto asociado con la generación de respuestas. Las métricas de rendimiento dependen altamente del caso y pueden incluir mediciones de precisión y consistencia fáctica de las respuestas generadas.

La evaluación de un modelo puede realizarse mediante un flujo de trabajo típico que abarca tanto evaluaciones en línea, manuales y cualitativas, como evaluaciones automatizadas en lotes y cuantitativas. Este enfoque puede introducir desafíos operativos significativos, lo que hace necesaria la existencia de herramientas de comparación, servicios de gestión de prompts y servicios de inferencia a gran escala, entre otros.

Con el lanzamiento de un sistema de evaluación automatizada de IA generativa en AWS, se busca simplificar el proceso de evaluación, optimizando así la productividad de los equipos durante el ciclo de desarrollo. Esta solución no solo permite una evaluación eficaz de los modelos de LLM en producción, sino que garantiza que las soluciones de inteligencia artificial generativa se mantengan actualizadas y optimizadas para cumplir con los criterios de precisión, equidad y relevancia.