Como usar os modelos de raciocínio de IA? Confira o guia

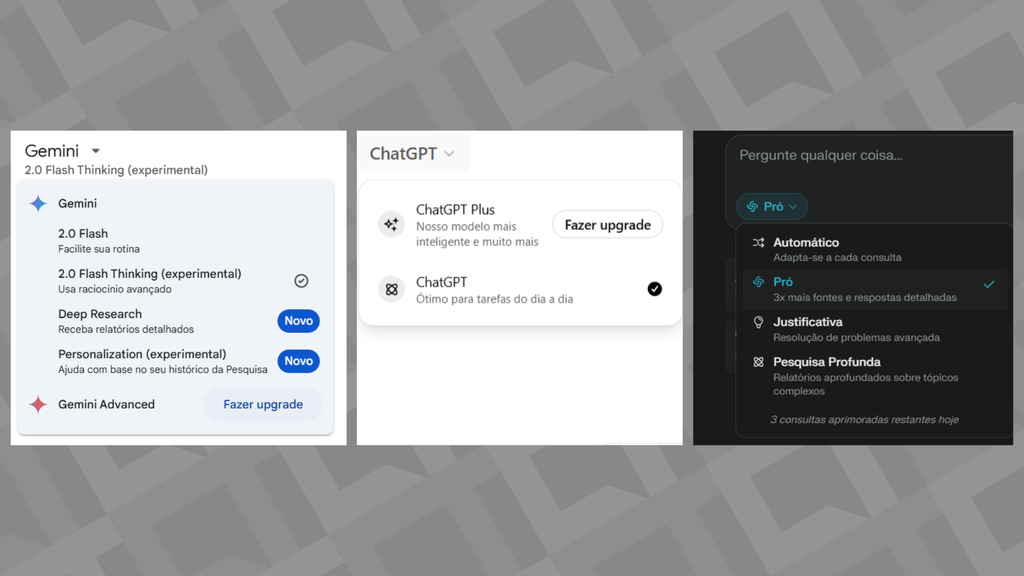

Na hora de usar assistentes de IA como ChatGPT e Gemini, é possível usar a versão padrão do chatbot ou optar pelos “modelos de raciocínio”, caso você tenha uma tarefa mais complexa. Esse tipo de tecnologia pode proporcionar resultados diferentes de uma resposta convencional das IAs, mas também exige comandos mais específicos. O que é alucinação de IA? Robô Ed e mais: relembre 5 chatbots que surgiram antes do ChatGPT Os novos lançamentos na indústria mostram que há uma segmentação ainda maior entre os modelos usados para “raciocinar” e aqueles focados em respostas rápidas para o dia a dia. Diante desse cenário, o Canaltech tira algumas dúvidas sobre o tema: O que são modelos de raciocínio Quais as diferenças para o modelo convencional? Quando usar um modelo de raciocínio? Dicas de prompts O que são modelos de raciocínio? Primeiramente, é preciso entender o que são os modelos de linguagem de IA, também chamados de LLMs (“Large Language Models”, ou “Grandes Modelos de Linguagem”, em tradução livre). Tratam-se de modelos de aprendizado de máquina treinados com extensas bases de dados, incluindo livros, sites e artigos científicos, e programados para entenderem e gerarem conteúdo com base em linguagem natural. -Entre no Canal do WhatsApp do Canaltech e fique por dentro das últimas notícias sobre tecnologia, lançamentos, dicas e tutoriais incríveis.- Os modelos de raciocínio são variações treinadas para terem maior adaptabilidade, dessa forma conseguem atender a comandos complexos e “pensar” uma resposta antes de criá-la. É comum que as opções disponíveis no mercado criem um passo a passo do caminho encontrado até a resposta final, como se simulasse um processo de raciocínio, e mostrem isso ao usuário. No lugar de gerar uma resposta rápida, por exemplo, essas IAs detalham todo o processo e realizam uma tarefa de cada vez até o resultado final, o que pode levar mais tempo. Alguns modelos de raciocínio populares no mercado são: Google Gemini 2.0 Flash Thinking; OpenAI o1 e OpenAI o3; Claude Sonnet 3.7 (considerado um modelo híbrido com tarefas conversacionais e de raciocínio); DeepSeek R1 (modo DeepThink). Quais as diferenças para o modelo convencional? A principal diferença está no processo de elaborar a resposta, como explica o especialista de IA e Program Manager da Alura, Fabrício Carraro. Os modelos tradicionais, como Gemini 2.0 e GPT-4.0, são desenvolvidos para gerarem respostas rápidas e fluidas logo após o prompt, e por isso podem ter limitações para tarefas mais elaboradas. Já os modelos de raciocínio demoram mais para responder porque “destrincham” a resposta em diferentes etapas, o que também permite chegar a novos resultados. “O uso dos modelos é praticamente o mesmo, mas os modelos de raciocínio tendem a oferecer respostas superiores para determinadas tarefas. Isso acontece porque essas abordagens têm um tempo adicional para 'pensar', em vez de simplesmente começarem a gerar uma resposta imediatamente após o prompt. Esse processo melhora a coerência e a precisão das respostas, tornando-os mais eficazes para desafios que demandam um raciocínio mais estruturado”, explica Carraro. Os modelos convencionais também são mais versáteis e multimodais, então aceitam diferentes comandos de entrada e podem gerar imagens ou textos, por exemplo. Vale destacar que a maioria das opções voltada para raciocínios faz parte de serviços pagos ou tem limitações na versão gratuita, visto que exigem maior poder computacional, então o acesso é mais limitado. Da esquerda para a direita: Gemini, ChatGPT e Perplexity trazem opções para maior raciocínio nas respostas (Imagem: Captura de tela/André Magalhães/Canaltech) Quando usar um modelo de raciocínio? Modelos como o Gemini Flash Thinking ou o OpenAI o1 são recomendados para prompts mais extensos ou tarefas mais complicadas, como resolver exercícios de lógica, montar relatórios ou tirar dúvidas avançadas sobre programação. Fabrício Carraro explica que os prompts que exijam uma análise maior podem ser beneficiados pelos modelos de raciocínio, enquanto as versões padrões são recomendadas para tarefas rápidas ou criativas. “Os modelos tradicionais são mais indicados para atividades como criação e resumo de textos, integração com sistemas empresariais e chatbots, pois priorizam a fluidez e a adaptação contextual. Em contrapartida, os modelos de raciocínio se destacam na resolução de problemas matemáticos complexos, na análise de questões lógicas e de programação, na tomada de decisões estratégicas e na avaliação detalhada de informações que exigem clareza contextual”, comenta. A OpenAI também já explicou as diferenças entre as duas frentes no lançamento do GPT-4.5. Segundo a empresa, essa variante “não pensa antes de responder” e por isso tem pontos positivos diferentes do que o o1. Em comparação com as versões o1 e o3-mini, o GPT-4.5 seria um “modelo mais geral e inatamente mais inteligente”. Dicas de prompts Na hora de interagir co

Na hora de usar assistentes de IA como ChatGPT e Gemini, é possível usar a versão padrão do chatbot ou optar pelos “modelos de raciocínio”, caso você tenha uma tarefa mais complexa. Esse tipo de tecnologia pode proporcionar resultados diferentes de uma resposta convencional das IAs, mas também exige comandos mais específicos.

Os novos lançamentos na indústria mostram que há uma segmentação ainda maior entre os modelos usados para “raciocinar” e aqueles focados em respostas rápidas para o dia a dia. Diante desse cenário, o Canaltech tira algumas dúvidas sobre o tema:

- O que são modelos de raciocínio

- Quais as diferenças para o modelo convencional?

- Quando usar um modelo de raciocínio?

- Dicas de prompts

O que são modelos de raciocínio?

Primeiramente, é preciso entender o que são os modelos de linguagem de IA, também chamados de LLMs (“Large Language Models”, ou “Grandes Modelos de Linguagem”, em tradução livre). Tratam-se de modelos de aprendizado de máquina treinados com extensas bases de dados, incluindo livros, sites e artigos científicos, e programados para entenderem e gerarem conteúdo com base em linguagem natural.

-

Entre no Canal do WhatsApp do Canaltech e fique por dentro das últimas notícias sobre tecnologia, lançamentos, dicas e tutoriais incríveis.

-

Os modelos de raciocínio são variações treinadas para terem maior adaptabilidade, dessa forma conseguem atender a comandos complexos e “pensar” uma resposta antes de criá-la. É comum que as opções disponíveis no mercado criem um passo a passo do caminho encontrado até a resposta final, como se simulasse um processo de raciocínio, e mostrem isso ao usuário.

No lugar de gerar uma resposta rápida, por exemplo, essas IAs detalham todo o processo e realizam uma tarefa de cada vez até o resultado final, o que pode levar mais tempo. Alguns modelos de raciocínio populares no mercado são:

- Google Gemini 2.0 Flash Thinking;

- OpenAI o1 e OpenAI o3;

- Claude Sonnet 3.7 (considerado um modelo híbrido com tarefas conversacionais e de raciocínio);

- DeepSeek R1 (modo DeepThink).

Quais as diferenças para o modelo convencional?

A principal diferença está no processo de elaborar a resposta, como explica o especialista de IA e Program Manager da Alura, Fabrício Carraro. Os modelos tradicionais, como Gemini 2.0 e GPT-4.0, são desenvolvidos para gerarem respostas rápidas e fluidas logo após o prompt, e por isso podem ter limitações para tarefas mais elaboradas.

Já os modelos de raciocínio demoram mais para responder porque “destrincham” a resposta em diferentes etapas, o que também permite chegar a novos resultados.

“O uso dos modelos é praticamente o mesmo, mas os modelos de raciocínio tendem a oferecer respostas superiores para determinadas tarefas. Isso acontece porque essas abordagens têm um tempo adicional para 'pensar', em vez de simplesmente começarem a gerar uma resposta imediatamente após o prompt. Esse processo melhora a coerência e a precisão das respostas, tornando-os mais eficazes para desafios que demandam um raciocínio mais estruturado”, explica Carraro.

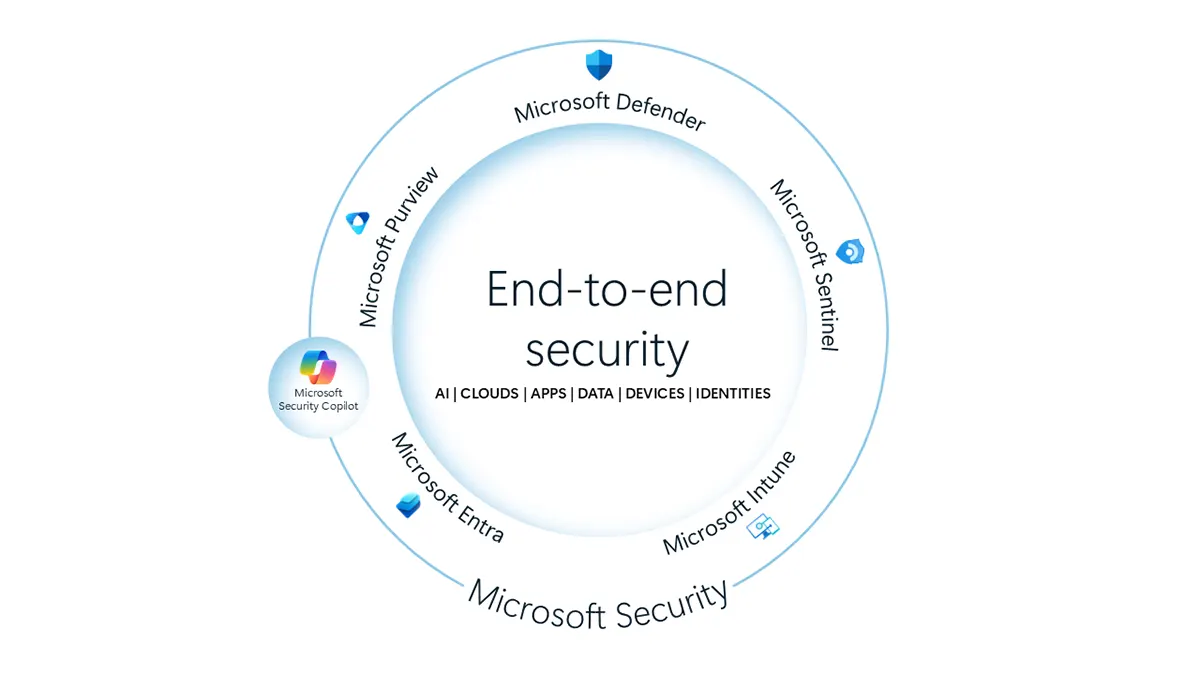

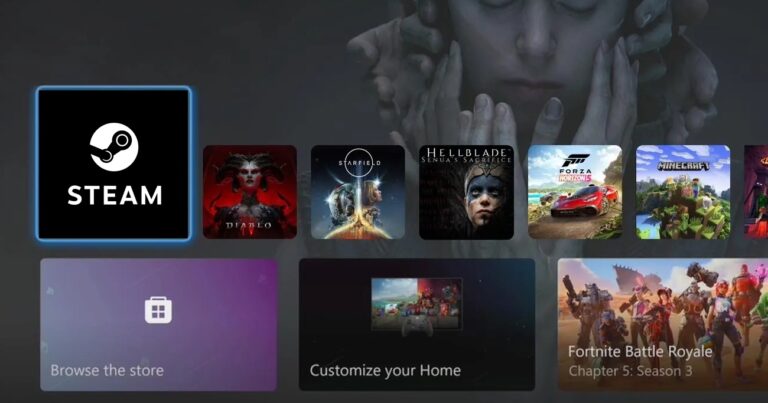

Os modelos convencionais também são mais versáteis e multimodais, então aceitam diferentes comandos de entrada e podem gerar imagens ou textos, por exemplo. Vale destacar que a maioria das opções voltada para raciocínios faz parte de serviços pagos ou tem limitações na versão gratuita, visto que exigem maior poder computacional, então o acesso é mais limitado.

Quando usar um modelo de raciocínio?

Modelos como o Gemini Flash Thinking ou o OpenAI o1 são recomendados para prompts mais extensos ou tarefas mais complicadas, como resolver exercícios de lógica, montar relatórios ou tirar dúvidas avançadas sobre programação.

Fabrício Carraro explica que os prompts que exijam uma análise maior podem ser beneficiados pelos modelos de raciocínio, enquanto as versões padrões são recomendadas para tarefas rápidas ou criativas.

“Os modelos tradicionais são mais indicados para atividades como criação e resumo de textos, integração com sistemas empresariais e chatbots, pois priorizam a fluidez e a adaptação contextual. Em contrapartida, os modelos de raciocínio se destacam na resolução de problemas matemáticos complexos, na análise de questões lógicas e de programação, na tomada de decisões estratégicas e na avaliação detalhada de informações que exigem clareza contextual”, comenta.

A OpenAI também já explicou as diferenças entre as duas frentes no lançamento do GPT-4.5. Segundo a empresa, essa variante “não pensa antes de responder” e por isso tem pontos positivos diferentes do que o o1. Em comparação com as versões o1 e o3-mini, o GPT-4.5 seria um “modelo mais geral e inatamente mais inteligente”.

Dicas de prompts

Na hora de interagir com uma versão focada em raciocínio, é importante criar um prompt muito detalhado e polido com todas as suas intenções. O presidente da OpenAI, Greg Brockman, já comentou que a variante o1 é um tipo diferente de IA e “a melhor performance requer o uso de uma nova forma em relação aos modelos padrões de chats”.

Uma dica importante é não poupar caracteres e fazer comandos extensos, para que tenham todas as informações que você precise. Comece com o objetivo geral, depois entre em detalhes sobre a forma em que a pesquisa precisa ser feita, como os resultados devem ser exibidos, quais são possíveis ressalvas e qual é o contexto para fazer o pedido.

Outra dica é pedir para a própria IA refinar o prompt para você: é possível usar os modelos padrões, por exemplo, e perguntar quais informações são necessárias para criar um comando mais completo.

Leia também:

- DeepSeek vs Gemini: conheça 5 diferenças entre os chatbots

- OpenAI Operator, Copilot e mais: conheça 4 agentes de IA

- Perplexity e ChatGPT: conheça 5 diferenças entre as IAs

VÍDEO: IAs que resumem documentos

Leia a matéria no Canaltech.