Las estafas con IA crecieron 300% en la Argentina, cómo se blindan las empresas de los ataques

La IA generativa es la tecnología de base que permite estos fraudes audiovisuales hiperrealistas. Cómo pueden combatirse y qué están haciendo los expertos de ciberseguridad para anticiparse al problema.

Un ejecutivo de alto rango, a través de una videollamada, solicita a sus colaboradores que se realice una transferencia inmediata. El responsable de ciberseguridad pide a su equipo modificaciones en las claves de acceso a los sistemas críticos. Un postulante con antecedentes graves accede a un puesto de trabajo ocultando su verdadera identidad durante las entrevistas.

¿Qué tienen en común estos tres escenarios, que no son otra cosa que unos pocos ejemplos de un abanico infinito? Que, en todos los casos, se pueden manipular con IA generativa. No se trata de ciencia ficción: en febrero del año pasado se reportó en Hong Kong un caso en el que un empleado de finanzas transfiriera u$s 25 millones a una cuenta fantasma luego de haber recibido la orden por parte de su superior inmediato.

Entramos de lleno en lo que se conoce como la era de los deepfakes, audios, videos e imágenes generados por IA que imitan a una persona con tal precisión que resulta casi imposible distinguir la realidad de la ficción. No por nada, la consultora de mercado Gartner colocó "seguridad de la desinformación" como una de las diez principales tendencias tecnológicas de este 2025. ¿De qué manera deben reconfigurar las organizaciones sus escenarios de protección para contemplar esta nueva amenaza?

Las estafas de phishing con videos generados por IA y utilizando personas públicas conocidas como influencers y actores aumentaron 140 por ciento en 2024 en comparación con el año anterior en Latinoamérica, según el Panorama de Amenazas elaborado por la empresa de ciberseguridad Kaspersky. La Argentina figura entre los países donde el incremento fue más notable: 300 por ciento.

"Cuando se reciben mensajes de conocidos o personas de nuestro trabajo que solicitan información personal o financiera, la única protección es la educación digital y la verificación de la información", apunta Isabel Manjarrez, investigadora de seguridad en Kaspersky. "Lo mejor es verificar cualquier solicitud de un de un supuesto jefe mediante una vía de comunicación diferente a la que usa el potencial atacante, como una plataforma corporativa o una llamada telefónica", aconseja.

"Puede no parecerlo, pero el cambio de ‘no creas todo lo que lees' a ‘no creas todo lo que ves o escuchas' es significativo: la capacidad de falsificar contenidos de forma realista obliga a repensar cómo se valida lo que consumimos", afirma Martina López, investigadora de seguridad informática de ESET Latinoamérica. "Cuanto más avance la tecnología que permite generar (entre otras cosas) estas falsificaciones, más compleja será su identificación por el ojo humano: las formas de detección simples de hoy no funcionarán mañana, y que debemos centrarnos en corroborar estas piezas de información de modos que no incluyan el poder distinguir si es falso o no", agrega. Isabel Manjarrez, investigadora de seguridad en Kaspersky.

Deepfakes para todos y todas

"Hoy se puede acceder de forma gratuita o por una suscripción mínima a sitios que permiten generar este contenido y que se encuentran al alcance de todos", aporta Gustavo Pontoriero, responsable de ciberseguridad en la Nubiral, empresa que brinda soluciones de transformación digital. "Las organizaciones deben adoptar un enfoque proactivo, estableciendo procedimientos internos de verificación en comunicaciones sensibles y reforzando la monitorización de su huella digital para detectar posibles intentos de manipulación", recomienda.

"En este escenario en constante evolución, la ciberseguridad no es un destino, sino un camino de mejora continua", define Fabio Grigorjev, chief artificial intelligence officer (CAIO) de Evoltis, empresa especializada en soluciones de experiencia del cliente. El experto considera algunas líneas de acción clave para reconfigurar la estrategia de ciberseguridad que incluye un enfoque proactivo y colaborativo, formación y concientización y autenticación reforzada.

También, avanzar sobre la protección de datos e identidades, con un enfoque zero trust para restringir el acceso y evitar movimientos laterales de los atacantes en caso de una brecha de seguridad y sellos de autenticidad y trazabilidad en contenido audiovisual para detectar manipulaciones. "No basta con verificar que un rostro pestañea: los nuevos filtros deben detectar señales vitales como la circulación sanguínea", explica.

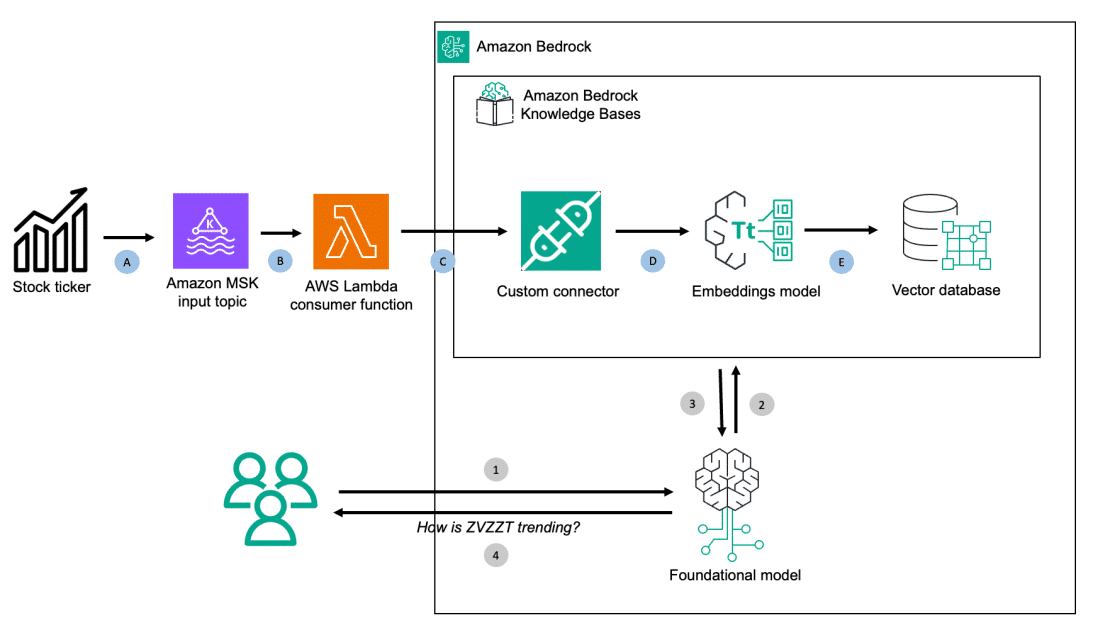

"Hasta ahora, la autenticación de identidad y la verificación de información dependían en gran medida de factores visuales y auditivos, pero con la sofisticación de las deepfakes esas señales ya no son confiables", apunta Néstor Markowicz, COO de Certisur. "Esto exige la implementación de nuevas capas de seguridad basadas en IA para la detección de fraudes, autenticación multifactor (MFA) reforzada y mayor control en los procesos de verificación digital". La empresa, que ofrece servicios de confianza para garantizar la seguridad en línea, está siguiendo de cerca nuevas tecnologías como Content Authenticity Initiative (CAI), que apunta a crear un sistema que asegure de punta a punta la procedencia de un contenido digital evitando su manipulación.

Múltiples vectores de ataque

"Hoy enfrentamos a múltiples vectores de ataque en este espacio: desde currículums, entrevistas, contratistas, socios de negocios, suplantación de identidades de directivos y ataques de desinformación que afectan la reputación de las empresas", enumera Martín Sajón, CEO de /q99, startup argentina de investigación y desarrollo aplicada, especializada en la convergencia entre la IA y la computación cuántica. Martín Sajón, CEO de /q99.

"Es fundamental contar con un plan de respuesta a incidentes específico para deepfakes que incluya procedimientos de escalamiento claros, un equipo de respuesta designado, protocolos de comunicación en crisis y una coordinación efectiva con el departamento legal", sostiene.

"Identificar el próximo movimiento de los atacantes es una de las mayores preocupaciones de los CISO, tanto herramientas de monitoreo y respuesta ante incidentes para controlar los ataques y automatizar actividades de respuesta en la contención", destaca Miguel Rodríguez, chief information security officer (CISO) del proveedor de infraestructura digital Cirion. "Se vuelve imperativo que las empresas accedan a plataformas de inteligencia de amenazas e implementen el monitoreo de la marca y la infraestructura para detectar actividades sospechosas: la detección temprana puede ayudar a mitigar el impacto de los incidentes y las vulnerabilidades", agrega.

"El peligro que representan para las medidas de seguridad biométricas ha impulsado la búsqueda de métodos de autenticación más robustos y multimodales", expresa Walter Quiroga, jefe de seguridad de la información de Metrotel. "Además, se recomienda mantener el software actualizado, asegurando que el sistema operativo y software tengan los últimos parches de seguridad, e instalar software antivirus, antimalware o XDR (extended detection and response) con IA integrado, que puede ayudar a proteger contra malware que se utiliza para crear deepfakes".

También emergen las certificaciones de contenido oficial. "Tecnologías como marcas de agua digitales y blockchain pueden ayudar a verificar su autenticidad", destaca Sajón.

¡Fuera de las redes!

Pero hay un paso previo antes de incorporar tanta protección: dejar de exponerse. "Las empresas con presencia pública, incluidos los ejecutivos que realizan entrevistas o charlas en público, proporcionan una gran cantidad de datos de entrenamiento que pueden ser utilizados por los ciberdelincuentes para crear personajes falsos". Indica Satnam Narang, ingeniero de investigación senior en Tenable, empresa especializada en gestionar de qué manera las organizaciones quedan expuestas a riesgos y amenazas.

"Es imposible pedir a estos ejecutivos que cesen en sus funciones laborales habituales, por lo que contar con un proceso adecuado, la participación de múltiples partes interesadas y establecer un período de espera antes de tomar cualquier acción significativa (como la transferencia de millones de dólares) sirve para detener algunos de los escenarios de ataque más comunes", agrega. Satnam Narang, ingeniero de investigación senior en Tenable.

"Es importante limitar la exposición de información personal en redes sociales y entornos públicos para reducir la cantidad de material disponible para la creación de deepfakes creíbles, mientras que en procesos críticos dentro de las empresas se deben establecer protocolos de doble validación para confirmar cualquier comunicación o solicitud, evitando confiar únicamente en medios audiovisuales que pueden haber sido alterados", coincide.

"Dentro de las mismas redes sociales debemos evitar participar en juegos o aplicaciones donde damos autorización al uso de nuestra imagen y datos, mientras que otra buena práctica es implementar soluciones de verificación de identidad que utilicen biometría, autenticación de dos pasos y tecnologías de IA pueden ayudar a prevenir fraudes y suplantaciones", suma Octavio Mussi, manager de ciberseguridad de NTT DATA Argentina y Uruguay.

"La monitorización en tiempo real de menciones y contenido en redes sociales o canales de comunicación internos puede ayudar a identificar intentos de suplantación antes de que generen un daño significativo", aporta Sebastián Décima, responsable de desarrollo de la desarrolladora de soluciones de transformación digital Endava Rosario.

¿Me transferís a esta cuenta?

Por su naturaleza, las estafas con deepfakes podrían apuntar principalmente al mundo financiero. El Centro de Servicios Financieros de Deloitte predice que la IA generativa podría permitir que las pérdidas por fraude alcancen los u$s 40.000 millones en 2027 sólo en los Estados Unidos, lo que implica un crecimiento del 32 por ciento anual desde 2023.

"Si bien las deepfakes suponen nuevos desafíos en materia de ciberseguridad, el enfoque clave continúa puesto en la concientización para que los usuarios tengan la información y las herramientas necesarias que les permitan cuidarse de las ciberestafas", indica David Cirielli, CISO de MODO, la billetera virtual de los principales bancos de Argentina. "En nuestro caso, la estrategia de ciberseguridad no cambia con los deepfakes ya que el objetivo sigue siendo el mismo: proteger la identidad y la integridad de la información de nuestros usuarios", asegura.

El ejecutivo destaca que ya existen soluciones que expanden y mejoran la biometría conductual (como los análisis de micromovimientos involuntarios) de las personas a la hora de validar la identidad con prueba de vida. También se están adoptando enfoques cómo reemplazar la contraseña por una validación biométrica (huella o FaceID) asociada al dispositivo del usuario que ante cualquier mínimo cambio, rompe la vinculación y solicita validaciones adicionales. La empresa implementó en enero tecnologías de tokenización y autorización para pagos en QR con tarjetas Visa.

"Es crucial adaptar y fortalecer las estrategias de ciberseguridad para hacer frente a las amenazas que representan las deepfakes", coincide Javier Tepedino, jefe de seguridad informática de Banco del Sol, el banco digital de Sancor Seguros. La empresa combina tecnologías avanzadas y medidas preventivas para proteger la identidad de sus usuarios. Esto incluye autenticación biométrica, verificación de la identidad en el Renaper (Registro Nacional de las Personas) durante el onboarding y la posibilidad de asociar el dispositivo del cliente a la cuenta.

"También utilizamos IA para monitorear en tiempo real patrones anómalos en las transacciones y analizar el comportamiento del usuario, lo que nos permite detectar intentos de fraude de manera proactiva", comenta. Alberto Teskiewicz, coordinador de Desarrollo e Investigación en SIISA.

"En el caso de la industria financiera, más específicamente en las solicitudes de crédito, los sistemas de validación de identidad deben incorporar tecnologías avanzadas de detección, como análisis biométrico en vivo (liveness detection), comparaciones de múltiples factores y monitoreo de patrones de comportamiento que, integrados en un motor de decisiones, refuerce la evaluación crediticia de una persona y prevenga fraudes basados en identidades sintéticas (es decir, que combinan información real con otra generada automáticamente)", define Alberto Teskiewicz, coordinador de Desarrollo e Investigación en SIISA, empresa de tecnología que provee informes comerciales, scoring de crédito y de sensibilidad, todo con foco en el mercado financiero de lending.

El factor humano

Más allá de la tecnología, las deepfakes involucran una dificultad adicional: apuntan a explotar vulnerabilidades humanas como la empatía, la confianza, la curiosidad o, digámoslo también, la avaricia. "Muchas veces los ataques basados en deepfakes dependen de la confianza y el desconocimiento de las víctimas", puntualiza Pontoriero.

"Una respuesta tradicional incluiría más capacitación, protocolos y niveles de verificación, pero esto no considera la emoción humana inherente a este tipo de ataque, por lo que sugiero empezar pensando en una estrategia preventiva no basada en modelar solamente las amenazas y vulnerabilidades de los fallos técnicos sino en las vulnerabilidades humanas", destaca Luciano Moreira da Cruz, chief transformation & strategy office (CTSO) de Cloud Legion, empresa que promueve mejorar la posición competitiva y la eficiencia mediante el uso de tecnología de forma segura.

"Como sociedad estamos acostumbrados a confiar en lo que vemos con nuestros ojos y en lo que oímos con nuestros oídos pero con las tecnologías deepfake todo eso se puede falsificar y debemos advertir a nuestros empleados que desconfíen más y proporcionarles nuevas heurísticas con las que evaluar la información", relata.

La mayoría de los expertos consultados para este artículo coinciden con este diagnóstico. "Dado que estas amenazas explotan una vulnerabilidad humana, debemos implementar entrenamientos y campañas de concientización para capacitar a los empleados a reconocer señales de deepfakes y fomentar una cultura de ciberseguridad", advierte Leonel Navarro Segura, director de la práctica global de seguridad de la información en la empresa de ingeniería de software Softtek.

"Al final del día, lo más importante es la formación y la concientización de las personas, ya que juegan un papel fundamental para reconocer y responder a estas amenazas porque son también las principales víctimas", explica Mussi.

"La principal recomendación es dudar de todo sin volverse paranoico: hay que acostumbrarse a verificar las fuentes de información de manera continua", dice Julio Blanco, miembro de Interact, asociación argentina que nuclea a más de 90 agencias, consultoras y productoras del ecosistema digital. "Otra recomendación es seguir la intuición: parece una solución metafísica, pero la gran mayoría de las personas que pasaron por algo así comentan haber tenido el presentimiento de que no debían seguir adelante". Julio Blanco, miembro de Interact.

En este recorrido, emerge también un nuevo rol, el del director de confianza o chief trust officer. "Su función será garantizar que la organización mantenga altos estándares de seguridad, integridad y verificación de la información, especialmente en un contexto donde la falsificación digital es cada vez más creíble", sostiene Markowicz.

¿El remedio o la enfermedad?

Tal como ocurre con las vacunas, en la enfermedad podría estar el remedio, como se visualiza en iniciativas como DeepfakeTIMIT o XceptionNet, que utilizan la misma IA para combatir este flagelo.

"Los algoritmos de detección de deepfakes pueden identificar errores sutiles que son difíciles de detectar rápidamente a simple vista y la IA también puede ayudar a mejorar la transparencia y la confianza en el contenido digital, proporcionando herramientas para verificar la autenticidad de los videos y audios de manera dinámica y eficiente", apunta Mussi.

"Al igual que las herramientas utilizadas para desarrollar deepfakes, las anti-deepfake todavía se están trabajando: va a ser el juego del gato y el ratón", señala Narang. "Al menos, un aspecto tranquilizador de algunos de los deepfakes que hemos visto es que no siempre están ensamblados a la perfección: la observación de labios, cejas o gestos de las manos puede indicar que el contenido no es real", concluye. "Existen sistemas avanzados que detectan y analizan microexpresiones y variaciones de voz, dificultando su réplica y reduciendo el riesgo de suplantación", aporta Sajón.

"Los algoritmos de IA pueden analizar marcas o patrones en imágenes, videos y audios para identificar señales de manipulación", agrega Pontoriero. "Incluso, existe la IA explicativa, que no solo detecta deepfakes, sino que también explica cómo llegó a esa conclusión, facilitando su interpretación", dice Manjarrez.

Para Sajón, la IA no es suficiente por sí sola para defenderse de este fenómeno y requiere de herramientas y procesos complementarios para establecer una estrategia de defensa en profundidad, incluyendo "la participación en grupos de trabajo y foros especializados permite compartir información sobre nuevas amenazas y técnicas de detección, fortaleciendo la capacidad de respuesta colectiva".

"Estoy seguro de que, tras cada nueva amenaza de la IA, los profesionales de seguridad utilizan la misma IA para protegerte, pero tengamos en cuenta que los humanos todavía estamos por encima de la IA: tenemos instintos viscerales y podemos sentir cuando algo parece, se siente o suena raro", concluye Moreira da Cruz.