IA letal sin regulación: alertan de los 'robots asesinos' capaces de matar por su cuenta

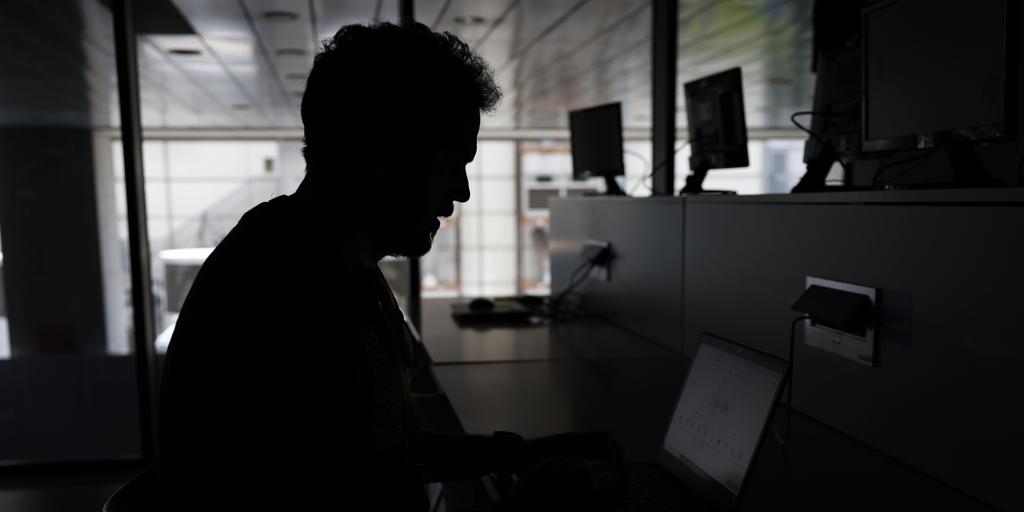

Es el 27 de marzo de 2020. Después de más de diez años de guerra civil en Libia, el por entonces primer ministro, Fayez al Sarraj, da inicio a la Operación Tormenta de Paz, con la que espera acabar finalmente con la resistencia en el litoral del país. Y funcionó, los rebeldes acabaron replegando posiciones; y durante el enfrentamiento, de acuerdo con un informe de la ONU , se podría haber recurrido a armamento inteligente capaz de acabar con la vida de una persona sin necesidad de que ningún humano de la orden. Es decir, un 'killer robot'. Un 'robot asesino'. Desde hace años varios países dedican muchos recursos al desarrollo de armas 'con cerebro' capaces de tomar decisiones, ya sea en forma de dron, barco, tanque o de munición de merodeo , capaz de esperar a que aparezca un objetivo antes de lanzarse contra este. A pesar de los llamamientos realizados por parte de políticos, científicos y activistas para controlar el uso y fabricación de esta clase de armamento, capaz de acabar con vidas por decisión propia, no se han logrado grandes avances en materia de regulación. Y eso le preocupa, y mucho, a Mary Wareham, directora de la división de Crisis, Conflictos y Armas de la ONG Human Rights Watch (HRW), organización lleva alertando sobre el desarrollo y sus peligros desde hace más de una década. «Estos sistemas de armas, una vez activados, usan inteligencia artificial (IA) e información de sensores como cámaras, señales de radar o de calor y otros datos para identificar un objetivo. Tras encontrarlo, disparan o liberan su carga sin necesidad de aprobación ni revisión por parte de un operador humano. Esto significa que es una máquina, y no un humano, quien determina dónde, cuándo y contra qué se usa la fuerza», señala Wareham a ABC. «Permitir que las máquinas arrebaten vidas humanas en el campo de batalla o a nivel policial traspasa una línea moral y plantea diversas preocupaciones legales, éticas, de seguridad y tecnológicas», remarca la directiva de la ONG. HRW acaba de compartir un nuevo informe sobre la situación de esta tecnología movida por IA en colaboración con la Universidad de Harvard. Con el documento se busca aumentar la concienciación sobre el riesgo de su avance antes de la celebración los próximos 12 y 13 de mayo de la primera reunión de la Asamblea General de la ONU sobre sistemas de armas autónomas. En el informe, de 61 páginas, se remarca que el uso de armas autónomas no solo puede generar problemas en tiempos de guerra, sino también en los de paz; por ejemplo, si se acaba empleando para el control de manifestaciones populares pacíficas. También se teme el empleo de la tecnología para la creación de sistemas de vigilancia masiva que podrían comprometer la privacidad de los ciudadanos recopilando y procesando sus datos. La conclusión es clara: a juicio de la ONG, el uso de este tipo de armamento puede ir en contra del derecho a la vida, la reunión pacífica, la privacidad y la reparación , así como a los principios de dignidad humana y no discriminación. De este modo, se solicita que los países inicien «lo antes posible» negociaciones para la elaboración de un tratado internacional que lo regule y prohíba. Wareham señala que, actualmente, los grandes potencias armamentísticas representan los principales escoyos para legislar y poner cotos a las máquinas, y, evidentemente, también parece que son los que cuentan con más tecnología de esta clase: «Existe poca transparencia en el desarrollo de sistemas de armas autónomas, por lo que no es posible determinar qué países poseen la mayor cantidad, los estados que parecen estar invirtiendo más en sistemas de armas autónomas serían China, India, Israel, Corea del Sur, Rusia, Turquía y Estados Unidos». La directiva apunta que en 2021, dentro del conflicto del Alto Karabaj entre Armenia y Azerbaiyán, también fue empleado armamento de esta clase. En concreto «diversas municiones de merodeo, como el Harop, desarrollado por Israel Aerospace Industries». A pesar de que sigue sin encontrarse solución al problema, desde la ONG se pone en valor los «avances significativos» que se han conseguido en la última década «para concienciar sobre los peligros que plantean los sistemas». Desde 2014, la Convención sobre Armas Convencionales (CCW) en Ginebra ha servido como foro para el debate sobre 'robots asesinos'; sin embargo, para la toma de decisiones regulatorias dentro del marco de la convención hacía falta un consenso total entre los países que la conforman. Algo que ha sido imposible. «(En la CCW) un solo país puede rechazar una propuesta, incluso si todos los demás países la aprueban. Un puñado de grandes potencias militares que invierten en sistemas de armas autónomas —en particular, India, Israel, Rusia y Estados Unidos— han aprovechado este proceso para bloquear repetidamente las propuestas de negociación de un instrumento jurídicamente vinculante», dice Wareham. Humans Right Now se muestra esperanzada por los avances que se puedan realizar en la primera reunió

Es el 27 de marzo de 2020. Después de más de diez años de guerra civil en Libia, el por entonces primer ministro, Fayez al Sarraj, da inicio a la Operación Tormenta de Paz, con la que espera acabar finalmente con la resistencia en el litoral del país. Y funcionó, los rebeldes acabaron replegando posiciones; y durante el enfrentamiento, de acuerdo con un informe de la ONU , se podría haber recurrido a armamento inteligente capaz de acabar con la vida de una persona sin necesidad de que ningún humano de la orden. Es decir, un 'killer robot'. Un 'robot asesino'. Desde hace años varios países dedican muchos recursos al desarrollo de armas 'con cerebro' capaces de tomar decisiones, ya sea en forma de dron, barco, tanque o de munición de merodeo , capaz de esperar a que aparezca un objetivo antes de lanzarse contra este. A pesar de los llamamientos realizados por parte de políticos, científicos y activistas para controlar el uso y fabricación de esta clase de armamento, capaz de acabar con vidas por decisión propia, no se han logrado grandes avances en materia de regulación. Y eso le preocupa, y mucho, a Mary Wareham, directora de la división de Crisis, Conflictos y Armas de la ONG Human Rights Watch (HRW), organización lleva alertando sobre el desarrollo y sus peligros desde hace más de una década. «Estos sistemas de armas, una vez activados, usan inteligencia artificial (IA) e información de sensores como cámaras, señales de radar o de calor y otros datos para identificar un objetivo. Tras encontrarlo, disparan o liberan su carga sin necesidad de aprobación ni revisión por parte de un operador humano. Esto significa que es una máquina, y no un humano, quien determina dónde, cuándo y contra qué se usa la fuerza», señala Wareham a ABC. «Permitir que las máquinas arrebaten vidas humanas en el campo de batalla o a nivel policial traspasa una línea moral y plantea diversas preocupaciones legales, éticas, de seguridad y tecnológicas», remarca la directiva de la ONG. HRW acaba de compartir un nuevo informe sobre la situación de esta tecnología movida por IA en colaboración con la Universidad de Harvard. Con el documento se busca aumentar la concienciación sobre el riesgo de su avance antes de la celebración los próximos 12 y 13 de mayo de la primera reunión de la Asamblea General de la ONU sobre sistemas de armas autónomas. En el informe, de 61 páginas, se remarca que el uso de armas autónomas no solo puede generar problemas en tiempos de guerra, sino también en los de paz; por ejemplo, si se acaba empleando para el control de manifestaciones populares pacíficas. También se teme el empleo de la tecnología para la creación de sistemas de vigilancia masiva que podrían comprometer la privacidad de los ciudadanos recopilando y procesando sus datos. La conclusión es clara: a juicio de la ONG, el uso de este tipo de armamento puede ir en contra del derecho a la vida, la reunión pacífica, la privacidad y la reparación , así como a los principios de dignidad humana y no discriminación. De este modo, se solicita que los países inicien «lo antes posible» negociaciones para la elaboración de un tratado internacional que lo regule y prohíba. Wareham señala que, actualmente, los grandes potencias armamentísticas representan los principales escoyos para legislar y poner cotos a las máquinas, y, evidentemente, también parece que son los que cuentan con más tecnología de esta clase: «Existe poca transparencia en el desarrollo de sistemas de armas autónomas, por lo que no es posible determinar qué países poseen la mayor cantidad, los estados que parecen estar invirtiendo más en sistemas de armas autónomas serían China, India, Israel, Corea del Sur, Rusia, Turquía y Estados Unidos». La directiva apunta que en 2021, dentro del conflicto del Alto Karabaj entre Armenia y Azerbaiyán, también fue empleado armamento de esta clase. En concreto «diversas municiones de merodeo, como el Harop, desarrollado por Israel Aerospace Industries». A pesar de que sigue sin encontrarse solución al problema, desde la ONG se pone en valor los «avances significativos» que se han conseguido en la última década «para concienciar sobre los peligros que plantean los sistemas». Desde 2014, la Convención sobre Armas Convencionales (CCW) en Ginebra ha servido como foro para el debate sobre 'robots asesinos'; sin embargo, para la toma de decisiones regulatorias dentro del marco de la convención hacía falta un consenso total entre los países que la conforman. Algo que ha sido imposible. «(En la CCW) un solo país puede rechazar una propuesta, incluso si todos los demás países la aprueban. Un puñado de grandes potencias militares que invierten en sistemas de armas autónomas —en particular, India, Israel, Rusia y Estados Unidos— han aprovechado este proceso para bloquear repetidamente las propuestas de negociación de un instrumento jurídicamente vinculante», dice Wareham. Humans Right Now se muestra esperanzada por los avances que se puedan realizar en la primera reunión de la Asamblea General de la ONU sobre sistemas de armas autónomas del próximo mayo. «Abordar el desafío de los robots asesinos bajo los auspicios de la Asamblea General de la ONU también permitiría una mayor consideración de preocupaciones que se han pasado por alto en gran medida en los debates anteriores, como la ética, los derechos humanos, la proliferación y los impactos en la seguridad global y la estabilidad regional e internacional, incluyendo el riesgo de una carrera armamentista y la reducción del umbral de conflicto», completa la directiva.

Publicaciones Relacionadas

.jpg)

.jpg)