Riviera, Intel Corp.: «Le nuove strategie di investimento con l’AI»

L’intelligenza artificiale trasforma il settore finanziario, modificando profondamente le strategie di investimento e le dinamiche dei Mercati. «Lo scopo dell’innovazione è proprio quello di aumentare l’efficienza dei Mercati, riducendone al minimo la volatilità. Lo stesso discorso vale oggi per l’AI applicata alla finanza, anche se siamo ancora alle fasi iniziali di questo percorso», dice Walter […] L'articolo Riviera, Intel Corp.: «Le nuove strategie di investimento con l’AI» proviene da ilBollettino.

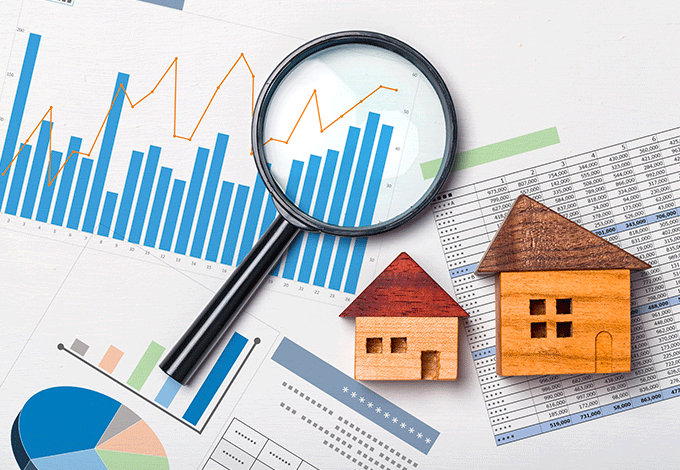

L’intelligenza artificiale trasforma il settore finanziario, modificando profondamente le strategie di investimento e le dinamiche dei Mercati.

«Lo scopo dell’innovazione è proprio quello di aumentare l’efficienza dei Mercati, riducendone al minimo la volatilità. Lo stesso discorso vale oggi per l’AI applicata alla finanza, anche se siamo ancora alle fasi iniziali di questo percorso», dice Walter Riviera, AI Tech Lead EMEA Intel Corporation.

In questa sfida tecnologica globale, l’Europa adotta un approccio prudente e orientato alla regolamentazione, con particolare attenzione alla protezione dei cittadini e alla privacy. E l’Italia? Anche nel panorama nazionale emergono realtà innovative e approcci originali, che testimoniano il ruolo sempre più rilevante del Paese nella definizione delle nuove regole del gioco.

In che modo l’intelligenza artificiale sta trasformando le strategie di investimento nel settore finanziario?

«L’intelligenza artificiale non è tanto una nuova attività, quanto un nuovo modo per svolgere attività già esistenti. Nel campo degli investimenti, l’AI mette a disposizione strumenti utili per analizzare e interpretare grandi quantità di dati, ad esempio estraendo il sentiment presente sul web. Ciò consente oggi di misurare testi e linguaggi che prima sarebbe stato impossibile analizzare manualmente. Uno degli utilizzi principali riguarda la previsione dei rischi e dei movimenti dei listini. Nei Mercati azionari, infatti, esistono schemi ricorrenti che l’AI aiuta a riconoscere e valutare, assegnando probabilità sul ripetersi di determinati pattern.

Occorre però andare oltre l’attuale tendenza a identificare l’intelligenza artificiale solo con la generazione di contenuti (immagini, testi, video). In realtà, un utilizzo importante, già ampiamente sfruttato in ambito finanziario, riguarda proprio le capacità predittive e classificatorie. Un aspetto peculiare delle applicazioni finanziarie, soprattutto nel trading, è la necessità di algoritmi veloci. Spesso, infatti, sono preferiti modelli di machine learning più semplici ma rapidi rispetto a modelli più sofisticati di deep learning, che risultano più precisi ma anche più lenti e onerosi in termini computazionali».

Quali strategie di investimento stanno emergendo per ottimizzare il rapporto tra rischio e rendimento?

«La domanda può essere affrontata da due prospettive differenti. Da un punto di vista macroscopico, abbiamo una parte del Mercato che sta investendo ingenti somme nello sviluppo di tecnologie AI proprietarie, puntando a ottenere ritorni che giustifichino tali investimenti. Dall’altra, invece, emergono sempre più strumenti pubblici e gratuiti, open source, in grado di competere per efficacia con quelli privati.

Nel contesto attuale, quindi, un approccio strategico interessante potrebbe essere quello di cercare aziende e Startup orientate all’open source, che sappiano però conciliare questa apertura con modelli di business sostenibili. L’esempio recente di DeepSeek, che ha scosso il Mercato mostrando performance competitive rispetto alle tecnologie statunitensi, evidenzia proprio il valore e l’attrattività di questo paradigma.

Un altro aspetto cruciale riguarda l’utilizzo di sistemi automatizzati per operazioni di trading. Ma l’automazione può generare rischi significativi: algoritmi capaci di compiere rapide predizioni sui movimenti azionari tendono ad acquistare o vendere automaticamente, creando potenziali bias e distorsioni nel Mercato. Questo scenario potrebbe paradossalmente aumentare l’incertezza. In definitiva, la chiave per ottimizzare il rapporto rischio-rendimento tramite l’intelligenza artificiale risiede nella capacità di combinare efficacemente strumenti predittivi e analisi approfondite: interpretare correttamente dati, grafici e sentiment del Mercato permette di compiere scelte d’investimento più consapevoli e precise, sfruttando così al massimo le potenzialità dell’AI».

L’intelligenza artificiale può rendere i Mercati più efficienti o rischia invece di aumentare la volatilità?

«Questa è una domanda complessa, perché in realtà le due cose non possono essere separate nettamente. Ogni strumento nuovo porta con sé punti di forza e debolezze: l’obiettivo dell’innovazione tecnologica è proprio massimizzare i primi e minimizzare i secondi. Faccio un esempio pratico: quando si usava la penna con il calamaio, il rischio di sbavatura era intrinseco nello strumento stesso, seppur permettesse di scrivere.

Con il tempo, migliorando la tecnologia, abbiamo ridotto quel rischio pur mantenendo la capacità di scrittura. Lo stesso vale oggi per l’intelligenza artificiale nei Mercati finanziari. È certamente uno strumento potente, specialmente per attività specifiche, come l’analisi del sentiment – attualmente una delle funzioni più affidabili. Ma siamo ancora agli inizi, e la tecnologia migliorerà ulteriormente. Al momento, gli algoritmi non si limitano più a prevedere il comportamento di un titolo guardando solo ai dati storici, ma integrano informazioni molto più ampie: l’atteggiamento degli utenti, il comportamento dei concorrenti, o analisi dettagliate sul web, per esempio.

Tuttavia, se da un lato questo rende i Mercati potenzialmente più efficienti e informati, dall’altro introduce nuove forme di rischio legate proprio all’automazione. Bot che eseguono rapidamente operazioni basate su predizioni anche minime possono infatti introdurre bias o generare volatilità artificiale».

Dal punto di vista infrastrutturale, quali progressi sono necessari per sfruttare al meglio le potenzialità dell’AI?

«Occorre distinguere due aspetti principali. Il primo riguarda la gestione dei dati. È fondamentale comprendere quali si utilizzano, se interni – propri di un’azienda o istituzione finanziaria – oppure esterni – provenienti dal web. Nel primo caso è necessario disporre di banche dati facilmente consultabili e interfacciabili con gli strumenti aziendali. Questo comporta inevitabilmente anche una forte attenzione alla sicurezza.

L’AI, infatti, rende il dato un asset sempre più prezioso e dunque richiede infrastrutture più elaborate per proteggerlo. Un esempio concreto è rappresentato dai processori Intel Xeon di ultima generazione, che integrano di default sistemi avanzati di sicurezza (Trusted Execution Environment), capaci di funzionare sia a riposo sia durante l’elaborazione. Il secondo aspetto è relativo all’hardware necessario per ospitare gli algoritmi di AI.

Anche qui va fatta una distinzione importante: se l’azienda implementa algoritmi proprietari oppure si affida strumenti sviluppati da terzi. Nel primo caso è fondamentale selezionare e personalizzare l’hardware in base alle esigenze specifiche degli algoritmi impiegati. Nel secondo, occorre prestare attenzione ai requisiti richiesti dagli strumenti esterni e, ancora una volta, alla protezione dei dati. In definitiva, il consiglio principale è avere chiarezza sul proprio workload e sulla direzione strategica scelta, cioè decidere con anticipo l’approccio da adottare e costruire l’infrastruttura adeguata alle proprie necessità. Questa scelta preventiva risulta il miglior modo per massimizzare l’investimento infrastrutturale nel lungo termine».

Considerando quella che sembra una sfida tra due grandi potenze nell’ambito dell’intelligenza artificiale, come vede questa competizione?

«Bisogna innanzitutto chiarire da quale prospettiva osserviamo. Se il nostro punto di vista è quello degli utenti – aziende o privati che siano – l’ingresso di realtà che rendono pubbliche tecnologie avanzate come DeepSeek ha un impatto positivo, perché accelera la diffusione della ricerca e ne stimola i progressi. Occorre però precisare che tecnicamente questi strumenti spesso non sono del tutto open source, ma pubblici.

La differenza è importante: l’open source implica la possibilità di replicare completamente il processo originale, compresi dati e metodologie, mentre strumenti come DeepSeek rendono disponibili solo alcuni elementi (ad esempio, i modelli già addestrati e alcune procedure) sufficienti comunque a far avanzare significativamente la ricerca. Questa diffusione ha effetti concreti e benefici: un esempio recente è l’algoritmo GRPO introdotto proprio da DeepSeek per il post-addestramento. Anche se non è stato inventato da loro, il fatto di aver dimostrato pubblicamente la sua efficacia rispetto ad altre tecnologie disponibili ha dato impulso a ulteriori sviluppi applicativi, come la navigazione autonoma in 3D o la guida autonoma.

D’altra parte, però, va posta attenzione alla sostenibilità economica e operativa di queste iniziative. Entrare nel palcoscenico globale con tecnologie gratuite o pubbliche è utile per ottenere visibilità, ma implica enormi investimenti in risorse e competenze, costose e difficili da reperire. Se un progetto non prevede un modello di business solido, diventa difficile sostenere questi sforzi nel tempo. In definitiva, l’AI aperta accelera indubbiamente il progresso tecnologico e migliora le possibilità degli utenti finali. Tuttavia, il grande punto interrogativo per le aziende rimane quello di riuscire a mantenere la sostenibilità economica, giustificando investimenti considerevoli in tecnologie che, in molti casi, rischiano di non generare ritorni finanziari immediati».

Dove si colloca l’Europa nella sfida globale sull’intelligenza artificiale?

«Per rispondere, provo a partire da una riflessione: immaginando l’AI tra 10 o 50 anni, vedo uno strumento molto più maturo, potente e pervasivo nella società. Tuttavia, non riesco a dissociare questa evoluzione tecnologica dalla necessità di regolamentarla. Ogni prodotto o tecnologia che entra sul Mercato, infatti, richiede necessariamente un quadro normativo chiaro e definito per poter funzionare efficacemente.

In questo senso, l’approccio europeo appare sano e cauto, perché mette al primo posto la tutela della società. L’Unione Europea ha deciso di affrontare prima l’aspetto legislativo e poi quello tecnologico, diversamente da altre realtà che hanno invertito la priorità. Un esempio emblematico è quello della Cina, che ha introdotto prima tecnologie molto avanzate, come le telecamere nelle scuole per l’analisi facciale degli studenti.

Poi però si è trovata obbligata a introdurre regolamentazioni ad hoc per gestire esigenze sociali, etiche e normative emerse strada facendo. Al tempo stesso, l’Europa sa comunque produrre realtà innovative e competitive: basti pensare alla Startup europea dietro a Mistral e alla tecnologia della “mistura di esperti”, rilanciata recentemente anche da DeepSeek nel gennaio 2025. Questo testimonia che il Vecchio Continente, pur avendo scelto una strada più regolamentata, possiede grandi potenzialità tecnologiche e innovative. In fin dei conti, l’approccio europeo sembra quello più equilibrato per affrontare efficacemente un futuro dove l’intelligenza artificiale avrà un impatto sempre più profondo sulle nostre vite».

E l’Italia?

«Parlando del nostro Paese, va sicuramente menzionato l’annuncio recente (gennaio 2025) di Vitruvian V1, modello sviluppato da una Startup italiana. Questo modello è stato concepito con l’obiettivo di ottimizzare il cosiddetto ragionamento costruito: un processo in cui l’intelligenza artificiale procede passo dopo passo, scomponendo il problema in micro-decisioni e avanzando progressivamente verso la soluzione finale.

È un meccanismo che abbiamo già visto all’opera in molte applicazioni recenti e che sta mostrando un notevole potenziale. Un altro punto forte italiano è l’attenzione mostrata dal Garante della Privacy, che è intervenuto tempestivamente prima su ChatGPT e poi su DeepSeek. Per il chatbot americano, le indicazioni del garante italiano hanno portato a una maggiore tutela della privacy, influenzando l’intera Europa. Al contrario, l’azienda cinese ha scelto una posizione diversa, decidendo di conservare integralmente i dati degli utenti e rivendicando il proprio status extra-europeo, dunque non soggetto direttamente al GDPR. Questo ruolo proattivo dell’Italia sulla privacy rappresenta un vero fiore all’occhiello del Paese, e probabilmente ne comprenderemo meglio l’importanza solo nei prossimi anni». ©