La OCU recomienda desactivar cuanto antes esta opción en ChatGPT

Las únicas versiones que garantizan por defecto la privacidad son las versiones de pago Team y Enterprise.

La Organización de Consumidores y Usuarios (OCU) recomendó este viernes desactivar la opción de compartir datos en ChatGPT, consciente de que la información que se comparte, incluso en algunas versiones de pago, podría estar siendo utilizada para entrenar la inteligencia artificial (IA) de estas herramientas pertenecientes a la compañía OpenAI.

Así lo advirtió en un comunicado en el que puntualizó que las únicas versiones de ChatGPT que garantizan, por defecto, la privacidad de los datos compartidos por el usuario son las versiones de pago Team (25 dólares/mes) y Enterprise (precio negociado).

El resto, la versión Free y las otras dos versiones de pago, Plus (20 dólares/mes) y Pro (200 dólares/mes), pueden usar en su interacción con los usuarios las conversaciones registradas e incluso los archivos compartidos para mejorar la precisión y la capacidad de estos modelos de IA. En este sentido, aunque precisó que “aclaran que no usan esta información con fines comerciales”, recomienda desactivar esta opción.

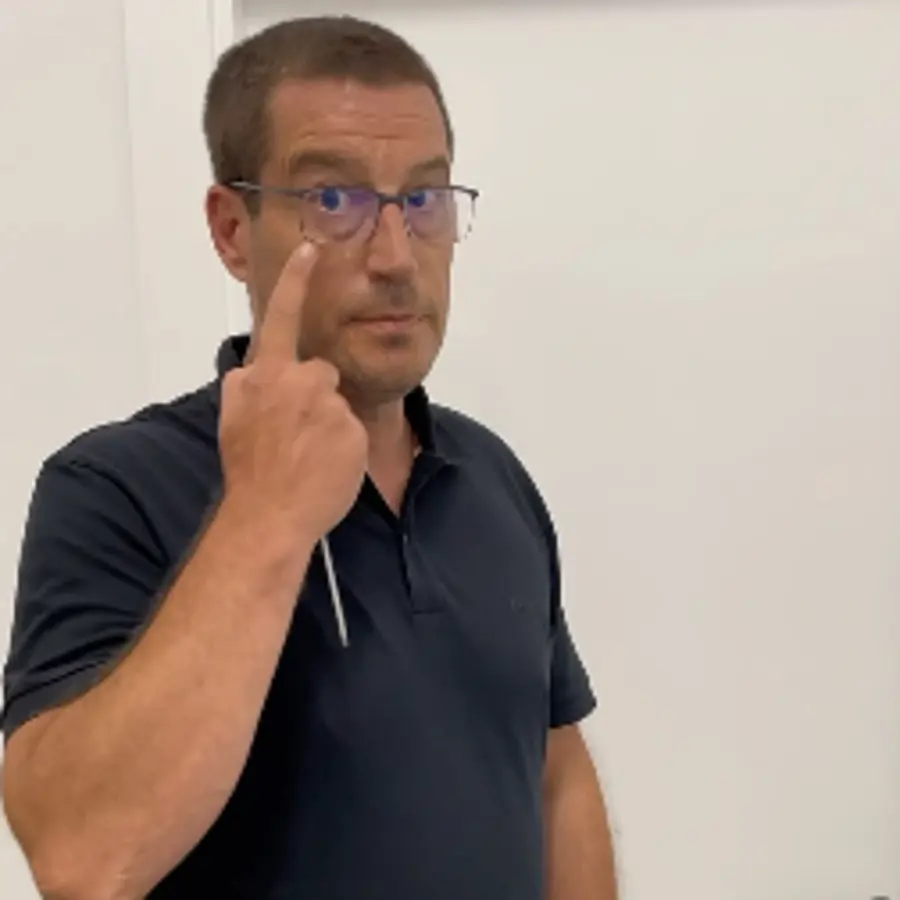

Para desactivar esta función explicó que es necesario seguir cuatro pasos, esto es acceder a la cuenta personal de ChatGPT desde https://chatgpt.com/ y, a continuación, clicar en la foto de perfil y seleccionar configuración. En el menú emergente, ir a la opción controles de datos y, acto seguido, desactivar la casilla 'Mejorar el modelo para todos'.

"No obstante, aunque desactivar la opción de entrenamiento de tres de las versiones de ChatGPT contribuye a proteger la privacidad, muchos datos seguirán siendo recopilados por motivos operativos, de seguridad y legales", apostilló. Entre ellos, mencionó los datos básicos de la cuenta, los datos de uso, los datos técnicos, los metadatos de la sesión y los datos necesarios para cumplir con la normativa y responder a requerimientos legales.

Nueva normativa

Por otro lado, la OCU recordó que desde febrero la normativa de la Unión Europea sobre IA prohíbe varias prácticas en su interacción con el usuario, que podrían afectar a otros usos, como la manipulación a personas para explotar las vulnerabilidades del usuario por edad, discapacidad o condición socioeconómica o la clasificación de personas en base a su comportamiento social o características personales.

Por la novedad de estas medidas, la OCU instó a las administraciones a que se informe de ello a los consumidores, de modo que puedan denunciar cualquier práctica que pudiera atentar contra sus derechos fundamentales.

En paralelo, pidió "recursos suficientes" para la nueva Agencia Española de Supervisión de Inteligencia Artificial (Aesia), el organismo que se encargará de velar por el cumplimiento de la normativa y la protección de los usuarios.

_pais-valencia.jpg?v=63912107965)