Google impulsa su IA para descifrar el lenguaje de los delfines

Con ayuda de la inteligencia artificial, Google ha lanzado un ambicioso proyecto para entender y lograr una comunicación con los delfines

-

En 2023, se invirtieron más de 25 mil millones de dólares en modelos generativos de IA, según el AI Index 2024 de la Universidad de Stanford.

-

El número de publicaciones científicas sobre IA aumentó un 62% entre 2019 y 2023, según el OECD AI Policy Observatory, lo que refleja el crecimiento acelerado del interés académico por estas tecnologías.

-

La UNESCO estima que cerca del 40% de las lenguas del mundo están en peligro de extinción, y varias iniciativas con IA están trabajando para preservarlas a través de modelado lingüístico y traducción automática.

¿Qué pasaría si pudiéramos entablar una conversación con los delfines? Esta pregunta, que parece sacada de una película de ciencia ficción, es justo lo que está explorando Google DeepMind con un proyecto que busca acercarnos a una comunicación real con estos mamíferos marinos. A través de un video publicado en YouTube, la compañía presentó su proyecto DolphinGemma, que funciona con inteligencia artificial diseñada para descifrar el lenguaje de los delfines y, eventualmente, hablar con ellos.

Este proyecto va de la mano con Gemma, una serie de modelos de IA de código abierto creados por Google para que investigadores de todo el mundo puedan utilizarlos en distintos ámbitos científicos. En este caso, el objetivo es analizar los sonidos producidos por los delfines como silbidos, clics y hasta zumbidos con el fin de identificar estructuras, patrones y posibles significados detrás de ellos. Aunque se sabe que los delfines son capaces de reconocerse en un espejo y usar herramientas, lo que indica un alto nivel de inteligencia, su sistema de comunicación sigue siendo un misterio en muchos aspectos.

Cabe destacar que, el modelo fue desarrollado con datos recolectados durante más de 40 años por el Wild Dolphin Project (WDP), una organización dedicada al estudio de una comunidad de delfines moteados del Atlántico en las Bahamas. Gracias a su trabajo, se han logrado interpretar ciertos sonidos, por ejemplo hay silbidos que se usan entre madres e hijos para reunirse. Sin embargo, hasta ahora no se contaba con una herramienta capaz de procesar esta información de forma eficiente para buscar estructuras lingüísticas más profundas. Por ello, DolphinGemma permite precisamente eso: encontrar patrones sutiles que los humanos no podríamos detectar por cuenta propia y, con ello, abrir la posibilidad de construir un lenguaje común.

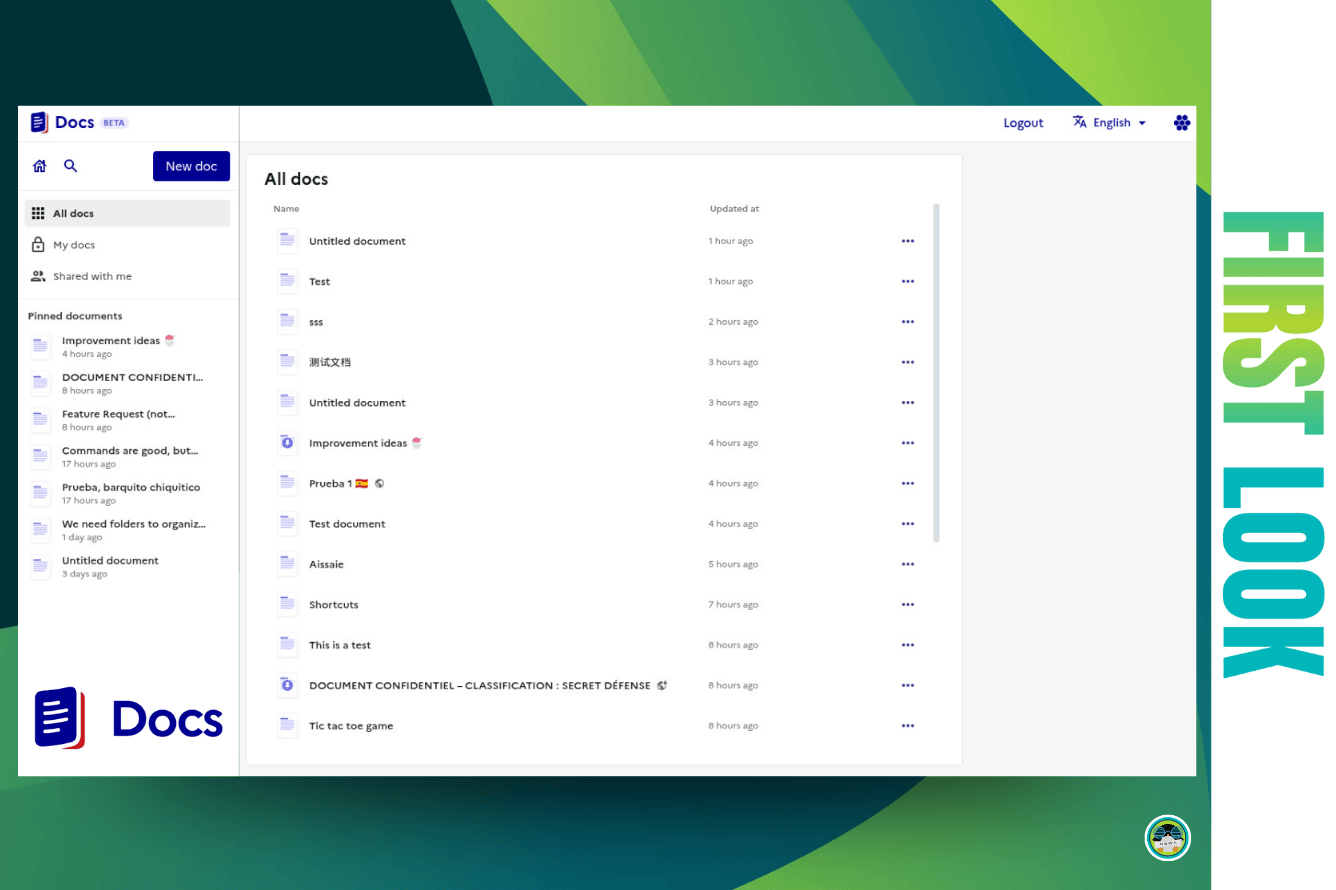

Como parte del proyecto, Google también trabaja con el Instituto Tecnológico de Georgia en el desarrollo de una computadora submarina interactiva llamada CHAT (Telemetría de Aumento Auditivo para Cetáceos). Este sistema se ha construido con componentes accesibles como un teléfono inteligente Google Pixel 6, que permite procesar sonidos en tiempo real sin requerir hardware personalizado. El dispositivo es lo suficientemente compacto y eficiente para funcionar bajo el agua, y su versión más reciente ya puede generar silbidos sintéticos basados en los datos de DolphinGemma, que se asocian a objetos o elementos marinos con la esperanza de que los delfines los reconozcan y respondan.

En el futuro, este tipo de tecnología podría no solo permitirnos identificar lo que los delfines intentan comunicar, sino también enseñarles un vocabulario con el que puedan interactuar con humanos de forma intencionada. Si los delfines tienen lenguaje, como sugiere el proyecto, entonces también podrían tener cultura, prioridades y hasta temas sobre los cuales “conversar”. Para los científicos involucrados, esta IA representa un puente hacia una nueva era de comunicación interespecie, donde entender a otras formas de inteligencia ya no es un sueño, sino una posibilidad cercana.

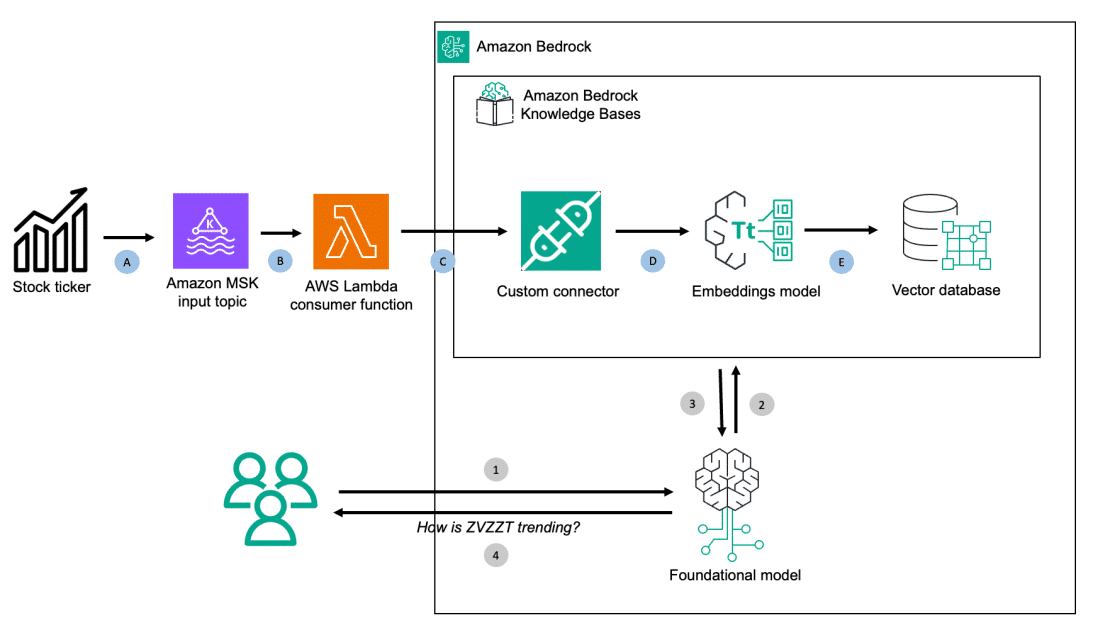

En ese sentido, los modelos de lenguaje de gran escala (LLM, por sus siglas en inglés) han demostrado una capacidad sin precedentes para comprender, generar y traducir información en múltiples idiomas y formatos. De acuerdo con el informe AI Index 2024 de la Universidad de Stanford, el 2023 fue el año con mayor inversión privada en IA de la historia, con más de 25 mil millones de dólares destinados solo a modelos generativos, un crecimiento impulsado en parte por el auge de herramientas como ChatGPT, Gemini y Claude.

Además de procesar texto, estas tecnologías ya están siendo entrenadas para interpretar voz, sonido, imágenes e incluso lenguaje corporal. Empresas como Meta, OpenAI y Google han comenzado a explorar la multimodalidad, es decir, la capacidad de la IA para comprender distintos tipos de datos al mismo tiempo, lo que abre la puerta a sistemas que puedan “conversar” no solo con humanos, sino también con otros sistemas o entornos físicos. Por ejemplo, en abril de 2024, OpenAI presentó Voice Engine, un modelo capaz de imitar voces humanas con solo 15 segundos de audio de muestra, y Google introdujo avances en Project Astra, una IA con capacidad de escucha, memoria visual y respuesta contextual en tiempo real.

El reto, claro, no es menor. Estas tecnologías requieren grandes cantidades de datos, poder computacional y regulaciones éticas claras. Sin embargo, su desarrollo sugiere que estamos entrando en una era en la que las formas de comunicación podrían volverse radicalmente distintas a lo que hoy conocemos.

Ahora lee:

OpenAI planea lanzar una red social para competir con Elon Musk

Hackean semáforo peatonal para que hable como Elon Musk y Mark Zuckerberg

Checo Pérez y Heineken 0.0 renuevan su alianza en una nueva etapa