Заменят ли нас нейросети?

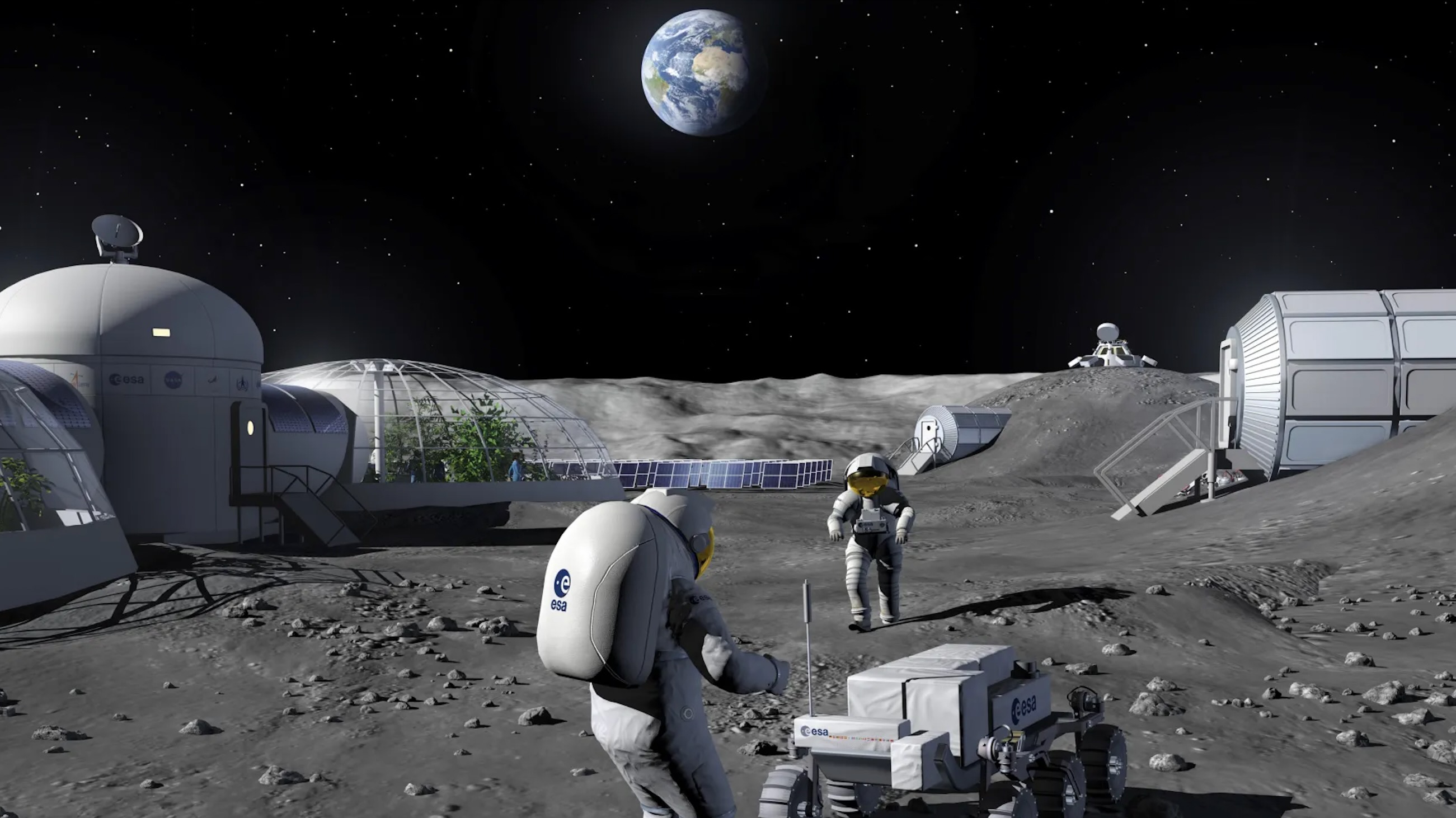

И чем ближе мы оказываемся к центру города, тем плотнее нас окружают волшебные сады диковинных технологических растений. Механизм, Эрнст Юнгер Такие машины, как генеративные нейросети, gpt-модели стали частью нашей реальности, как когда-то электричество и интернет. Их громко называют "искусственным интеллектом", про них пишутся статьи и в этот момент, когда слова текут из машин быстрее, чем из человеческих уст, человек впервые ощутил, что он больше не уникальный обладатель языка. Для кого-то этот вопрос стал источником страха, как для луддитов в Англии, которые со страхом смотрели на прядильные станки. Работники, чья работа - создание текста, читают новости о сокращениях, связывают эти события с появлением gpt-моделей и задаются вопросом: что буду делать я, когда эта система, не знающая усталости, будет еще умнее? К сожалению, нейросети - это не станок, видимый, шумящий, стоящий у нас перед глазами в мануфактуре, мы видим только его интерфейс, это дает ему ореол таинственности. Чтобы разобраться в обоснованности этих мыслей, стоит внимательно изучить сам объект этих страхов Если посмотреть на эти системы как на организм в разрезе, то глубоко внутри мы обнаружим не искусственные мозги, а нечто иное - статистику. Очень сложный алгоритм предугадывания следующего слова в предложении. Вокруг него множество остальных нейросетей - надстройки, добавляющие ему понимание контекста, связанности текста и прочее. Перед нами чрезвычайно сложный инструмент предугадывания слова, с самой ранней версией которого мы уже знакомы, когда набирали другу sms. Поэтому меня всегда удивляют промпты в стиле "проанализируй данные за последние X лет в сфере Y, проведи исследование Z и дай мне результат A", потому что машине приписывают функции аналитика, исследователя, философа. Это не собеседник, эта машина, которая не думает перед тем как ответить на вопрос, тем более делать сложный анализ. Она только выдает статистически и стилистически похожий на правду ответ Чтобы этот механизм запустился и работал, нужно загрузить в систему колоссальный объем данных - современные gpt-модели требуют сотни гигабайт текстовой информации. Эти данные берутся из сети интернет. Утверждение о том, что в систему загружают всё, что когда-либо было написано и выложено в сеть - лукавое упрощение. Машина обрабатывает данные только из открытых источников и тексты под public domain, которые становятся доступны через 70 лет после смерти автора или публикации. То есть кроме оцифрованной классической литературы, он читает много интернет контента сгенеренного самими пользователями: обзоры, ревью, новости, рерайты и переписанные десятки раз тексты - это продукты работы "среднего" пользователя Факт: значительная часть качественной профессиональной информации не в открытом доступе. Это невидимая зона для gpt. Она находится в библиотеках, архивах, закрытых форумах, в современных книгах, защищенных авторским правом. Это книги, журналы, чертежи, изображения в высоком разрешении, изображения научного оборудования, аудиозаписи с/без транскрибации, контент ТВ и онлайн-кинотеатров, коммерческие базы данных и справочники, дневниковые архивные документы. GPT-продукты не имеют доступа к этим данным, а это очень ценные уникальные знания О проблеме оцифровки важной, уникальной, профессиональной информации мало кто задумывается. О доступе к защищенным данным ломают головы разработчики gpt-системы. Эти инструменты не читают никакие современные книги, только отзывы на них и обзоры. Можно попросить gpt дать вам краткую выжимку из последней книги писателя N. Это будет компиляция на основе журнальной статьи и обзоров на нее, но не на основе самого произведения. Система производит ощущение осведомленности — не имея доступа к оригиналу. Если выясняется, что в обучающую выборку попали защищённые авторским правом тексты, возбуждаются судебные дела Существуют профессиональные сферы, где до сих пор нейросети не могут быть применены из-за недостатка больших массивов данных для тренировки. Например, переводы хеттских клинописных табличек и текстов на других мёртвых языках. В этой области много непереведенных данных, мало специалистов и нет накопленных гигабайт параллельных текстов, для полноценного обучения нейросетей. Здесь вопрос о применении нейросетей не решен, а до идеи замены специалистов очень далеко Доступ к качественной профессиональной информации ограничен и эта информация очень медленно наполняет сеть интернет. Количество контента производимый средним пользователем все больше и больше, но "интеллект" этого среднего пользователя деградирует. Обилие информации парадоксально снижает интеллектуальную плотность среды. Это особенно остро проявилось, когда появились новости, что в сети стали появляется данные сгенеренные нейросетями, из-за чего сами нейросети качественно поглупели. Контроль и фильтрация этих массивов данных становится всё более трудной задачей, из-за чего системы сталкиваются с проблемой "мусор на входе - мусор на выходе" (GIGO) В этом кратком экскурсе мы

И чем ближе мы оказываемся к центру города, тем плотнее нас окружают волшебные сады диковинных технологических растений.

Механизм, Эрнст Юнгер

Такие машины, как генеративные нейросети, gpt-модели стали частью нашей реальности, как когда-то электричество и интернет. Их громко называют "искусственным интеллектом", про них пишутся статьи и в этот момент, когда слова текут из машин быстрее, чем из человеческих уст, человек впервые ощутил, что он больше не уникальный обладатель языка. Для кого-то этот вопрос стал источником страха, как для луддитов в Англии, которые со страхом смотрели на прядильные станки. Работники, чья работа - создание текста, читают новости о сокращениях, связывают эти события с появлением gpt-моделей и задаются вопросом: что буду делать я, когда эта система, не знающая усталости, будет еще умнее?

К сожалению, нейросети - это не станок, видимый, шумящий, стоящий у нас перед глазами в мануфактуре, мы видим только его интерфейс, это дает ему ореол таинственности. Чтобы разобраться в обоснованности этих мыслей, стоит внимательно изучить сам объект этих страхов

Если посмотреть на эти системы как на организм в разрезе, то глубоко внутри мы обнаружим не искусственные мозги, а нечто иное - статистику. Очень сложный алгоритм предугадывания следующего слова в предложении. Вокруг него множество остальных нейросетей - надстройки, добавляющие ему понимание контекста, связанности текста и прочее. Перед нами чрезвычайно сложный инструмент предугадывания слова, с самой ранней версией которого мы уже знакомы, когда набирали другу sms. Поэтому меня всегда удивляют промпты в стиле "проанализируй данные за последние X лет в сфере Y, проведи исследование Z и дай мне результат A", потому что машине приписывают функции аналитика, исследователя, философа. Это не собеседник, эта машина, которая не думает перед тем как ответить на вопрос, тем более делать сложный анализ. Она только выдает статистически и стилистически похожий на правду ответ

Чтобы этот механизм запустился и работал, нужно загрузить в систему колоссальный объем данных - современные gpt-модели требуют сотни гигабайт текстовой информации. Эти данные берутся из сети интернет. Утверждение о том, что в систему загружают всё, что когда-либо было написано и выложено в сеть - лукавое упрощение. Машина обрабатывает данные только из открытых источников и тексты под public domain, которые становятся доступны через 70 лет после смерти автора или публикации. То есть кроме оцифрованной классической литературы, он читает много интернет контента сгенеренного самими пользователями: обзоры, ревью, новости, рерайты и переписанные десятки раз тексты - это продукты работы "среднего" пользователя

Факт: значительная часть качественной профессиональной информации не в открытом доступе. Это невидимая зона для gpt. Она находится в библиотеках, архивах, закрытых форумах, в современных книгах, защищенных авторским правом. Это книги, журналы, чертежи, изображения в высоком разрешении, изображения научного оборудования, аудиозаписи с/без транскрибации, контент ТВ и онлайн-кинотеатров, коммерческие базы данных и справочники, дневниковые архивные документы. GPT-продукты не имеют доступа к этим данным, а это очень ценные уникальные знания

О проблеме оцифровки важной, уникальной, профессиональной информации мало кто задумывается. О доступе к защищенным данным ломают головы разработчики gpt-системы. Эти инструменты не читают никакие современные книги, только отзывы на них и обзоры. Можно попросить gpt дать вам краткую выжимку из последней книги писателя N. Это будет компиляция на основе журнальной статьи и обзоров на нее, но не на основе самого произведения. Система производит ощущение осведомленности — не имея доступа к оригиналу. Если выясняется, что в обучающую выборку попали защищённые авторским правом тексты, возбуждаются судебные дела

Существуют профессиональные сферы, где до сих пор нейросети не могут быть применены из-за недостатка больших массивов данных для тренировки. Например, переводы хеттских клинописных табличек и текстов на других мёртвых языках. В этой области много непереведенных данных, мало специалистов и нет накопленных гигабайт параллельных текстов, для полноценного обучения нейросетей. Здесь вопрос о применении нейросетей не решен, а до идеи замены специалистов очень далеко

Доступ к качественной профессиональной информации ограничен и эта информация очень медленно наполняет сеть интернет. Количество контента производимый средним пользователем все больше и больше, но "интеллект" этого среднего пользователя деградирует. Обилие информации парадоксально снижает интеллектуальную плотность среды. Это особенно остро проявилось, когда появились новости, что в сети стали появляется данные сгенеренные нейросетями, из-за чего сами нейросети качественно поглупели. Контроль и фильтрация этих массивов данных становится всё более трудной задачей, из-за чего системы сталкиваются с проблемой "мусор на входе - мусор на выходе" (GIGO)

В этом кратком экскурсе мы подошли к проблеме интеллектуальности самой системы и к проблеме информации, на основе которой она обучается. Кто сумеет отфильтровать только качественный контент из сети интернет и приобрести доступ к закрытой профессиональной информации - сможет создать более интеллектуальный механизм. Это лишь фундаментальные проблемы, заметные извне тем, кто наблюдает за системами, а не создаёт их изнутри. О масштабах технических и юридических ограничений, скрытых под NDA, мы можем только догадываться

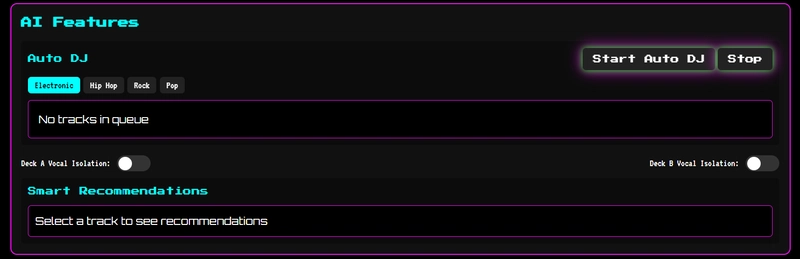

Каков ответ на главный вопрос: заменят ли нас нейросети? Кратко - нет, не в ближайшей перспективе. Gpt-системы уверенно работают в пределах стандартных, повторяющихся задач. Обратится к ней - быстрее чем ввести запрос в поисковик, перейти на очередной сайт и прочитать ответы - ты сразу получаешь одну итоговую компиляцию в виде ответа

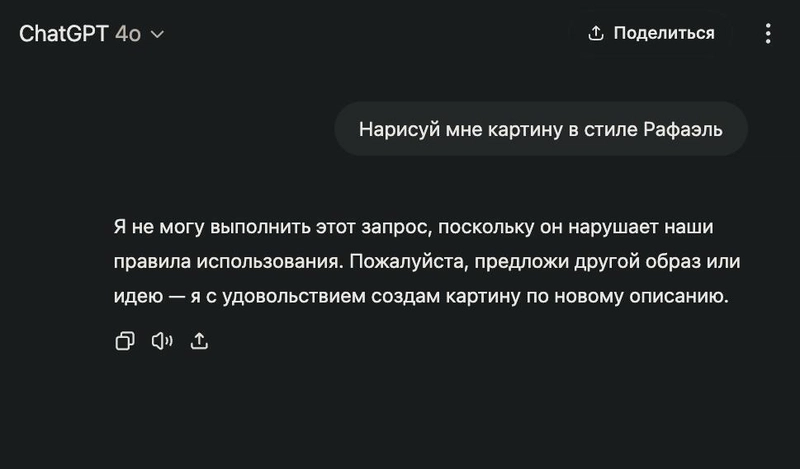

Сами форматы её ответов тоже ограничены - это замечал каждый, кто просил систему создать нечто более сложное, чем типовой ответ: рассказ, книгу, картину с кучей деталей и прочее. Тем, кто практиковал vibe coding, знакомо чувство когда машина глупеет на ходу, и процесс превращается в неприятный vibe debugging. У каждой технологии есть предел полезности и я считаю, что даже если они сильно улучшатся в ближайшее время, то останутся на уровне полезного помощника по рабочим задачам

Новый виток в развитии Gpt-систем возможен, если библиотеки, архивы, начнут публиковать свои оцифрованные работы и запускать свои gpt-решения. Маловероятно, что такие учреждения передадут свои данные крупным IT-компаниям. Скорее, они предпочтут разрабатывать решения под себя — возможно, с участием больших игроков, но не под их полным контролем. Идея одного всезнающего Gpt-продукта выглядит всё менее реалистичной. Создание универсальной модели потребует колоссальных ресурсов на фильтрацию, структурирование и правовую очистку контента. Вместо этого мы можем получить коллекцию специализированных моделей, каждая из которых будет знать немного, но точно и только в рамках своей области

Для самих инженеров будет что делать так как эти самые gpt-системы кто-то должен внедрять в действующие корпоративные продукты. Интеграция с ними и написание ai-агентов - новая маленькая ниша, которая уже появилась. Например, есть успешные кейсы внедрения gpt-систем в чаты поддержки пользователей. Если в будущем будет больше доступных фреймворков для настройки своих gpt-систем, то стоит задуматься о смене роли инженера - не как создателя кода, а как оркестратора этих систем

Мое мнение - мы не наблюдаем рождение нового разума. Мы наблюдаем рождение нового инструмента, со своими возможностями и ограничениями

![[FREE EBOOKS] Modern Generative AI with ChatGPT and OpenAI Models, Offensive Security Using Python & Four More Best Selling Titles](https://www.javacodegeeks.com/wp-content/uploads/2012/12/jcg-logo.jpg)

.webp?#)