Biblioteca de código aberto NVIDIA Dynamo acelera e escala modelos de lógica de IA

Biblioteca de código aberto NVIDIA Dynamo acelera e escala modelos de lógica de IA.

A NVIDIA Dynamo aumenta o desempenho de inferência enquanto reduz os custos para escalonar o processamento durante o teste; otimizações de inferência no NVIDIA Blackwell aumentam a taxa de processamento em 30x no DeepSeek-R1

A NVIDIA anuncia o NVIDIA Dynamo, um software de inferência de código aberto projetado para acelerar e escalonar modelos de raciocínio em IA em fábricas de IA com o menor custo e máxima eficiência.

Orquestrar e coordenar de forma eficiente as solicitações de inferência de IA em uma grande frota de GPUs é crucial para garantir que as fábricas de IA operem com o menor custo possível, maximizando a geração de receita por token.

À medida que o raciocínio de IA se torna mais comum, cada modelo de IA gerará dezenas de milhares de tokens usados para “pensar” a cada prompt. Aumentar o desempenho de inferência enquanto reduz continuamente seu custo, acelera o crescimento e impulsiona as oportunidades de receita para os provedores de serviços.

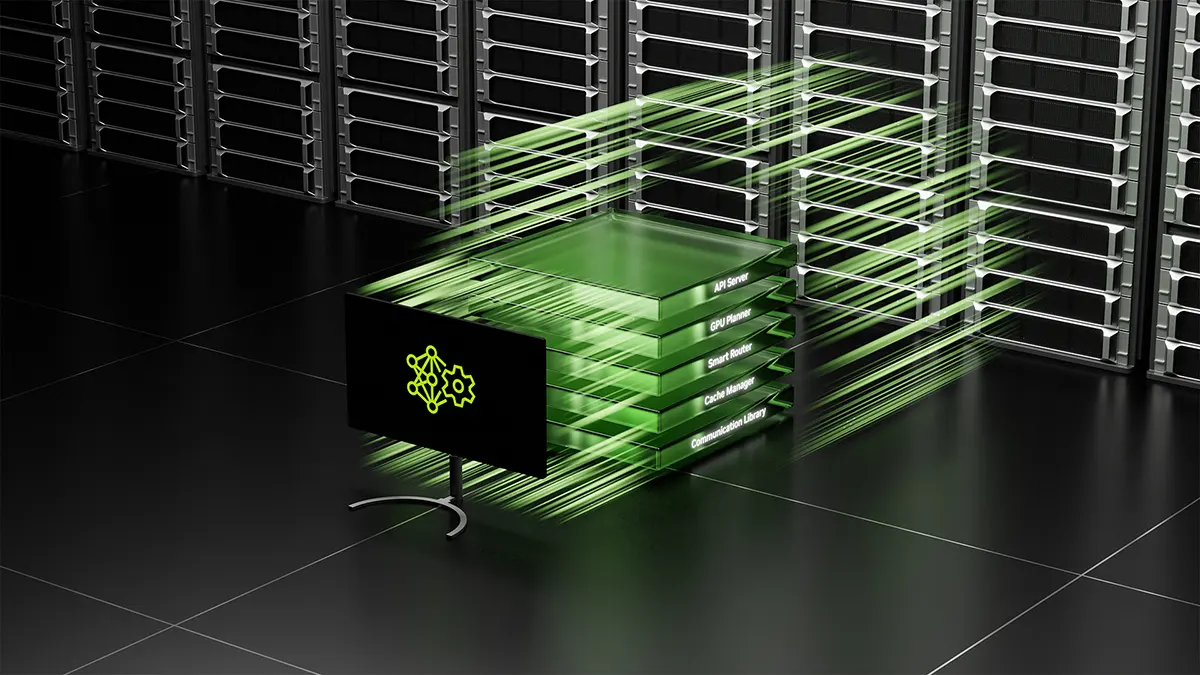

O NVIDIA Dynamo, sucessor do NVIDIA Triton Inference Server , é um novo software de fornecimento de inferência em IA projetado para maximizar a geração de receita por token para fábricas de IA que implantam modelos de raciocínio em IA. Ele orquestra e acelera a comunicação de inferência entre milhares de GPUs e utiliza o fornecimento desagregado para separar as fases de processamento e geração de grandes modelos de linguagem (LLMs) em diferentes GPUs. Isso permite que cada fase seja otimizada de forma independente para suas necessidades específicas e garante a máxima utilização dos recursos da GPU.

, é um novo software de fornecimento de inferência em IA projetado para maximizar a geração de receita por token para fábricas de IA que implantam modelos de raciocínio em IA. Ele orquestra e acelera a comunicação de inferência entre milhares de GPUs e utiliza o fornecimento desagregado para separar as fases de processamento e geração de grandes modelos de linguagem (LLMs) em diferentes GPUs. Isso permite que cada fase seja otimizada de forma independente para suas necessidades específicas e garante a máxima utilização dos recursos da GPU.

Usando o mesmo número de GPUs, o Dynamo dobra o desempenho e a receita das fábricas de IA que executam modelos Llama na plataforma NVIDIA Hopper atual. Ao rodar o modelo DeepSeek-R1 em um grande cluster de racks GB200 NVL72, as otimizações inteligentes de inferência do NVIDIA Dynamo também aumentam o número de tokens gerados em mais de 30 vezes por GPU.

atual. Ao rodar o modelo DeepSeek-R1 em um grande cluster de racks GB200 NVL72, as otimizações inteligentes de inferência do NVIDIA Dynamo também aumentam o número de tokens gerados em mais de 30 vezes por GPU.

Para alcançar essas melhorias no desempenho de inferência, o NVIDIA Dynamo incorpora recursos que permitem aumentar a taxa de transferência e reduzir custos. Ele pode adicionar, remover e realocar GPUs dinamicamente em resposta a volumes e tipos de solicitações flutuantes, além de identificar GPUs específicas em grandes clusters que podem minimizar os cálculos de resposta e direcionar as consultas. Também pode descarregar dados de inferência para dispositivos de memória e armazenamento mais acessíveis e recuperá-los rapidamente quando necessário, minimizando os custos de inferência.

O NVIDIA Dynamo é totalmente de código aberto e oferece suporte a PyTorch, SGLang, NVIDIA TensorRT -LLM e vLLM, permitindo que empresas, startups e pesquisadores desenvolvam e otimizem formas de fornecer modelos de IA por meio de inferência desagregada. Ele permitirá que os usuários acelerem a adoção de inferência de IA, incluindo em AWS, Cohere, CoreWeave, Dell, Fireworks, Google Cloud, Lambda, Meta, Microsoft Azure, Nebius, NetApp, OCI, Perplexity, Together AI e VAST.

-LLM e vLLM, permitindo que empresas, startups e pesquisadores desenvolvam e otimizem formas de fornecer modelos de IA por meio de inferência desagregada. Ele permitirá que os usuários acelerem a adoção de inferência de IA, incluindo em AWS, Cohere, CoreWeave, Dell, Fireworks, Google Cloud, Lambda, Meta, Microsoft Azure, Nebius, NetApp, OCI, Perplexity, Together AI e VAST.

Inferência turbinada

O NVIDIA Dynamo mapeia o conhecimento que os sistemas de inferência mantêm em memória a partir de solicitações anteriores — conhecido como KV cache — em potencialmente milhares de GPUs.

Em seguida, ele direciona novas solicitações de inferência para as GPUs que possuem a melhor correspondência de conhecimento, evitando recomputações caras e liberando GPUs para responder a novas solicitações.

Agentes de IA

O provedor de IA Cohere está planejando usar o NVIDIA Dynamo para potencializar as capacidades de agentes de IA em sua série de modelos Command.

Fornecimento desagregado

A plataforma de inferência NVIDIA Dynamo também suporta o fornecimento desagregado, que atribui diferentes fases computacionais de LLMs — incluindo a construção de uma compreensão da consulta do usuário e a geração da melhor resposta — a diferentes GPUs. Essa abordagem é ideal para modelos de raciocínio, como a nova família de modelos NVIDIA Llama Nemotron, que utiliza técnicas avançadas de inferência para melhorar a compreensão contextual e a geração de respostas. O fornecimento desagregado permite que cada fase seja ajustada e alocada de forma independente, melhorando a taxa de transferência e proporcionando respostas mais rápidas aos usuários.

A Together AI, a AI Acceleration Cloud, está procurando integrar seu motor de inferência proprietário com o NVIDIA Dynamo para permitir a escalabilidade sem interrupções de cargas de trabalho de inferência entre nós de GPU. Isso também permitirá que a Together AI resolva dinamicamente os gargalos de tráfego em várias etapas do pipeline do modelo.

NVIDIA Dynamo em detalhes

O NVIDIA Dynamo inclui quatro inovações chave que reduzem os custos de fornecimento de inferência e melhoram a experiência do usuário:

- GPU Planner: um motor de planejamento que adiciona e remove GPUs dinamicamente para ajustar-se à demanda flutuante dos usuários, evitando o provisionamento excessivo ou insuficiente de GPUs;

- Smart Router: um roteador ciente de LLM que direciona solicitações em grandes frotas de GPUs para minimizar recomputações caras de solicitações repetidas ou sobrepostas — liberando GPUs para responder a novas solicitações;

- Low-Latency Communication Library: uma biblioteca otimizada para inferência que suporta comunicação de GPU para GPU de última geração e abstrai a complexidade da troca de dados entre dispositivos heterogêneos, acelerando a transferência de dados;

- Memory Manager: um motor que descarrega e recarrega dados de inferência de e para dispositivos de memória e armazenamento de baixo custo sem impactar a experiência do usuário.

O NVIDIA Dynamo estará disponível nos microserviços NVIDIA NIM e será suportado em uma futura versão pela plataforma de software NVIDIA AI Enterprise, com segurança, suporte e estabilidade de classe empresarial.

e será suportado em uma futura versão pela plataforma de software NVIDIA AI Enterprise, com segurança, suporte e estabilidade de classe empresarial.

Para saber mais, assista ao keynote do NVIDIA GTC, leia este blogpost sobre o Dynamo e registre-se para sessões da NVIDIA e líderes do setor no evento, que ocorrerá até 21 de março.

![[Coluna] Alemanha deve ficar mais atenta às boas notícias do Brasil](https://static.dw.com/image/70413126_6.jpg)