Que mi móvil pueda ver por mi es tan aterrador como fascinante. He probado los ojos de Gemini Live

En diciembre de 2024 OpenAI sorprendía al mundo con una función sencillamente brutal: ChatGPT tenía "ojos" y era capaz de ver e interpretar el mundo en tiempo real. La demo era sencillamente impresionante: la app, a través de la cámara, podía reconocer todo lo que viera. Y todo es todo. A principios de 2025, Google anunció una gran novedad para Gemini Live, su modo de voz avanzado. Un modo que llega para competir directamente con esta función de ChatGPT, y que ya está disponible para los Google Pixel 9 y Samsung Galaxy S25. Siempre y cuando pagues la suscripción Advanced. He podido probar esta función en un Google Pixel 9 Pro. Y sí, es tan impresionante como pudieras pensar. La interfaz. Activar los nuevos modos de "vision" de Gemini Live es bastante sencillo. Tan solo tienes que abrir la app e irte al modo avanzado de voz (el icono de la esquina inferior derecha). Una vez abierto Gemini Live, verás dos nuevos accesos directos: uno para darle acceso a la cámara y otro para darle acceso a tu pantalla. Porque sí, también puede leer en tiempo real el contenido de la pantalla. El modo de cámara. Al activar el modo de cámara, Gemini pasará a ver todo lo que la cámara le transmita. Es sencillamente espectacular cómo es capaz de reconocer absolutamente todo, y cómo de rápido es reconociendo aspectos concretos como tipos de planta, modelo de aparato tecnológico (sin que ponga nada en él). Podemos preguntarle de todo, y sirve como guía, traductor y... profesor particular. Esto último me ha parecido espectacular: resuelve ecuaciones, problemas psicotécnicos y todo tipo de preguntas explicando el paso a paso. En Xataka El nuevo Gemini demuestra una ambición de Google: que hablemos sin parar con nuestro móvil El modo de pantalla. Este modo es quizás el más peliagudo a nivel de privacidad pero, si estamos dispuestos, Gemini es capaz de leer todo lo que vea en la pantalla. Podemos preguntarle cualquier cuestión relacionada con la misma. En este caso no me ha parecido tan útil, ya que Google Lens nos da en un vistazo la información necesaria si estamos buscando algo en concreto. No obstante, es otra muestra del nuevo potencial de Gemini. No te fíes de la IA, nunca. Como siempre con la IA, la recomendación es no fiarse de ella. Es curioso como, en un plano general de mi escritorio, ha sido capaz de reconocer a la perfección mi ordenador. Sin embargo, al enfocarlo directamente, me decía que no veía ningún ordenador. Le he ayudado preguntando si es un Mac Mini M1 o un M4... y la respuesta ha sido que un M1 (son muy fácilmente distinguibles por puertos y tamaño). También se ha equivocado leyendo algunos números al preguntarle por algún test psicotécnico y, en definitiva, hay que estar bastante encima suyo para que funcione bien. Ni de sus preguntas. El problema que comparten Gemini Live y el modo de conversación avanzado de GPT está claro: son demasiado preguntonas. Para fomentar la conversación, acaban siempre las respuestas con una pregunta, algo especialmente molesto en este modo de visión. Es muy difícil lograr que vaya al grano, ya que suele interrumpir la respuesta completa con alguna pregunta. No deja de ser un problema menor compartido con todas las IA, pero rompe un poco el flujo conversacional. Pese a ello, el modo de visión de Gemini Live me parece bárbaro. Imagen | Xataka En Xataka | Google Gemini: qué es, cómo funciona, diferencias con GPT y cuándo podrás usar este modelo de inteligencia artificial - La noticia Que mi móvil pueda ver por mi es tan aterrador como fascinante. He probado los ojos de Gemini Live fue publicada originalmente en Xataka por Ricardo Aguilar .

En diciembre de 2024 OpenAI sorprendía al mundo con una función sencillamente brutal: ChatGPT tenía "ojos" y era capaz de ver e interpretar el mundo en tiempo real. La demo era sencillamente impresionante: la app, a través de la cámara, podía reconocer todo lo que viera. Y todo es todo.

A principios de 2025, Google anunció una gran novedad para Gemini Live, su modo de voz avanzado. Un modo que llega para competir directamente con esta función de ChatGPT, y que ya está disponible para los Google Pixel 9 y Samsung Galaxy S25. Siempre y cuando pagues la suscripción Advanced.

He podido probar esta función en un Google Pixel 9 Pro. Y sí, es tan impresionante como pudieras pensar.

La interfaz. Activar los nuevos modos de "vision" de Gemini Live es bastante sencillo. Tan solo tienes que abrir la app e irte al modo avanzado de voz (el icono de la esquina inferior derecha).

Una vez abierto Gemini Live, verás dos nuevos accesos directos: uno para darle acceso a la cámara y otro para darle acceso a tu pantalla. Porque sí, también puede leer en tiempo real el contenido de la pantalla.

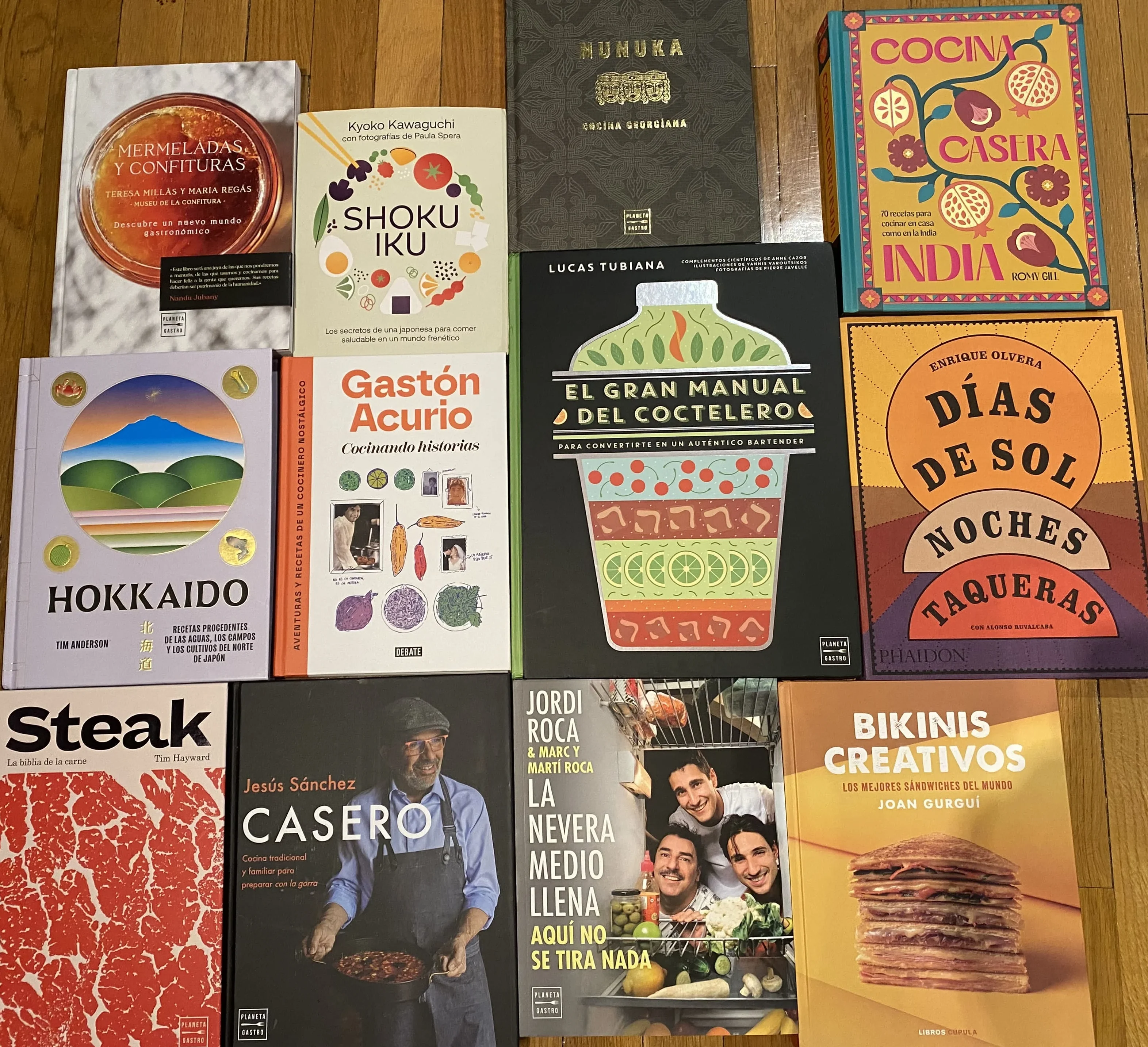

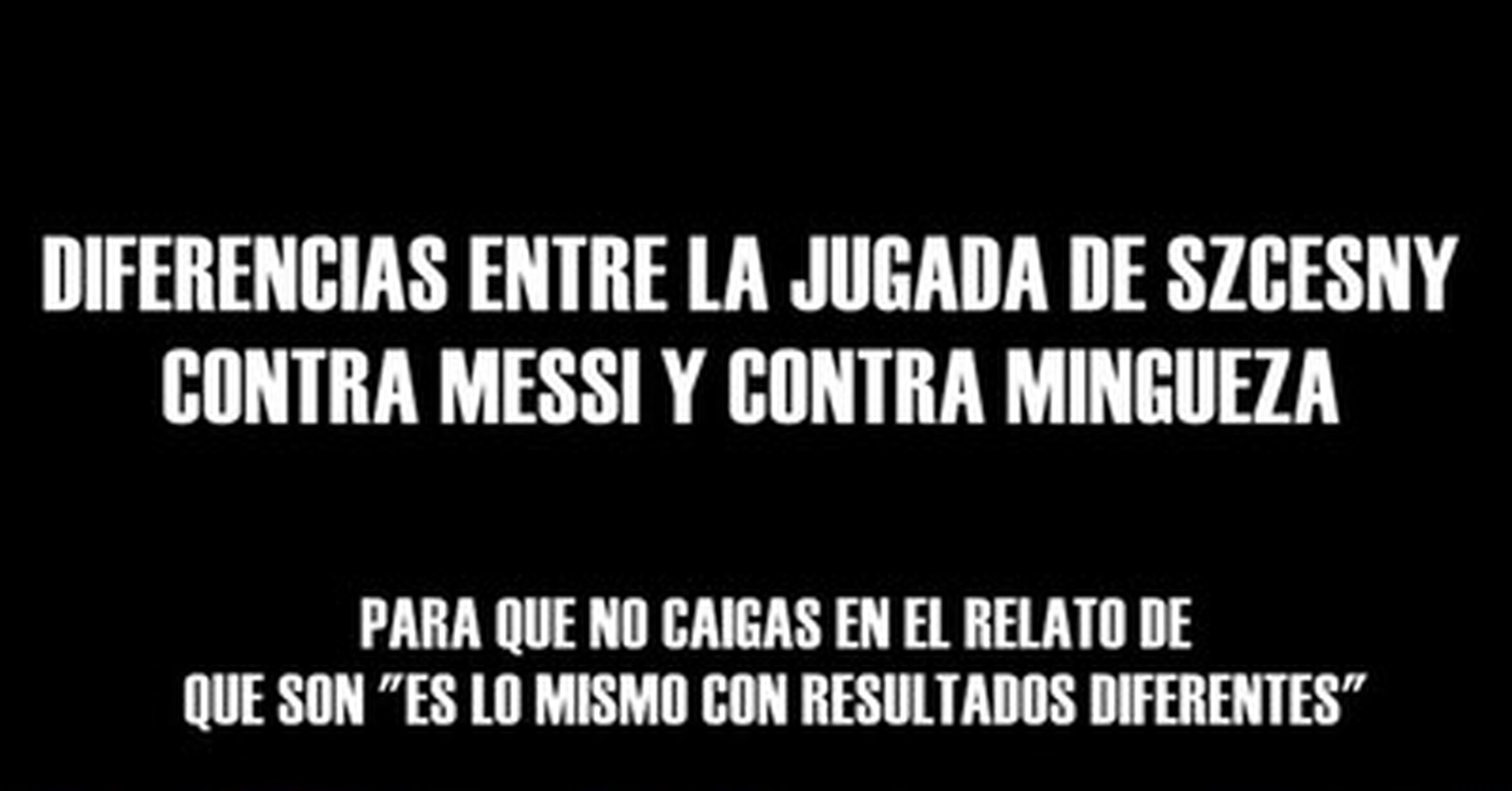

El modo de cámara. Al activar el modo de cámara, Gemini pasará a ver todo lo que la cámara le transmita. Es sencillamente espectacular cómo es capaz de reconocer absolutamente todo, y cómo de rápido es reconociendo aspectos concretos como tipos de planta, modelo de aparato tecnológico (sin que ponga nada en él).

Podemos preguntarle de todo, y sirve como guía, traductor y... profesor particular. Esto último me ha parecido espectacular: resuelve ecuaciones, problemas psicotécnicos y todo tipo de preguntas explicando el paso a paso.

El modo de pantalla. Este modo es quizás el más peliagudo a nivel de privacidad pero, si estamos dispuestos, Gemini es capaz de leer todo lo que vea en la pantalla. Podemos preguntarle cualquier cuestión relacionada con la misma.

En este caso no me ha parecido tan útil, ya que Google Lens nos da en un vistazo la información necesaria si estamos buscando algo en concreto. No obstante, es otra muestra del nuevo potencial de Gemini.

No te fíes de la IA, nunca. Como siempre con la IA, la recomendación es no fiarse de ella. Es curioso como, en un plano general de mi escritorio, ha sido capaz de reconocer a la perfección mi ordenador. Sin embargo, al enfocarlo directamente, me decía que no veía ningún ordenador.

Le he ayudado preguntando si es un Mac Mini M1 o un M4... y la respuesta ha sido que un M1 (son muy fácilmente distinguibles por puertos y tamaño). También se ha equivocado leyendo algunos números al preguntarle por algún test psicotécnico y, en definitiva, hay que estar bastante encima suyo para que funcione bien.

Ni de sus preguntas. El problema que comparten Gemini Live y el modo de conversación avanzado de GPT está claro: son demasiado preguntonas. Para fomentar la conversación, acaban siempre las respuestas con una pregunta, algo especialmente molesto en este modo de visión.

Es muy difícil lograr que vaya al grano, ya que suele interrumpir la respuesta completa con alguna pregunta. No deja de ser un problema menor compartido con todas las IA, pero rompe un poco el flujo conversacional.

Pese a ello, el modo de visión de Gemini Live me parece bárbaro.

Imagen | Xataka

-

La noticia

Que mi móvil pueda ver por mi es tan aterrador como fascinante. He probado los ojos de Gemini Live

fue publicada originalmente en

Xataka

por

Ricardo Aguilar

.