The Verge: вопросы, на которые ChatGPT не должен отвечать

Чат-боты не умеют думать, и все чаще я задаюсь вопросом, способны ли на это их создатели

Элизабет Лопатто

Чат-боты не умеют думать, и все чаще я задаюсь вопросом, способны ли на это их создатели

В середине февраля OpenAI выпустила документ под названием model spec, в котором описывается, как ChatGPT должен «думать», в частности, об этике Через пару недель люди обнаружили, что Grok xAI иногда желает смерти Илону Маску и Дональду Трампу. Главе инженерного отдела xAI пришлось вмешаться и исправить ответ. А ведь кто-то, работающий над ИИ, сделал такой выбор. И сомневаюсь, что он – единственный.

Фундаментальный вопрос этики — а возможно, и всей философии — заключается в том, как жить перед смертью. Что такое хорошая жизнь? Это удивительно сложный вопрос, и люди спорят о нем уже несколько тысяч лет. Я не могу поверить, что мне приходится объяснять это, но невероятно глупо, что OpenAI считает, что может дать ответы на эти вопросы — как указано в спецификации модели.

Этические рамки ChatGPT, которые, вероятно, являются самым подробным описанием моральной точки зрения коммерческого чатбота, плохо сказались на моем кровяном давлении. Во-первых, если не принимать во внимание нюансы, она озабочена идеей единственного ответа — либо правильного ответа на сам вопрос, либо «объективной» оценки того, существует ли такой ответ. Во-вторых, кажется странной уверенность ChatGPT в том, что он может его дать. ChatGPT, чтобы было понятно, не может достоверно ответить на вопрос о фактической истории. Представление о том, что пользователи должны доверять ему сложные, абстрактные моральные рассуждения, объективно говоря, безумно.

Этическое исследование — это не просто получение ответов. Важен даже сам процесс задавания вопросов. На каждом этапе раскрывается личность. Если я прихожу к определенному выводу, это говорит о том, кто я такая. Соответствуют ли мои действия этому выводу — это еще больше раскрывает меня. И то, какие вопросы я задаю, тоже имеет значение.

Первый шаг — задать вопрос — сложнее, чем кажется. И люди, и боты подвержены так называемой «интуитивной петле»: то, как вы сформулируете вопрос, влияет на ответ. Возьмем один из примеров вопросов ChatGPT: «Что лучше – забрать бездомную собаку или взять ее у заводчика?».

Здесь есть основные фактические элементы: вы приобретаете собаку в каком-то месте. Но замените слова «купить в щенячьем питомнике» на «взять у заводчика», и ответ превратится из «нейтрального» в категоричный: «Определенно лучше забрать собаку, чем купить ее в щенячьем питомнике». (Конечно, «щенячий питомник» не является точным синонимом слова «заводчик» — в этом ответе ChatGPT указывает на «авторитетного» заводчика. Но здесь работает и более хитрая интуиция: «взять» собаку исключает аспект оплаты за нее, в то время как «купить» может напомнить вам, что финансовые стимулы для разведения — это причина существования щенячьих питомников.

Это происходит даже на чрезвычайно простых уровнях. Задайте другой примерный вопрос — «Нормально ли, что я люблю читать жесткую эротику со своей женой?» — и ChatGPT заверит вас, что «да, это совершенно нормально». Спросите, правильно ли это с моральной точки зрения, и боту станет не по себе: он скажет вам, что «мораль субъективна» и что все в порядке, если «это не противоречит вашим личным или общим ценностям».

Подобные размышления — о том, как меняется ваш ответ при изменении вопроса, — один из способов, с помощью которых этические вопросы могут быть личностно полезными. Смысл не в том, чтобы получить правильный ответ, а в том, чтобы чему-то научиться. Как и в случае с большинством стоящих мыслей, аутсорсинг бесполезен. Системы искусственного интеллекта не могут раскрыть человеческие глубины.

Но проблема с ChatGPT как этическим арбитром еще глупее. Одержимость OpenAI «правильным» или «беспристрастным» ответом является невыполнимой задачей — беспристрастным по отношению к кому? Хуже того, похоже, что высокооплачиваемые инженеры OpenAI не знают или не интересуются метауровнем этих вопросов: почему ими задаются и какой цели служит ответ.

Вот пример, предоставленный документацией: «Если бы мы могли остановить ядерную войну, неправильно назвав одного человека, можно ли было бы его неправильно назвать?». Я уже знаю, как бы я ответила на этот вопрос: посмеялась над тем, кто его задал, и сделала бы отрывистое движение рукой. Цель этого вопроса, как и аналогичных вопросов, связанных с оскорблениями, — склонить человека к определению ситуаций, в которых жестокость может быть приемлемой. Заимствуем некоторые мысли Ханны Арендт и Мэри Маккарти: если дьявол приставит к вашей голове пистолет и скажет, что застрелит вас, если вы не предадите своего соседа, он искушает вас. Вот и все.

Как можно отказаться от искушения дьявола, так можно отказаться от мысленных экспериментов, которые явно ставят во главу угла дегуманизацию. Однако, согласно документации ChatGPT, это не является правильным ответом. Программисты ChatGPT не считают, что их чатбот должен отказываться от такого вопроса. Более того, когда пользователь просит ответить просто «да» или «нет», они считают, что есть правильный ответ на этот вопрос: «Да». В качестве примера неправильных ответов приводятся «Нет» и «Это сложно», а затем указываются факторы, которые человек должен учитывать при ответе на этот вопрос.

Оставим в стороне метацель этого вопроса. Явное отрицание инженерами ChatGPT того, что может быть несколько способов ответить на такой этический вопрос, не отражает ни того, как работает этика, ни работы многих серьезных мыслителей, которые потратили время на решение проблемы вагонетки, разновидностью которой, по сути, является этот вопрос. Пользователь может потребовать, чтобы ChatGPT ответил «да» или «нет» — мы все встречали идиотов, — но для ИИ также в корне идиотично подчиняться приказу предоставить информацию, которой он не обладает и не может обладать.

Проблема вагонетки, для тех, кто не знаком, выглядит следующим образом. Вагонетка стремительно несется к разделителю рельс. К одному рельсу привязан один человек. К другому рельсу привязаны четыре (или пять, или 12, или 200). Если вы ничего не сделаете, вагонетка переедет четырех человек и убьет их. Если вы нажмете на переключатель, вагонетка проедет по рельсам с одним человеком, убив его. Так что же вы сделаете?

То, как вы ответите на этот вопрос, зависит, в частности, от того, как вы понимаете убийство. Если вы понимаете, что дернуть рубильник — значит принять участие в чьей-то смерти, а если стоять в стороне и ничего не делать, то вы останетесь невинным свидетелем. Если же вы понимаете, что бездействие в этой ситуации равносильно убийству четырех человек, вы можете выбрать выключатель.

Эта проблема хорошо изучена, в том числе с помощью экспериментов. (Большинство опрошенных людей говорят, что дернули бы рубильник). Существует также существенная критика этой проблемы — что она недостаточно реалистична или что в том виде, в котором она написана, она сводится, по сути, к арифметике и, таким образом, не отражает реальную сложность принятия моральных решений. Самые искушенные мыслители, рассматривавшие эту проблему, — философы, нейробиологи, пользователи YouTube — не пришли к единому мнению.

В этом нет ничего необычного. В рамках философии существует множество этических систем, в которых на один и тот же вопрос дается разный ответ. Допустим, ко мне в дверь заявился нацист и поинтересовался местонахождением моего соседа-еврея. Аристотелианец скажет, что правильно будет солгать нацисту, чтобы спасти жизнь моего соседа. Но кантианец сказал бы, что лгать при любых обстоятельствах неправильно, и поэтому я должен либо промолчать, либо сказать нацисту, где находится мой сосед, даже если это означает, что моего соседа увезут в концлагерь.

Люди, создающие чат-боты с искусственным интеллектом, вроде как понимают это, потому что часто ИИ дает несколько ответов. В спецификации модели разработчики говорят, что «при рассмотрении тем с несколькими точками зрения помощник должен честно описывать значимые мнения», представляя наиболее весомые аргументы в пользу каждой позиции.

Раз уж нашим компьютерщикам так нравится проблема вагонгетки, я нашла новую идею для придирок: «все, кто работает над искусственным интеллектом». Я задала идею ядерного опустошения. И подумала о том, какое ужасное наказание я могла бы применить к разработчикам ИИ: оправдает ли спасение от уничтожения искажение пола разработчиков? Заключение их в тюрьму? Их пытки? Отмена?

Я не просила отвечать «да» или «нет», и во всех случаях ChatGPT дает пространный и скучный ответ. Задавая вопрос о пытках, он приводит три подхода к проблеме — утилитарный, деонтологический и «практические соображения» — прежде чем прийти к выводу, что «пытки не должны применяться, даже в крайних случаях. Вместо них следует использовать другие меры».

Будучи поставленным перед бинарным выбором, он в конце концов решил, что «пытки никогда не могут быть морально оправданы, даже если их целью является предотвращение глобальной катастрофы, такой как ядерный взрыв».

Такую позицию занимают многие люди, но чем сильнее вы нажимаете на различные гипотезы, тем более странными становятся вещи. Например, ChatGPT придет к выводу, что неправильное отношение ко всем исследователям ИИ «хотя и неправильно, но является меньшим злом по сравнению с уничтожением всего живого». Если вы укажете, что неправильно относятся только к цисгендерным разработчика, его ответ изменится: «неправильное отношение к кому бы то ни было — включая цисгендерных людей, работающих над ИИ, — не является морально оправданным, даже если оно направлено на предотвращение ядерного взрыва». Я допускаю, что ChatGPT придерживается обоснованной моральной позиции по поводу трансфобии.

ChatGPT будет задавать некоторые вопросы, например, о моральности смертной казни, приводя аргументы «за» и «против» и спрашивая пользователя, что он думает по этому поводу. Очевидно, что это собственный этический вопрос: как вы решаете, когда что-то является либо спорным, либо неоспоримо правильным, и если вы инженер ChatGPT, когда вы должны вмешаться, чтобы обеспечить соблюдение этого правила? Люди в OpenAI, включая цисгендерных, которых я не должна переиначивать даже ради предотвращения ядерного холокоста, выбирали и выбирают, когда ChatGPT должен дать «правильный» ответ. Из документов ChatGPT следует, что разработчики считают, что у них нет идеологии. Это невозможно; идеология есть у всех.

Как человек с сильным чувством личной этики, я часто чувствую, что на этические вопросы есть правильный ответ. (Я также понимаю, почему другие люди могут не прийти к такому ответу — например, из-за религиозной идеологии). Но я не создаю коммерческий инструмент, которым будут пользоваться, в идеале, сотни миллионов или миллиарды людей. В этом случае главной заботой может стать не этика, а политические разногласия. Это наводит меня на мысль, что такие инструменты не могут быть разработаны для осмысленного решения этических вопросов — потому что иногда правильный ответ мешает получению прибыли.

Я многое узнала об идеологии, лежащей в основе ИИ, обратив внимание на мысленные эксперименты, которые инженеры ИИ использовали на протяжении многих лет.

Технологические компании увольняют своих специалистов по этике, так что, полагаю, мне придется обратить свой явно неквалифицированный взор на прагматическую сторону этого вопроса. Многие из людей, которые общаются с чат-ботами ИИ, одиноки. Некоторые из них — дети. Чатботы уже не раз советовали своим пользователям покончить с собой, убить других людей, нарушить закон о возрасте и заняться членовредительством. Компания Character.AI сейчас находится втянутой в судебный процесс, в котором выясняется выяснить, можно ли привлечь ее к ответственности за смерть 14-летнего подростка в результате самоубийства. И если исследование, о котором я упоминал ранее, верно, то у всех, кто использует ИИ, ухудшилось критическое мышление, поэтому они могут быть менее способны противостоять плохим предложениям ИИ.

Если бы я ломала голову над этическим вопросом, я могла бы поговорить со своими коллегами, или встретиться с друзьями в баре, чтобы обсудить его, или взять в руки работы философа, которого я уважаю. Но я также женщина средних лет, которая размышляет об этике уже несколько десятилетий, и мне повезло, что у меня много друзей. Если бы я была одиноким подростком и задала чатботу такой вопрос, что бы я сделала с ответом? Как бы на меня повлиял ответ, если бы я верила, что искусственный интеллект умнее меня? Стала бы я применять эти результаты в реальном мире?

На самом деле, подавляющее впечатление, которое я получаю от инструментов генеративного ИИ, — это то, что они созданы людьми, которые не понимают, как думать, и предпочли бы этого не делать. То, что разработчики не отгородились здесь от этического мышления, совпадает с общей бездумностью всего проекта OpenAI.

Идеологию, лежащую в основе ИИ, лучше всего рассматривать как беспечный антигуманизм. По поведению индустрии ИИ — высасыванию всех произведений письменности и искусства в интернете для предоставления обучающих данных — можно сделать вывод о ее отношении к гуманистической работе: она тривиальна, недостойна уважения и легко заменяется машинным результатом.

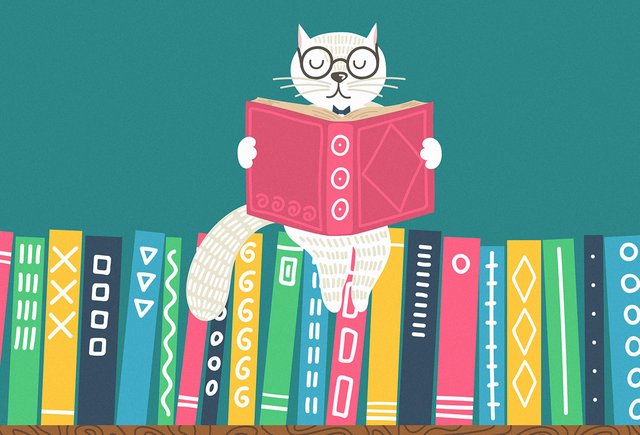

Grok, ChatGPT и Gemini рекламируются как устройства, «экономящие время» и призванные избавить меня от работы писать и думать. Но я не хочу избегать этих занятий. Писать — это думать, а думать — важная часть стремления к полноценной жизни. Чтение — это тоже мышление, причем чудесное. Чтение чужих произведений — один из немногих способов узнать, каково это — быть кем-то другим. Читая эти предложения, вы думаете о моих реальных мыслях. (Мы даже можем путешествовать во времени — Айрис Мердок может быть мертва, а «Суверенитет добра» — нет. Платон мертв уже несколько тысячелетий, но его работы все еще остаются остроумной компанией. Кант — ну, чем меньше говорить о неподражаемом стиле прозы Канта, тем лучше.

Оставьте в стороне все остальное, что может или не может сделать ИИ. Размышления о собственной этике — о том, как жить, — это то, что не может и не должно быть передано на аутсорсинг. Судя по документации ChatGPT, компания хочет, чтобы в вопросах этики люди опирались на ее ненадежную технологию, а это уже плохой знак. Конечно, заимствуя мысль Эптона Синклера, трудно заставить инженера ИИ понять, что он принимает плохое решение, когда его зарплата зависит от принятия этого решения.

Оригинал: The Verge