Как запустить A/B тест и получить достоверный результат: кейс Adventum и Hoff

В современном мире цифрового маркетинга A/B тестирование стало одним из наиболее эффективных инструментов для оптимизации пользовательского опыта и повышения конверсии. […] Запись Как запустить A/B тест и получить достоверный результат: кейс Adventum и Hoff впервые появилась БЛОГ ADVENTUM.

В современном мире цифрового маркетинга A/B тестирование стало одним из наиболее эффективных инструментов для оптимизации пользовательского опыта и повышения конверсии. Однако, несмотря на популярность метода, многие компании сталкиваются с трудностями в его реализации и интерпретации результатов.

Для проведения А/В тестирования есть свой набор инструментов и сервисов: Varioqub, Trisigma, Ux Rocket, Amplitude. И несмотря на то, что Amplitude больше не доступна на территории РФ, вы еще можете воспользоваться его бесплатным функционалом в рамках решения аналитических задач.

Что же такое А/В тестирование ?

Это метод сравнения двух версий продукта, позволяет определить, какая из них лучше соответствует конкретной цели Эксперимента.

Эксперимент может включать в себя все что угодно: от тестов на разных конверсионных воронках до необходимости контролировать основные метрики. Например, вы изменили дизайн главной страницы, и вам нужно понять, какой вариант принесет больше продаж старый или новый, и не уронит метрики.

В этой статье мы приводим «вредные советы для A/B тестирования» от Hoff, сети гипермаркетов по продаже мебели и товаров для дома, и специалистов Adventum. Как команда интернет-магазина научилась на своих ошибках, и как специалисты Adventum помогали их исправить, на примере работы с системой аналитики Amplitude.

Частые ошибки при проведение А/В тестов

1 ошибка — проверять несколько гипотез в одном A/B тесте

На сайте Hoff запустили блок с хитами распродаж, в котором были счетчик остатков, плашка «раскупили», раздел с важными свойствами. Решили тестировать сразу все инструменты: вырастили продажи, а за счет чего это получилось — проанализировать невозможно.

Как исправить:

- отдельно проверить каждую гипотезу;

- для нескольких гипотез проводить A/B/C тесты.

Любое изменение нужно тестировать отдельно, так как высока вероятность ошибиться.

2 ошибка — по тесту на одной платформе судить обо всех пользователях

У Hoff есть сайт и приложение, которое делится на iOS и Android. Также есть разделение по устройствам. Часто продакт менеджеры не анализируют, где именно конкретное изменение увеличило метрики, и раскатывают его на все платформы. В результате на одной платформе изменение позволило вырастить метрики, а на другой — получить нулевые результаты.

Как исправить: при дизайне эксперимента закладывать тестирование на всех ключевых платформах, и отслеживать результаты на каждой из них.

Менеджеры по продукту частенько строят процесс сплитования, анализируют результаты эксперимента в разных системах, и часто забывают пролить параметр A/B теста в систему аналитики.

Как исправить:

- завести инструкцию, где должны быть заложены все шаги A/B теста, в том числе заведение параметра;

- проверить на тестовой сборке, что разработчики корректно завели параметр в Amplitude;

- в первые дни эксперимента проверять, что сплитование прошло корректно.

3 ошибка — запускать параметр раньше начала теста

Во многих системах для A/B тестирования, кроме Amplitude Experiment, есть особенность: если вы завели A/B тест, но не включили его, система все равно начнет назначать пользователей в контрольную группу.

Обычно, когда появляется тестовая группа, данные начинают выравниваться, но всегда остается небольшой зазор между контрольной и тестовой группами.

Как решить:

- с помощью инструмента Cohorts создать когорту пользователей, которые заходили с даты заведения параметра до даты старта теста, и исключите ее;

- при анализе результатов ограничивать воронку датами проведения эксперимента.

4 ошибка — продлевать тест

Часто бывает так, что проводят тестирование, которое не показывает статистически значимого результата. Но вместо того, чтобы закрыть тест и запускать новые гипотезы, его продляют, чтобы получить статистически значимые результаты.

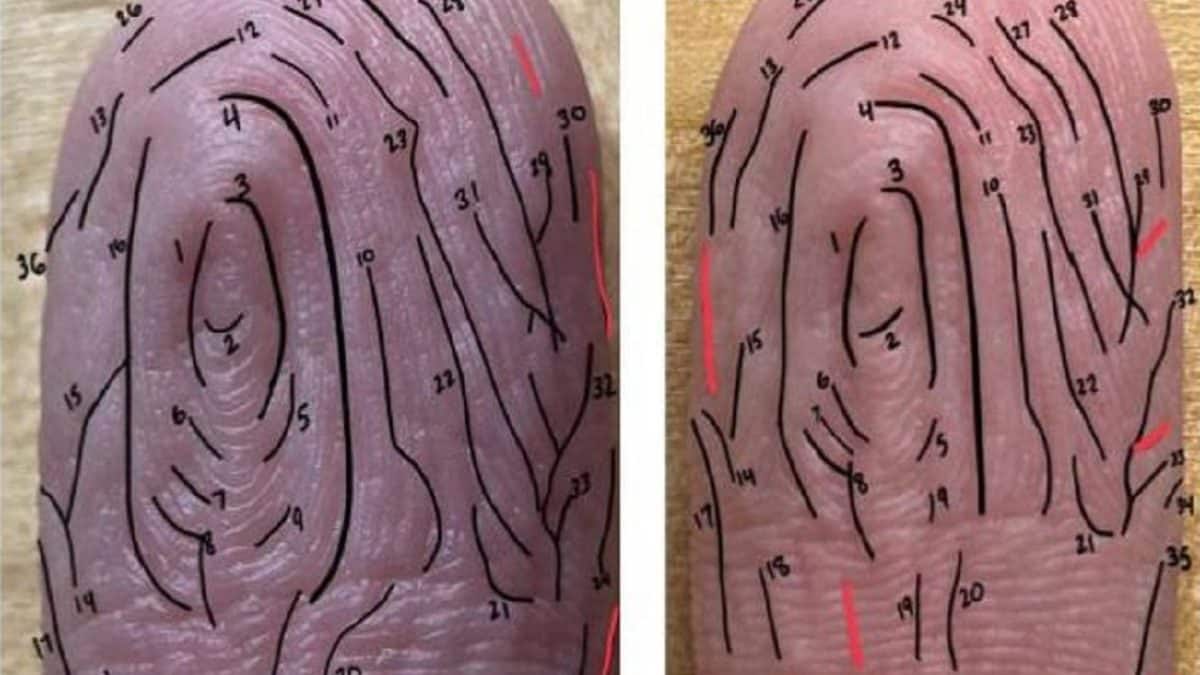

Почему так нельзя делать: в тестировании гипотез даже при идентичных группах разница в конверсиях может выходить за пределы зоны неразличимости. Это может создавать ложные сигналы, так как с каждым новым тестом повышается вероятность получить случайные различия.

Как решить:

- заранее определить количество пользователей, на основе которых будет оцениваться результат;

- собрать наблюдения, подсчитать результаты и сделать вывод.

5 ошибка — радоваться ложноположительному результату

В Hoff немного обновили онбординг и получили практически двукратный рост покупок у новых пользователей — это слишком высокий результат. Чтобы найти причину такого роста, стали анализировать A/B тест по дням и нашли аномалию: фродовый трафик распределился только в одной из групп.

Поэтому если вы видите подозрительные результаты, это повод копнуть поглубже и понять, почему так произошло.

Еще 10 способов, которые могут сломать эксперимент:

- Настраивать A/B тест для тестовой среды, но забыть настроить для боя;

- Не выпиливать старые A/B тесты из кода;

- Держать A/B тест меньше, чем длятся ваши периодические циклы (месячная подписка, выходные);

- Передавать параметр A/B теста не при открытии приложения, а позже (при загрузке главной);

- Запускать тестовую и контрольную группы на разные города/соц. страты;

- Запускать множественные сравнения (ABC/ABCD тесты) без коррекции уровня значимости;

- Раскатывать A/B тесты сразу на всех без проверки на малой группе;

- Запускать тест раньше, чем раскатать релиз;

- Некорректно выбирать целевую метрику;

- Не проверить, что 100% аудитории участвует в тесте;

У всех разный опыт, и даже самые крутые специалисты могут ошибаться.

Когда не нужен A/B тест:

- На странице теста недостаточно трафика;

- Недостаточно времени, чтобы набрать выборку (срочный ивент, распродажа и т.д.);

- Мало времени на проработку дизайна A/B теста. Именно во время проработки дизайна чаще всего понимают, что A/B тест не нужен;

- Страница теста забита другими тестами, и новый можно провести только параллельно;

- Планируется протестировать много гипотез сразу;

- Планируется протестировать обновление, которое напрямую не влияет на конверсию, например, NPS-опрос;

И так мы выяснили основные ошибки при проведение А/В тестирования, а также рассмотрели, когда не стоит его проводить. Теперь разберемся, как альтернативный Amplitude сервис Varioqub поможет решать аналитические задачи.

Varioqub — платформа для А/В тестирования, которая:

- Помогает бизнесу оптимально расходовать ресурсы и зарабатывать;

- Агрегирует все данные в едином интерфейсе: метрики, эксперименты, запуски, информирование;

- Позволяет провести эксперимент за один день;

- Эффективно использует вычислительные ресурсы.

Плюсы платформы :

- Возможность проводить эксперименты на сайтах любой сложности;

- Сравнение различных вариантов дизайна, текста, функционала сайта или приложения;

- Проведение экспериментов с рекламой;

- Персонализация контента для разных групп пользователей. Контент адаптируют с учётом интересов аудитории;

Так Varioqub в Яндекс Метрике — это мощный инструмент для создания и анализа кастомизированных отчетов. Позволяет глубже понимать поведение пользователей и вносить обоснованные изменения на сайте. Помогает оптимизировать маркетинговые стратегии, улучшать пользовательский опыт, повышать эффективность сайта и прибыльность бизнеса.

Проводите А/В тесты и не совершайте распространенные ошибки вместе с командой Adventum.

Подписывайтесь на наше аналитическое сообщество и будьте в курсе последних новостей в мире аналитики.

Запись Как запустить A/B тест и получить достоверный результат: кейс Adventum и Hoff впервые появилась БЛОГ ADVENTUM.