Usando IA em Python: um guia para criar uma web app simples

Conteúdo do tutorial Da teoria à prática: criando um recomendador de livros com IA Configurando o ambiente: ferramentas e recursos necessários Do prompt à API: desenvolvendo o motor de recomendações Desenvolvendo a interface web: simplicidade e rapidez com Gradio Elevando o projeto: implementação em JavaScript Da teoria à prática: criando um recomendador de livros com IA O primeiro conteúdo que vi sobre desenvolvimento pra uso de IA foi este curso gratuito de engenharia de prompt. Em um dos tópicos, o curso mostra como construir um chatbot simples. Nesse exercício, eu fiz um chatbot de recomendação de livros, já que as minhas maiores conversas com IA são pra descobrir autores que possam me interessar. Nos últimos dois meses, tenho trabalhado desenvolvendo aplicações que usam IA pra resolver problemas. Precisei aplicar técnicas mais avançadas, como RAG e embeddings. Mas a ideia do recomendador de livros ficou na minha cabeça. Assim, neste tutorial, vamos criar uma aplicação web simples que utiliza um modelo de linguagem de grande escala (LLM, ou large language model) para recomendar livros para a usuária com base no que ela deseja ler. Para isso, vamos usar Python puro. Configurando o ambiente: ferramentas e recursos necessários Se você quiser apenas rodar a aplicação e ver como ela funciona, pode acessar o repositório. As instruções estão no README.md. No entanto, se preferir seguir o tutorial para fazer sua própria versão da app, é necessário: instalar o Python e criar uma chave da API Gemini. A escolha do Python é óbvia: Python é a linguagem com o ecossistema mais extenso voltado pra IA [x]. Além disso, é notadamente intuitiva, com sintaxe fácil de entender e, portanto, bastante acessível para iniciantes. Optar por usar uma API da Google já não é tão óbvio. Eu escolhi a Gemini API da Google porque ela oferece um limite alto pra teste gratuito sem a necessidade de inserir um cartão de crédito. Mas é importante ter em mente que existe um motivo pelo qual é gratuito. ⚠️ Lembre-se: Se você não paga pelo produto, você é o produto. Eu até tentei rodar um modelo offline com Ollama, mas meu computador pessoal tem 4GB de RAM, e obviamente não rolou. Usar a API da Google não é o ideal mas, pra este tutorial, no qual não vamos compartilhar informações sensíveis, vai ter que servir. Do prompt à API: desenvolvendo o motor de recomendações A vantagem do Python fica aparente na primeira página da documentação da Gemini API. Todos os modelos que testei têm clientes Python pra facilitar a comunicação. Usar um modelo é simples assim: from google import genai client = genai.Client(api_key="YOUR_API_KEY") response = client.models.generate_content( model="gemini-2.0-flash", contents="Em um parágrafo, por favor, explique por que usar Python para desenvolver aplicações que usam IA.", ) print(response.text) Rodando o código (no prompt do interpretador interativo Python): Python se tornou a linguagem predominante para desenvolvimento de IA por diversas razões. Sua sintaxe clara e legível simplifica a escrita e a compreensão do código, acelerando o desenvolvimento. A vasta gama de bibliotecas e frameworks especializados, como TensorFlow, PyTorch, Scikit-learn e Keras, oferece ferramentas poderosas para aprendizado de máquina, processamento de linguagem natural, visão computacional e outras áreas da IA. Além disso, a grande e ativa comunidade Python fornece suporte abrangente, tutoriais e recursos, tornando o aprendizado e a resolução de problemas mais fáceis. A portabilidade de Python e a compatibilidade com diferentes sistemas operacionais também contribuem para sua popularidade, permitindo que os desenvolvedores implantem seus modelos de IA em diversas plataformas. Vamos criar uma função que utilize a mesma lógica para solicitar recomendações de livros. from google import genai def get_book_recs(key: str, prompt: str) -> str: client = genai.Client(api_key=key) response = client.models.generate_content( model="gemini-2.0-flash", contents=prompt ) return response.text if __name__ == "__main__": import os, sys key = os.environ.get("GOOGLE_API_KEY") prompt = sys.argv[1] if len(sys.argv) > 1 else "Recomende livros de ficção científica" print(get_book_recs(key, prompt))

Conteúdo do tutorial

- Da teoria à prática: criando um recomendador de livros com IA

- Configurando o ambiente: ferramentas e recursos necessários

- Do prompt à API: desenvolvendo o motor de recomendações

- Desenvolvendo a interface web: simplicidade e rapidez com Gradio

- Elevando o projeto: implementação em JavaScript

Da teoria à prática: criando um recomendador de livros com IA

O primeiro conteúdo que vi sobre desenvolvimento pra uso de IA foi este curso gratuito de engenharia de prompt. Em um dos tópicos, o curso mostra como construir um chatbot simples. Nesse exercício, eu fiz um chatbot de recomendação de livros, já que as minhas maiores conversas com IA são pra descobrir autores que possam me interessar.

Nos últimos dois meses, tenho trabalhado desenvolvendo aplicações que usam IA pra resolver problemas. Precisei aplicar técnicas mais avançadas, como RAG e embeddings. Mas a ideia do recomendador de livros ficou na minha cabeça.

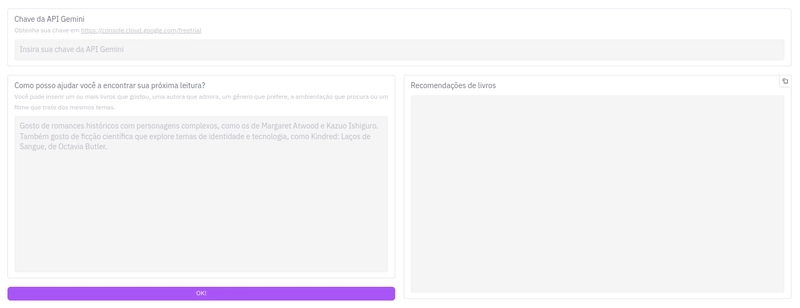

Assim, neste tutorial, vamos criar uma aplicação web simples que utiliza um modelo de linguagem de grande escala (LLM, ou large language model) para recomendar livros para a usuária com base no que ela deseja ler. Para isso, vamos usar Python puro.

Configurando o ambiente: ferramentas e recursos necessários

Se você quiser apenas rodar a aplicação e ver como ela funciona, pode acessar o repositório. As instruções estão no README.md.

No entanto, se preferir seguir o tutorial para fazer sua própria versão da app, é necessário:

- instalar o Python e

- criar uma chave da API Gemini.

A escolha do Python é óbvia: Python é a linguagem com o ecossistema mais extenso voltado pra IA [x]. Além disso, é notadamente intuitiva, com sintaxe fácil de entender e, portanto, bastante acessível para iniciantes.

Optar por usar uma API da Google já não é tão óbvio. Eu escolhi a Gemini API da Google porque ela oferece um limite alto pra teste gratuito sem a necessidade de inserir um cartão de crédito. Mas é importante ter em mente que existe um motivo pelo qual é gratuito.

⚠️ Lembre-se: Se você não paga pelo produto, você é o produto.

Eu até tentei rodar um modelo offline com Ollama, mas meu computador pessoal tem 4GB de RAM, e obviamente não rolou. Usar a API da Google não é o ideal mas, pra este tutorial, no qual não vamos compartilhar informações sensíveis, vai ter que servir.

Do prompt à API: desenvolvendo o motor de recomendações

A vantagem do Python fica aparente na primeira página da documentação da Gemini API. Todos os modelos que testei têm clientes Python pra facilitar a comunicação. Usar um modelo é simples assim:

from google import genai

client = genai.Client(api_key="YOUR_API_KEY")

response = client.models.generate_content(

model="gemini-2.0-flash",

contents="Em um parágrafo, por favor, explique por que usar Python para desenvolver aplicações que usam IA.",

)

print(response.text)

Rodando o código (no prompt do interpretador interativo Python):

Python se tornou a linguagem predominante para desenvolvimento de IA por diversas razões. Sua sintaxe clara e legível simplifica a escrita e a compreensão do código, acelerando o desenvolvimento. A vasta gama de bibliotecas e frameworks especializados, como TensorFlow, PyTorch, Scikit-learn e Keras, oferece ferramentas poderosas para aprendizado de máquina, processamento de linguagem natural, visão computacional e outras áreas da IA. Além disso, a grande e ativa comunidade Python fornece suporte abrangente, tutoriais e recursos, tornando o aprendizado e a resolução de problemas mais fáceis. A portabilidade de Python e a compatibilidade com diferentes sistemas operacionais também contribuem para sua popularidade, permitindo que os desenvolvedores implantem seus modelos de IA em diversas plataformas.

Vamos criar uma função que utilize a mesma lógica para solicitar recomendações de livros.

from google import genai

def get_book_recs(key: str, prompt: str) -> str:

client = genai.Client(api_key=key)

response = client.models.generate_content(

model="gemini-2.0-flash",

contents=prompt

)

return response.text

if __name__ == "__main__":

import os, sys

key = os.environ.get("GOOGLE_API_KEY")

prompt = sys.argv[1] if len(sys.argv) > 1 else "Recomende livros de ficção científica"

print(get_book_recs(key, prompt))