AI - DBRX - Databricks - Documentando automaticamente suas tabelas e colunas do Unity Catalog

Fala galera de Data, espero que todos estejam bem e acompanhando essa nova era da tecnologia que estamos vivenciando e desta forma nada melhor do que surfar nesse tsunami do que deixar ele te atingir não é mesmo? Hoje vou explicar ensinar uma das formas de você documentar automaticamente todas as suas tabelas e colunas que estiverem no Unity Catalog utilizando uma AI de precificação baixa que é a DBRX-Instruct da Databricks, sim isso mesmo automaticamente contudo por que isso é importante? A utilização de AI com dados corporativos precisam estar o mais "gritante" possível do que se trata, em outras palavras seu datalake precisa estar bem organizado desde definição da arquitetura de dados até nome de colunas, tabela, schema etc.. além é claro de documentar sobre do que se trata aquele banco de dados, schema, tabela e coluna e o que for mais possível documentar. Isso é muito importante por que quando você precisar e você VAI PRECISAR criar uma solução de AI, muito provavelmente você vai utilizar a técnica de RAG e passar para um Banco de dados Vetorial os seus dados e é aqui que entra a relevância da documentação. Para quem não sabe quando mais contexto o LLM receber melhor e mais rápido é a resposta, isso é devido entre outras variáveis ao contexto que você forneceu, aumentando a precisão de similaridade entre o que você quer saber. Requisitos para auto documentar minhas tabelas e colunas: Obviamente as tabelas devem estar no Unity catalog. Ter habilitado a nível de workspace o uso da API DBRX. Criação de um Token de usuário ou de service principal. Vamos documentar automaticamente uma tabela: Vamos importar o pacote de request para chamar a API DBRX com o prompt e o SparkSession para montagem da Sessão referente a aplicação em execução no cluster Spark: Posteriormente, vamos montar uma função que vai retornar a descrição efetuada pela chamada da API, mas já com alguns atributos importantes como **max_tokens **que é a quantidade máxima de palavras que você deseja considerar no retorno da API e o parâmetro de **temperature **que é o nível de criatividade do modelo, existem outros parâmetros mas estes são essenciais. Agora vamos de fato fazer a chamada e a montagem dos prompts. Este código Python utiliza o Apache Spark para gerar automaticamente descrições de uma tabela e suas colunas, empregando o serviço DBRX Instruct da Databricks. Detalhamento das etapas: Importação de bibliotecas: Inicialização da SparkSession: Obtenção do esquema da tabela: Configuração da chamada ao DBRX via Model Serving: Geração da descrição para a tabela: Geração de descrições para as colunas: Durante a execução você terá um output semelhante a este: Descrição gerada: Esta coluna contém a razão ou motivação para a perda de um X específico. Descrição gerada: A coluna 'x' em uma tabela 'y' representa a descrição de qualquer ação de reestruturação financeira ou organizacional relacionada a um acordo específico. Descrição gerada: A coluna 'x' em uma tabela 'x' representa a descrição de qualquer ação de reestruturação relacionada a um acordo específico. Descrição gerada: O "y" registra a data em que um desconto foi reconhecido em um acordo. Descrição gerada: "A descrição do custo de originação do acordo." Descrição gerada: O campo 'x' representa o custo de originação do em uma tabela chamada 'y'. Descrição gerada: A coluna 'x' na tabela 'y' representa a taxa efetiva padrão aplicada aos acordos. Descrição gerada: Ela identifica o usuário do sistema responsável pelo acordo. Agora com as descrições das colunas e da tabela hora de aplicar de fato na tabela alterando as propriedades: Por fim você pode da um comando de DESCRIBE TABLE EXTENDED para visualizar a documentação na tabela e nas colunas. Aqui foi apenas um exemplo simples em uma única tabela, você pode utilizar outros LLM além do DBRX bem como ir ajustando os parâmetros e o prompt para melhorar de acordo com seu cenário. Fonte: https://www.databricks.com/blog/introducing-dbrx-new-state-art-open-llm Meu Linkedin: https://www.linkedin.com/in/airton-lira-junior-6b81a661/ Repositório: https://github.com/AirtonLira/dbrx-auto-document-tables

Fala galera de Data, espero que todos estejam bem e acompanhando essa nova era da tecnologia que estamos vivenciando e desta forma nada melhor do que surfar nesse tsunami do que deixar ele te atingir não é mesmo? Hoje vou explicar ensinar uma das formas de você documentar automaticamente todas as suas tabelas e colunas que estiverem no Unity Catalog utilizando uma AI de precificação baixa que é a DBRX-Instruct da Databricks, sim isso mesmo automaticamente contudo por que isso é importante?

A utilização de AI com dados corporativos precisam estar o mais "gritante" possível do que se trata, em outras palavras seu datalake precisa estar bem organizado desde definição da arquitetura de dados até nome de colunas, tabela, schema etc.. além é claro de documentar sobre do que se trata aquele banco de dados, schema, tabela e coluna e o que for mais possível documentar. Isso é muito importante por que quando você precisar e você VAI PRECISAR criar uma solução de AI, muito provavelmente você vai utilizar a técnica de RAG e passar para um Banco de dados Vetorial os seus dados e é aqui que entra a relevância da documentação. Para quem não sabe quando mais contexto o LLM receber melhor e mais rápido é a resposta, isso é devido entre outras variáveis ao contexto que você forneceu, aumentando a precisão de similaridade entre o que você quer saber.

Requisitos para auto documentar minhas tabelas e colunas:

- Obviamente as tabelas devem estar no Unity catalog.

- Ter habilitado a nível de workspace o uso da API DBRX.

- Criação de um Token de usuário ou de service principal.

Vamos documentar automaticamente uma tabela:

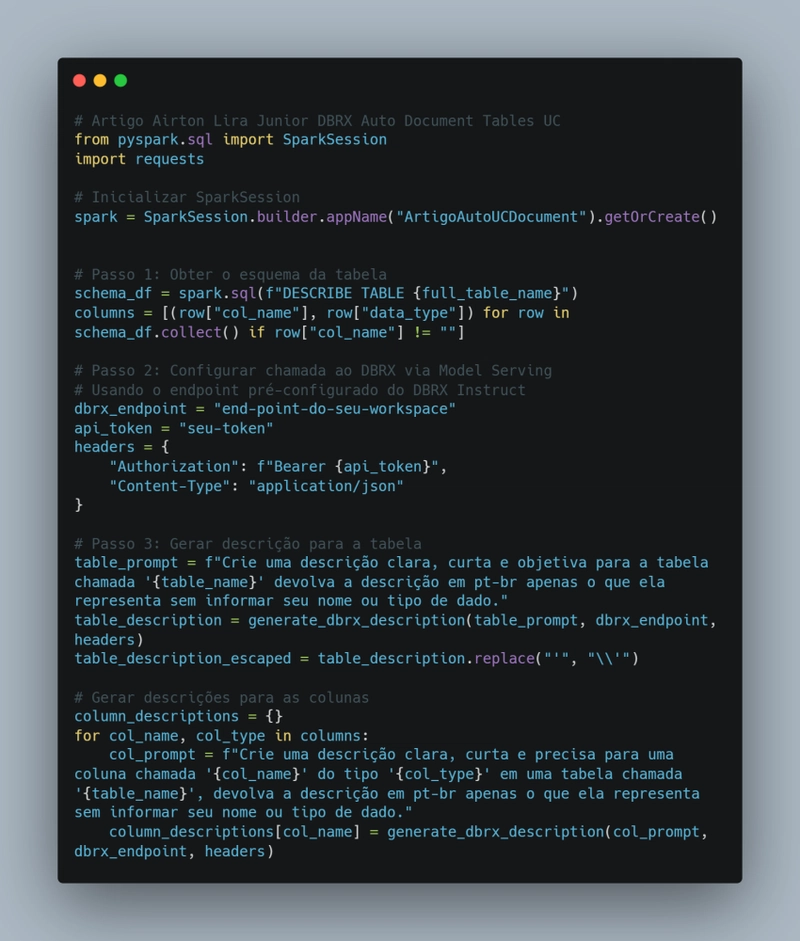

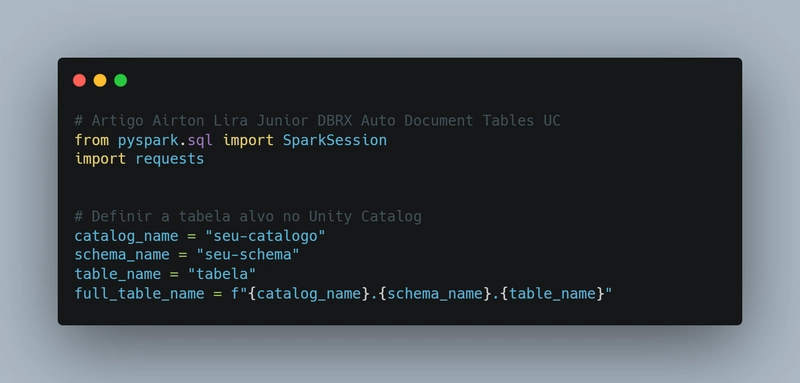

Vamos importar o pacote de request para chamar a API DBRX com o prompt e o SparkSession para montagem da Sessão referente a aplicação em execução no cluster Spark:

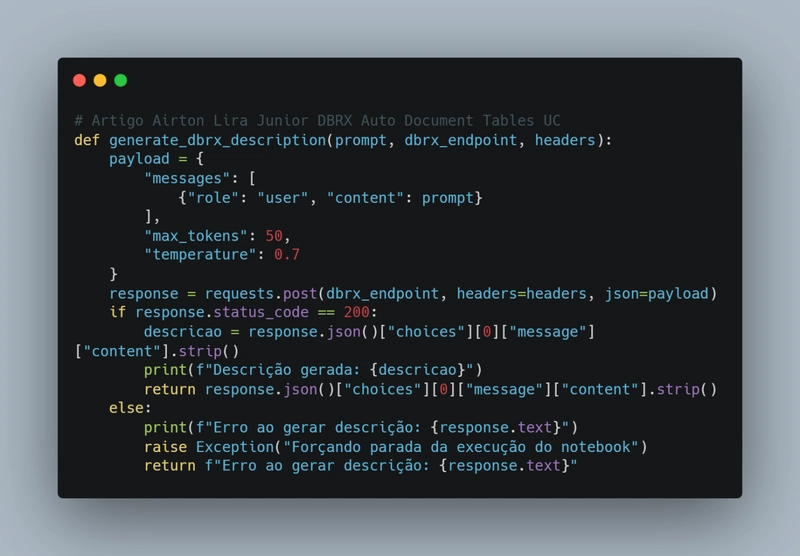

Posteriormente, vamos montar uma função que vai retornar a descrição efetuada pela chamada da API, mas já com alguns atributos importantes como **max_tokens **que é a quantidade máxima de palavras que você deseja considerar no retorno da API e o parâmetro de **temperature **que é o nível de criatividade do modelo, existem outros parâmetros mas estes são essenciais.

Agora vamos de fato fazer a chamada e a montagem dos prompts. Este código Python utiliza o Apache Spark para gerar automaticamente descrições de uma tabela e suas colunas, empregando o serviço DBRX Instruct da Databricks.

Detalhamento das etapas:

- Importação de bibliotecas:

- Inicialização da SparkSession:

- Obtenção do esquema da tabela:

- Configuração da chamada ao DBRX via Model Serving:

- Geração da descrição para a tabela:

- Geração de descrições para as colunas:

Durante a execução você terá um output semelhante a este:

Descrição gerada: Esta coluna contém a razão ou motivação para a perda de um X específico.

Descrição gerada: A coluna 'x' em uma tabela 'y' representa a descrição de qualquer ação de reestruturação financeira ou organizacional relacionada a um acordo específico.

Descrição gerada: A coluna 'x' em uma tabela 'x' representa a descrição de qualquer ação de reestruturação relacionada a um acordo específico.

Descrição gerada: O "y" registra a data em que um desconto foi reconhecido em um acordo.

Descrição gerada: "A descrição do custo de originação do acordo."

Descrição gerada: O campo 'x' representa o custo de originação do em uma tabela chamada 'y'.

Descrição gerada: A coluna 'x' na tabela 'y' representa a taxa efetiva padrão aplicada aos acordos.

Descrição gerada: Ela identifica o usuário do sistema responsável pelo acordo.

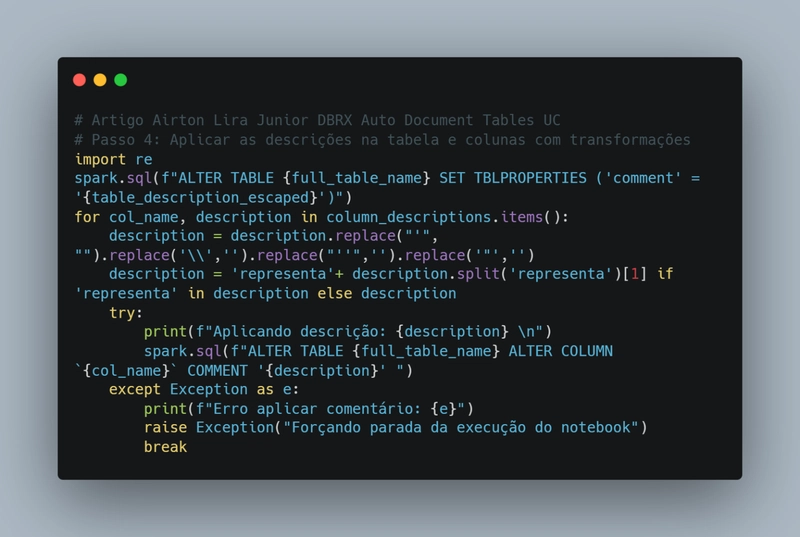

Agora com as descrições das colunas e da tabela hora de aplicar de fato na tabela alterando as propriedades:

Por fim você pode da um comando de DESCRIBE TABLE EXTENDED para visualizar a documentação na tabela e nas colunas.

Aqui foi apenas um exemplo simples em uma única tabela, você pode utilizar outros LLM além do DBRX bem como ir ajustando os parâmetros e o prompt para melhorar de acordo com seu cenário.

Fonte: https://www.databricks.com/blog/introducing-dbrx-new-state-art-open-llm

Meu Linkedin: https://www.linkedin.com/in/airton-lira-junior-6b81a661/

Repositório: https://github.com/AirtonLira/dbrx-auto-document-tables

_NicoElNino_Alamy.png?#)