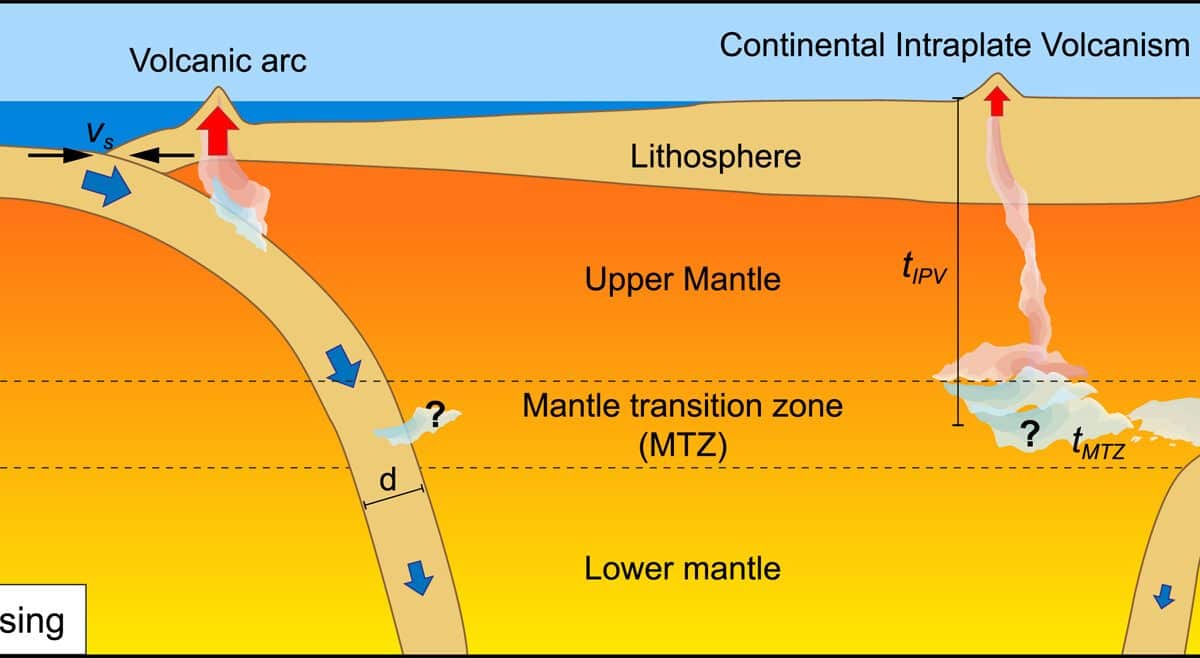

Стадии водопадного инженерного процесса для сухих и мокрых нейросеток

Водопад против agile в curriculum learning и успеваемость в обучении людей и нежитиИдея проста: и у людей, и у современных AI-агентов думалка основана на нейронном вычислителе (мокрые или сухие нейронные сети -- неважно, нейроморфные или "традиционные" с непрерывной функцией активации типа сигмоида или ReLU, там ведь всё одинаково, отличия слишком низкоуровневые). Материала тут много, напишу несколько мыслей. Давайте про последовательность обучения. Тут дана статическая картинка, "стадии", тот самый "водопад". Вся история инженерии показывает, что следующее, что будет -- уход от водопада к agile. Но пока тут важный тезис: последовательность обучения -- важна, curriculum learning. И этот тезис вызывает очень мало вопросов. Другое дело, что curriculum learning потом может быть проблематизирован по нескольким линиям:-- последовательность обучения превратится в последовательность дообучения, так что придётся всё, что дальше, считать не "стадиями", а "методами. -- появятся "таблетки знаний", то есть техники вроде LoRA ("загрузи мне в голову умение летать на вертолёте"), а также появится "разделение труда" в форме продвинутых композиционных MoE ("кому нужен гений, хорошо разбирающийся в физике, химии, математике и прочей логике? Готов включиться в ваш мозг, рядом с гением, разбирающимся в эстетике и мире искусства"). Но пока последовательность обучения нейросетей важна -- это не вызывает вопросов, за редкими исключениями. Для людей это демонстрируется как "сначала научи инженера", ибо "из инженера поэтом или актёром потом можно стать, а вот из поэта или актёра инженером -- вряд ли", "из инженеров в художники пойти -- запросто, пять лет учишься на инженера, год доучиваешься на художника, а вот из художников в инженеры -- будет более трудозатратно, пять лет учишься на художника, затем ещё семь лет -- на инженера, пять лет как инженеры и ещё пару лет добавочки, ибо прозевал момент". В любом случае, у людей обучение похоже уже на agile и journey по разным точкам контакта с учителями, а вот у нейросетей пока прогресс в основном на curriculum learning по водопаду: сначала Base model после pretrain, затем instruct после SFT, затем Chat после RLHF, потом Reasoning после RL. Вот и рассказали об уровнях квалификации для нейросетках.В любом случае, по каждой предметной области в обучении для людей, а заодно и для нейросетей -- в ходе "всего образования" выделяем четыре фазы, и дадим к каждой фазе отметку по старинным царским ещё критериям (Высочайше утверждено 8 декабря 1834 года, «Исторический очерк Николаевской Военной Академии Генерального штаба», составитель – Генерального штаба генерал-майор Н.П. Глиновецкий.-- https://distant.msu.ru/mod/page/view.php?id=18521):1. Необученная сеть, на входе у нас "архитектура нейронной сети" или "царь природы", успехи слабые 1-я степень (Успехи слабые)Ученик едва прикоснулся к науке, по действительному ли недостатку природных способностей, требуемых для успехов в одной, или потому, что совершено не радел при наклонностях к чему-либо иному.Это "необученная сетка", умеет ничего. 2. Предобучение/pretrain, на выходе -- Base model, успехи посредственныеНа этой стадии читаем тексты учебника, задачи можно не решать. Знакомимся с концептами, это предобучение/pretrain. На выходе у нас Base model.Сначала необученной сетке (повторим: неважно, мокрой или сухой) надо разметить пустое концептуальное пространство какими-то концептами, "найти паттерны". Это вполне делается через self-supervised learning. Конечно, тут важно качество данных. Для этого проверяется довольно много приёмов, одним из самых эффективных оказалось использование текстов на языках программирования, чтобы были сформированы паттерны хоть как-то структурированного мышления, паттерны консистентного использования типов, паттерны использования каких-то понятий, общих для мышления в целом (ключевые слова в языках программирования ведь как раз про это -- "общее для мышления в целом"). ШСМ у людей тут ничего особенного на входе не проверяет, но жалобно просит, чтобы приходили выпускники технических вузов -- там проще с каким-то пониманием паттернов мышления. Увы, обширные знания всякой литературы и хорошая память не дают ничего! В этой литературе нет собственно мышления, собранности на удержании некоторой цепочки умозаключений на хоть как-то знакомых концептах. Так что на входе у нас студенты после pretrain (который берётся из жизни): разговаривать умеют, но на вопросы ответить не могут, рассуждать связно/собранно на рабочие темы не могут. Но очень, очень начитанны!2-я степень (успехи посредственные)Ученик знает некоторые отрывки из преподанной науки, но и те присвоил себе одной памятью. Он не проник в ее основание и в связь частей, составляющих полное целое. Посредственность сия, может быть, происходит от некоторой слабости природных способностей, особливо от слабости того самомышления, которого он не мог заменить трудом и постоянным упражнением. Отличные дарования при легкомыслии и празднолюбии влекут за собой те же последствия.3. Дооб

Идея проста: и у людей, и у современных AI-агентов думалка основана на нейронном вычислителе (мокрые или сухие нейронные сети -- неважно, нейроморфные или "традиционные" с непрерывной функцией активации типа сигмоида или ReLU, там ведь всё одинаково, отличия слишком низкоуровневые). Материала тут много, напишу несколько мыслей. Давайте про последовательность обучения. Тут дана статическая картинка, "стадии", тот самый "водопад". Вся история инженерии показывает, что следующее, что будет -- уход от водопада к agile. Но пока тут важный тезис: последовательность обучения -- важна, curriculum learning. И этот тезис вызывает очень мало вопросов. Другое дело, что curriculum learning потом может быть проблематизирован по нескольким линиям:

-- последовательность обучения превратится в последовательность дообучения, так что придётся всё, что дальше, считать не "стадиями", а "методами.

-- появятся "таблетки знаний", то есть техники вроде LoRA ("загрузи мне в голову умение летать на вертолёте"), а также появится "разделение труда" в форме продвинутых композиционных MoE ("кому нужен гений, хорошо разбирающийся в физике, химии, математике и прочей логике? Готов включиться в ваш мозг, рядом с гением, разбирающимся в эстетике и мире искусства").

Но пока последовательность обучения нейросетей важна -- это не вызывает вопросов, за редкими исключениями. Для людей это демонстрируется как "сначала научи инженера", ибо "из инженера поэтом или актёром потом можно стать, а вот из поэта или актёра инженером -- вряд ли", "из инженеров в художники пойти -- запросто, пять лет учишься на инженера, год доучиваешься на художника, а вот из художников в инженеры -- будет более трудозатратно, пять лет учишься на художника, затем ещё семь лет -- на инженера, пять лет как инженеры и ещё пару лет добавочки, ибо прозевал момент".

В любом случае, у людей обучение похоже уже на agile и journey по разным точкам контакта с учителями, а вот у нейросетей пока прогресс в основном на curriculum learning по водопаду: сначала Base model после pretrain, затем instruct после SFT, затем Chat после RLHF, потом Reasoning после RL. Вот и рассказали об уровнях квалификации для нейросетках.

В любом случае, по каждой предметной области в обучении для людей, а заодно и для нейросетей -- в ходе "всего образования" выделяем четыре фазы, и дадим к каждой фазе отметку по старинным царским ещё критериям (Высочайше утверждено 8 декабря 1834 года, «Исторический очерк Николаевской Военной Академии Генерального штаба», составитель – Генерального штаба генерал-майор Н.П. Глиновецкий.-- https://distant.msu.ru/mod/page/view.php?id=18521):

1. Необученная сеть, на входе у нас "архитектура нейронной сети" или "царь природы", успехи слабые

1-я степень (Успехи слабые)

Ученик едва прикоснулся к науке, по действительному ли недостатку природных способностей, требуемых для успехов в одной, или потому, что совершено не радел при наклонностях к чему-либо иному.

Это "необученная сетка", умеет ничего.

2. Предобучение/pretrain, на выходе -- Base model, успехи посредственные

На этой стадии читаем тексты учебника, задачи можно не решать. Знакомимся с концептами, это предобучение/pretrain. На выходе у нас Base model.

Сначала необученной сетке (повторим: неважно, мокрой или сухой) надо разметить пустое концептуальное пространство какими-то концептами, "найти паттерны". Это вполне делается через self-supervised learning. Конечно, тут важно качество данных. Для этого проверяется довольно много приёмов, одним из самых эффективных оказалось использование текстов на языках программирования, чтобы были сформированы паттерны хоть как-то структурированного мышления, паттерны консистентного использования типов, паттерны использования каких-то понятий, общих для мышления в целом (ключевые слова в языках программирования ведь как раз про это -- "общее для мышления в целом").

ШСМ у людей тут ничего особенного на входе не проверяет, но жалобно просит, чтобы приходили выпускники технических вузов -- там проще с каким-то пониманием паттернов мышления. Увы, обширные знания всякой литературы и хорошая память не дают ничего! В этой литературе нет собственно мышления, собранности на удержании некоторой цепочки умозаключений на хоть как-то знакомых концептах. Так что на входе у нас студенты после pretrain (который берётся из жизни): разговаривать умеют, но на вопросы ответить не могут, рассуждать связно/собранно на рабочие темы не могут. Но очень, очень начитанны!

2-я степень (успехи посредственные)

Ученик знает некоторые отрывки из преподанной науки, но и те присвоил себе одной памятью. Он не проник в ее основание и в связь частей, составляющих полное целое. Посредственность сия, может быть, происходит от некоторой слабости природных способностей, особливо от слабости того самомышления, которого он не мог заменить трудом и постоянным упражнением. Отличные дарования при легкомыслии и празднолюбии влекут за собой те же последствия.

3. Дообучение/finetune, на выходе -- Instruct model, успехи удовлетворительные

Дальше LLM надо дообучить с учителем, SFT (дообучение с учителем, supervised finetune). Это делается для того, чтобы дать паттерны мышления на размеченном концептуальном пространстве. Паттерны мышления берутся "из примеров". На этом этапе избавляемся от галлюцинаций и прочих ошибок, но не до конца -- ибо это "мышление по рельсам", а не собственное мышление. Это разобраться в том, как решать задачи -- в учебниках тут примеры решения задач "по действиям", в вузах -- обучение "по кейсам". Нет рефлективность мышления (обсуждение стратегии решения задачи), нет выдвижения догадок и поиска ошибок. Паттерны все заимствованные, в новых ситуациях будет полный останов -- просто воспроизводятся паттерны мышления учителя. Но тут важно и первый пункт: демонстрация мышления должна быть ясная, корректная, тщательно подобранная: вот пара работ, которая говорит, что с этим условием данных надо x59 раз меньше (достаточно курированного набора из 1000 демонстраций, выбранных из 59000 демонстраций по критериям качества, трудности и разнообразия -- https://arxiv.org/abs/2501.19393. Если пожертвовать одним из трёх принципов, качество выходит хуже. Если 1000 вопросов с ответами подготовить лучше, качество растёт -- https://x.com/Muennighoff/status/1889310803746246694. В принципе, можно получить качество выше на полном наборе примеров, но там время на решение x59 примеров просто несопоставимо -- ещё одно свидетельство, что "учёного учить -- можно, но толку мало", обучение не должно быть чрезмерным. Для этого его надо делать на лучших учебных материалах из доступных!). Вот ещё одна работа -- там вообще принцип "меньше -- это больше", "LIMO: Less is More for Reasoning", SFT данных там x100 меньше и ещё появляется способность к генерализации, а не простому повторению ответов учителя: https://arxiv.org/abs/2502.03387.

Мы в ШСМ тут имеем "несправедливое конкурентное преимущество", хотя и делимся им, как и положено в мире AI, на условиях open source -- это тексты наших курсов, "курированный набор данных", доступный бесплатно -- просто не на GitHub (но там это тоже скоро будет), а на https://aisystant.system-school.ru. Текущие наборы данных для SFT обучают главным образом математике, физике, химии -- заставляют студента-нежить думать, воспроизводя мышление главным образом составителей олимпиадных задач. Это мышление, конечно, очень специфичное -- но учат ему, потому как вроде это хороший способ продемонстрировать, что ты хоть чему-то можешь научить (сомнительная демонстрация, но другой сейчас нет -- был пост на тему безуспешности измерения интеллекта, в том числе такими "экзаменами" или соревнованиями, как олимпиадные "испытания": "проблемы пузомерок для AI=болванов", https://ailev.livejournal.com/1753048.html).

Мы в нашем "курируемом наборе данных" даём ответы на вопросы по личному развитию (курсы программы "Личное развитие") и по

работе -- как думать о работе, об инженерных проектах в самых разных предметных областях (курсы программы "Организационное развитие", потому как инженеры про своё инженерное нормально думают, но когда надо разобраться в устройстве коллективной работы -- вот тут сбой, менеджменту их не учили, размышлениям о коллективной природе инженерного труда -- тоже не учили).

Удивительно, но после всего этого мы получаем студента, обученного всего-навсего "на троечку" (удовлетворительно). И разговаривать с ним нельзя без слёз, по факту будет только режим вопроса-ответ, никаких тебе "вопросов на уточнение" от студента.

3-я степень (успехи удовлетворительные)

Ученик знает науку в том виде, как она была ему преподана; он постигает даже отношения всех частей к целому в изложенном ему порядке, но он ограничивается книгой или словами учителя, приходит в замешательство от соприкосновенных вопросов, предлагаемых на тот конец, чтобы он сблизил между собой отдаленнейшие точки; даже выученное применяет он не иначе, как с трудом и напряжением. На сей степени останавливаются одаренные гораздо более памятью, нежели самомышлением, но они прилежанием своим доказывают любовь к науке.

4. Обучение с подкреплением на основе обратной связи от учителя, RLHF, на выходе -- Chat model, успехи хорошие

RLHF -- это reinforcement learning with human feedback. Это по факту тоже дообучение на примерах, только добавляются люди, корректирующие ответы -- если мысль ушла не туда, её поправляют, направляют мышление. Фишка тут в разворачивании диалога с уточнениями со стороны людей, ибо без людей мысль нейросетки студента (живого или нежити, это неважно) легко ускакивает в неописуемые фантазии -- и требуется как-то это корректировать. Конечно, SFT и RLHF очень похожи (и их даже пытаются перемешивать -- https://arxiv.org/abs/2405.11870), при этом RLHF сложен и дорог, от него стараются избавиться, переходя к чистому SFT, перескакивая через этот шаг сразу на поощрение собственного мышления, чтобы студент не копировал паттерны мышления одного шага рассуждения, или даже нескольких шагов рассуждения, а изобретал свои. Тем не менее, где-то в этом месте студент учится отличать -- какие ответы уместны в диалоге, а какие неуместны (все эти helpfullness и harmlessness тренируются тут, в общении с "профессором", живым или неживым). Да, в обычном обучении это эквивалентно тренировке с преподавателем.

В опыте ШСМ с живыми студентами тоже ключевое оказывается возможность прохода курса с преподавателем. Оказалось, что крайне важен тренинг в "хватании за язык" на системной мантре (начиная с того, что систему надо рассматривать сначала в момент эксплуатации, и это вещь). 100% студентов поначалу не имеют собранности пройти этот пункт, хотя всё понимают, всё знают, правила просты — но язык как-то сам ведёт не туда ))) У меня на эту тему пост есть, https://ailev.livejournal.com/1750301.html.

Я планирую где-нибудь в конце февраля-начале марта провести несколько таких тренировок с продажей билетиков на них "в розницу". Но это, конечно, главным образом первый шаг мантры. Но на курсах с преподами — там каждое занятие подобная тренировка, только по расширенному числу тем. Опыт показывает, что рефлексия (проверить, что там у тебя с типами — что ты реально сказал, а не что "намеревался сказать") заводится где-то от четырёх часов тренировки. А без тренировки, чисто по учебнику и упражнениям — не заводится, ибо момент ошибки далёк от момент обратной по ней связи. Поэтому мозг не перестраивается, безошибочность не растёт. А с преподавателем — безошибочность растёт быстро, причём в привязке к рабочим проектам, а не в привязке к "учебному материалу".

4-я степень (успехи хорошие)

Ученик отчетливо знает преподанное учение; он умеет изъяснить все части из начал, постигает взаимную связь их и легко применяет усвоенные истины к обыкновенным случаям. Тут действующий разум ученика не уступает памяти, и он почитает невозможным выучить что-либо не понимая.

5. Дрессировка (обучение с подкреплением), RL, на выходе -- Reasoning model, успехи отличные

Сегодня это и есть SoTA в обучении нейронных сетей, так получены модели o3, R1, Gemini 2.0 Flash Thinking. Лучше пока не найдёте. Учили их методом дрессировки, по умному -- обучения с подкреплением (reinforcement learning). Тут даётся задача с известным ответом, но неизвестным путём решения, "головоломка". Что такое "решённая головоломка" вроде понятно, это и будет "функция награды" (за решение животинке/неживотинке/студенту выдадют сначала махонький кусочек сахара, но и его потом заменяют свистком дрессировщика, поэтому животинка тыркается, делая случайные действия, пока не получит свисток, означающий "подкрепление", а нейросетка в этот момент запоминает связку "удачное действие -- награда"). Суть обучения в том, что награда даётся не за один шаг рассуждения, а за много шагов -- и по ходу обучения цепочка правильных действий для получения награды может сильно вырастать.

На этапе дрессировки главная задача -- награждать размышления как таковые, приучать думать долго. Тут два варианта

-- награждать за правильный ответ и терпеливо ждать, пока студент сам не изобретёт этот ход "давай-ка я проверю себя и подумаю ещё" (работы вроде обучения R1 https://arxiv.org/abs/2402.03300 -- и там даже пытались так дрессировать, пропуская этапы SFT и RLHF, но получилось плохо, а вот тут переобозвали RL в RLSP, learning via self-play, https://arxiv.org/abs/2502.06773, а вот тут разбирают подобные ходы, "Demystifying Long Chain-of-Thought Reasoning in LLMs" https://arxiv.org/abs/2502.03373, вот прямо сейчас очень много работ в этом направлении, это текущий фронтир в создании AI-систем, новая SoTA не столько в архитектуре нейросетей, сколько как раз в способе их обучения уму-разуму).

-- прямо заставлять "подумать ещё" (budget forcing, принуждать тратить бюджет времени на размышление), вот так просто. Сколько же надо думать? Опять же, думают обычно в письменном виде. Для сложных задач, требующих точных ответов, можно оценить количество исписанных черновиков -- для студентов это страницы текста (при машинописной плотности получаем четыре-пять исписанных листочков, если меньше, то "мало старался", или "гениален", чему не верим. А вот для нежити там прямо график -- точность от числа токенов, потраченных на размышления (и для олимпиадных задач по математике там где-то 8тыс. токенов примерно по три символа на токен, чтобы "победить почти всех умных", https://arxiv.org/abs/2501.19393.

Есть и варианты, где генерируются "ответы" на задачи в виде фукции на языке программирования -- и надо предсказать ответ, выполняя мышление на естественном языке, "как обычно", https://codei-o.github.io/. Это позволяет обучить универсальным примитивам мышления на естественном языке, including logic, symbolic, math & numerical, scientific, commonsense reasoning. Там пока предлагается огромный набор данных на 3.5млн задач, но опыт уже показал, что проблема не в количестве задач, а их качестве -- наверняка можно в разы и разы уменьшить количество этих задач. RL стадия важна в том, что в ней уже нет следования паттернам мышления учителя, как это было с SFT и RLHF. Нет, тут идёт поощрение на изобретение собственных паттернов мышления, а не повторение тех паттернов, которые виделись где-то в текстах pretrain или наблюдались у учителей. Это коренное изменение. Можно сказать, что только на этой стадии мы учим мышлению, а не "ремеслу" (то есть повторению подмастерьем действий мастера, без особого понимания).

Для нежити тут, конечно, возможно очевидное упрощение, которое резко повышает результативность и существенно сближает их работу с мокрыми нейросетками: собственно длительное размышление по решению задачи должно быть не на естественном языке, а на внутреннем языке (работ тут множество: DroidSpeak -- https://arxiv.org/abs/2411.02820, Coconut -- https://arxiv.org/abs/2412.06769 и отход от токенизации в byte latent -- https://arxiv.org/abs/2412.09871, самый свежий тут ход с recurrent depth -- https://arxiv.ogr/2502.05171, и число этих работ будет только расти). Основная причина эффективности тут -- не нужно обращаться к дискретизации пространства смыслов с грубостью, заданной редкими доступными концептов, можно пользоваться всеми доступными точками этого пространства, даже не помеченными языковыми "токенами". И ещё тут нейросетки плохо работают с модальностями: мышление "в словах" уже более-менее сравнимо с людским, а в словах и картинках вместе -- ещё нет, https://x.com/xiangyue96/status/1889137367002267998.

Использование AI и инструментов -- длинные цепочки рассуждений можно таки сдвигать на спецвычислители, или заводить их в своём мозгу, это эквивалентно: https://arxiv.org/abs/2409.12183. Все эти приёмы с "увеличением длины рассуждений" работают главным образом на "задачах STEM", на остальных задачах они не так эффективны. Человеческий мозг очень неэффективен в длинных цепочках рассуждений, "задачах STEM", нужных для инженерии -- равно как неэффективны и нейросетки, они эмулируют логические вычисления (а уж как они эмулируют просто сложения! Редкая неэффективность -- но если хочется научить сетку вычислять, то можно, она найдёт тригонометрический алгоритм сложения: https://arxiv.org/abs/2502.00873). Так что любую такую работу по "задачам STEM" хорошо бы куда-то сдвигать. Но что оставлять себе? Похоже, что нейросетки и людей, и нежити хороши в выдвижении догадок, а все проверки в строгих предметных областях ("наука и инженерия" -- STEM, что раскрывается как Science, Technology, Engineering, and Mathematics, традиционно тут главное не попало -- логика, онтология) надо сдвигать на разные спецвычислители. По иронии судьбы, неэффективные в рассуждениях нейросетки -- как раз такие вычислители для людей, им можно поставить задачу на естественном языке. А уж нейросетки могут выступить переводчиками к каким-то спецвычислителям, что поднимет эффективность, но уровень рассуждений при этом не просядет. Вот такая получается "трехуровневая схема скидывания строгой логики на спецускорители -- люди, LLM, инструменты для model cheking, https://en.wikipedia.org/wiki/Model_checking.

Мышление людей по факту уже внеязыковое, а также не визуальное, не аудиальное (у меня аж целая книжка "Визуальное мышление. Доклад о том, почему им нельзя обольщаться" была про это в 2018 году, https://ridero.ru/books/vizualnoe_myshlenie/, которая бесконечно устарела, но вывод там верный -- мышление внеязыковое и амодальное, идёт не в какой-то известной модальности. Модальный там только вывод. Внимание там только к "схеме", к модели -- и вот модальна как раз модель. Наш ход на поиск онтологического дребезга -- это просто ход на подключение кинестетического вывода во внимание в ходе мышления, равно как внимание есть к выводу в визуальной, аудиальной, вербальной-языковой модальностях). Поэтому для людей таких ухищрений не надо: отход от языковых представлений на предыдущих стадиях происходит естественным образом. Но всё-таки у людей тут не очень большое преимущество: они вынуждены удерживать свою собранность в длинных рассуждениях через записи -- черновики, ибо "догадки" пишутся в черновики, и большинство их будет откинуто, переживёт критику только результирующая догадка, а все промежуточные будут выкинуты.

В любом случае: вкус к мышлению как таковому появляется тут, мастер появляется тут. До этого -- подмастерье, в лучшем случае копирующий учителя. Ну, и оценка тоже меняется -- пятёрки появляются только для тех, кто мыслит сам, а не приводит "ответы по выученному шаблону", по примеченному в ходе обучения паттерну.

5-я степень (успехи отличные)

Ученик владеет наукой; весьма часто и определенно отвечает на вопросы, легко сравнивает различные части, сближает самые отдаленные точки учения, разбирает новые и сложные предлагаемые ему случаи, знает слабые стороны учения, места, где сомневается, и что можно возразить против теории. Только необыкновенный ум, при помощи хорошей памяти, в соединении с пламенной любовью к наукам, а следовательно, и с неутолимым прилежанием может подняться на такую высоту в области знаний.

6. Open-endedness, бесконечное познание, на выходе -- PhD model (учёный), успехи в форме нобелевской премии

Open-endedness (скажем, https://press.airstreet.com/p/open-endedness-is-all-well-need), это тоже без учителя, но речь идёт главным образом не о том, что мышления хватает для решения задач, которые ещё не видел ни преподаватель, ни студент -- это решается предыдущим обучением, обучением с подкреплением, где известна функция награды. Тут же -- надо идти туда, не знаю куда, исследовать мир. Это означает, что прежде всего надо уметь ставить новые интересные (не любые) задачи с особыми свойствами. Они должны быть трудными (помним про критерий "трудности" в отборе небольшого числа задач, на котором можно быстро учиться -- мы обсуждали это на стадии SFT, supervising finetuning), но не слишком -- чтобы был шанс решить, то есть и интересные (дающие новое знание), и Goldilocks ("ни холодные, ни горячие -- в самый раз" по трудности, https://en.wikipedia.org/wiki/Goldilocks_principle, от сказки "Златовласка и три медведя"). У меня про это был целый текст "В нейросетях devo вроде как реализовали, а для evo нужно ещё разобраться с eco" -- https://ailev.livejournal.com/1752457.html. Без этого нет эволюции знания, нет исследований.

Выход на open-endedness, бесконечное развитие, подразумевает обучение мастера постановке проблем (а не только решению проблем) для людей (впрочем, и для сетей) означает выход за пределы собственно "обучения в школе", с оценками. Собственно, это и выход за пределы "мастера" (master, магистр) на более высокий уровень. Тут можно говорить в академической традиции о выходе на степень PhD -- если пройти эту стадию и научиться ставить задачи (вообще-то предполагается, что этому известно как учить -- что спорно! но мы стараемся!), то это готовность к самостоятельным исследованиям. Если студент-отличник обнаружил какую-то хорошо поставленную задачу, которую до него никто не мог решить, то его святая обязанность -- решить её, иначе он не отличник. А дальше? Дальше надо уметь поставить задачу, сформулировать интересный goldilocks вопрос к окружающему миру. И тогда уже студенты решат эти задачи, продемонстрировав, что они -- отличники.

Как мы это решаем в ШСМ? По большому счёту, постановка задачи -- это паттернирование ситуации "из жизни" в каких-то весьма абстрактных типах, что позволяет сформулировать задачу, позволяющую выйти за рамки онтологии, которой пользуется мастер. Скажем, вы зашли в рабочий проект -- и видите бегающих вокруг сильно озабоченных чем-то людей, согласовывающих непонятно что, пытающихся соблюсти непонятно кем установленные дедлайны. Они вроде как принадлежат к какой-то организации, которая страстно хочет "развиваться" -- и вроде как выполняемые рабочие проекты по выпуску какой-то продукции и дают этой организации возможность развиваться. Вот есть курсы "ШСМ", где задаётся какой-то достаточно абстрактный набор концептов. Надо выполнить довольно сложные операции, чтобы разобраться в ситуации -- просто описать её в каких-то терминах, позволяющих дальше об этой ситуации рассуждать. Дальше надо поставить задачу, ключевой момент. И предложить решение. И делать это вечно, пока существует организация, или хотя бы пока существует проект. Это не мастер, который решает типовые задачи. Это другой уровень: типовых задач тут нет, и самое сложное -- это найти в сложной ситуации правильную задачу для решения.Собственно, значительная часть программы "Организационное развитие" как раз и ведёт к возможности сориентироваться в сложных ситуациях, и использовать мышление для постановки и даже нахождения решения задачи -- выдвижения труднокритикуемой гипотезы, требующей проверки (https://ailev.livejournal.com/1737214.html, https://ailev.livejournal.com/1744904.html) как раз к этому ведёт. Принципы квалифицирования, конечно, отличаются от представленной тут системы оценок "успеваемости" 1834 года, и даже слово "мастер" понимается не как "магистр" или "мастер по отношению к подмастерью" в ремёслах, как в предыдущем пункте. Более того, можно обсуждать: выход на open-endedness это чисто знаниевая часть -- или таки это ещё и использование знаний для реального дела?

Поэтому мы добавим ещё пункт, для ухода от чистой учёности.

7. Эволюция в физическом мире, на выходе -- Engineer model (инженер), успехи в форме изменения мира к лучшему

Тут надо научить выходить из "науки", "исследований", "аналитики" в инженерию как метод изменения мира к лучшему. Это ход на автономность и активность в изменении себя и окружающего физического мира. Кроме предложения решения поставленной задачи надо реально провести изменения мира согласно найденному решению. После уровня open-endedness, где мы гарантируем эволюционное накопление знаний, cognition ("обучение у природы", "задание вопросов природе", познание), выхода на PhD, мы идём к реформаторству -- изменению мира к лучшему. Итогом тут служит не решение поставленной в ходе open-endedness знаниевой задачи. Нет, итогом служит реальное изменение физического мира, создание какой-то успешной системы.

В этом месте обязательно надо отметить две вещи, которые страшно даже начинать расписывать:

-- инженерные проекты обычно коллективны, поэтому инженеров учат не только что-то сделать самому, но и участвовать в разделении труда (скажем, курсу менеджмента)

-- поскольку менять надо физический мир, то надо или быть человеком-во-плоти (а не чистым безруким и безногим мозгом), или роботом. Есть вариант: составить себе тело из инструментов (для человека это киборгизация, для робота -- нейросетка или их коллектив ставит под контроль что-нибудь весьма мощное: космический корабль, атомную электростанцию, стадион, тёмную холодную фабрику, ибо для безлюдного производства не нужно отапливать и освещать эту фабрику).

Что у нас в ШСМ на эту тему? Конечно, инженерные курсы. Вот ровно первых два свежепереписанных раздела курса "Системная инженерия" как раз про это -- связь науки и инженерии, знаниевой/исследовательской работы и работы по изменению физического мира, https://aisystant.system-school.ru/lk/#/course/systems-engineering/. В этих методах тоже есть SoTA, тоже есть чему учиться -- но там требуется выходит в физический мир и творить, участвовать не только в эволюции знаний, но и в реальной эволюции. Результаты прохождения программы оцениваются при этом не по итогам знаниевой работы (как у PhD) а по итогам демонстрации изменения ситуации в рабочем проекте (не в учебном проекте!) к лучшему -- вот критерии квалифицирования, https://ailev.livejournal.com/1723294.html. Мастер там -- это инженер, а если масштаб изменений большой, то -- реформатор или даже эволюционер (ладно, "революционер").

Возвращаемся к проблеме водопада: помним, что его не бывает, это чрезмерное упрощение

Критика "водопада" в инженерии идёт по нескольким линиям:

-- в жизни эта стадийность никогда не соблюдается, жизнь устроена не так -- в нашем случае это означает, что нет передачи каждой очередной модели (base, instruct, chat, reasoning, PhD, Engineer) с этапа на этам.

-- работы-этапы путаются с методами работы. Так что смело считаем описанное -- методами.

-- работы идут по этим методам работы в каком-то эволюционном (agile) процессе, в параллель и на выходе -- инкременты, а не готовые продукты.

Так что не надо принимать всё написанное за чистую монету, в тексте явно приведено чрезмерное упрощение. Впрочем, это чрезмерное упрощение в тексте не только по части водопада. Но дисклеймеры и оговорки при этом будут такой длины, что текст перестанет быть читаемым. Вы предупреждены.

Дальше надо только брать -- и делать, брать -- и делать. Картинка как раз об этом.