Apple: Dank KI mächtige Neuerungen bei Bedienungshilfen

Apple hat eine umfassende Erweiterung seiner Bedienungshilfen angekündigt. Alle Details im Überblick. Sie wird noch in diesem Jahr auf iPhone,...

Apple hat eine umfassende Erweiterung seiner Bedienungshilfen angekündigt. Alle Details im Überblick.

Sie wird noch in diesem Jahr auf iPhone, iPad, Mac und weiteren Geräten verfügbar sein werden.

Ziel ist es, Menschen mit unterschiedlichen Einschränkungen den Zugang zu digitalen Inhalten und Funktionen deutlich zu erleichtern und ihnen mehr Selbstständigkeit im Alltag zu ermöglichen.

Apple unterstreicht mit diesen Neuerungen seinen Anspruch, Technologie für alle zugänglich zu machen. Die neuen Funktionen greifen tief in das gesamte Apple-Ökosystem ein und setzen auf die Leistungsfähigkeit von Apple-Chips, maschinellem Lernen und Künstlicher Intelligenz, um Barrierefreiheit auf ein neues Niveau zu heben.

Label im App Store zeigen Angaben zur Barrierefreiheit

Im Zentrum der Neuerungen stehen mehrere innovative Funktionen, die sowohl für Nutzer als auch für Entwickler Vorteile bringen.

Eine der wichtigsten Neuerungen sind die neuen Labels mit Angaben zur Barrierefreiheit im App Store. Diese Labels erscheinen künftig auf den Produktseiten von Apps und Spielen und geben detailliert Auskunft darüber, welche Bedienungshilfen unterstützt werden – etwa VoiceOver, Sprachsteuerung, größere Schrift, hoher Kontrast, reduzierte Bewegungen oder Untertitel.

Nutzer können so bereits vor dem Download einschätzen, ob eine App für ihre Bedürfnisse geeignet ist. Entwickler erhalten zugleich die Möglichkeit, ihre Apps gezielt auf Barrierefreiheit hin zu optimieren und dies transparent zu kommunizieren.

Dieses System wurde von Interessenverbänden wie der American Foundation for the Blind ausdrücklich begrüßt, da es Menschen mit Einschränkungen mehr Sicherheit und Wahlfreiheit beim Kauf digitaler Produkte gibt.

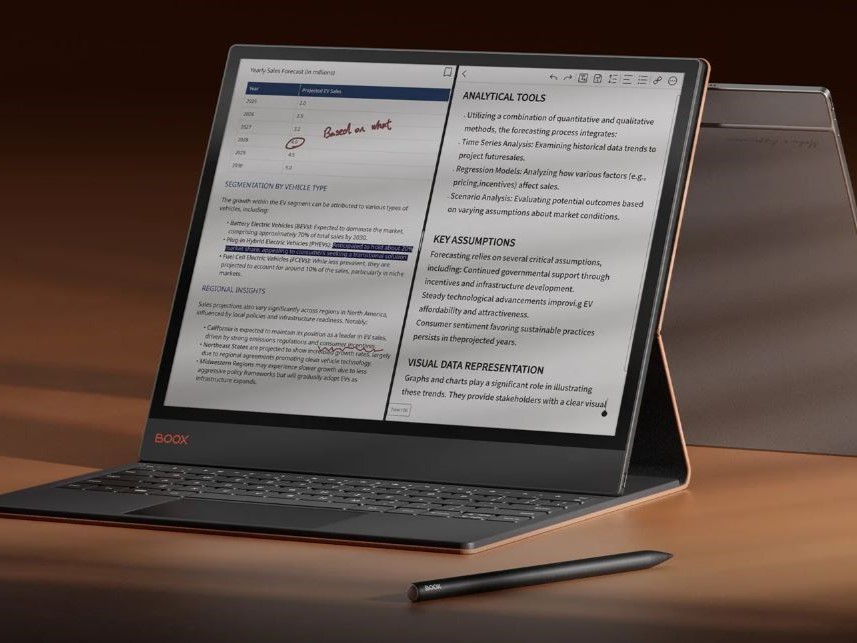

Für Menschen mit Sehbehinderungen bringt Apple die Lupe-App erstmals auf den Mac. Diese Anwendung nutzt die Kamera des Geräts oder die Continuity-Kamera des iPhones, um die Umgebung, Dokumente oder Whiteboards zu vergrößern und so besser lesbar zu machen.

Die Lupe bietet viele neue Optionen

Die Lupe bietet zahlreiche Anpassungsmöglichkeiten wie Helligkeit, Kontrast, Farbfilter und Perspektive. Mehrere Live-Fenster ermöglichen es, verschiedene Aufgaben parallel zu erledigen, etwa eine Präsentation zu verfolgen und gleichzeitig in einem Buch mitzulesen.

Die Lupe ist zudem mit dem neuen Reader für Barrierefreiheit verknüpft, der Texte aus der realen Welt in ein individuell lesbares Format umwandelt.

Mit dem neuen Zugriff auf Braille werden iPhone, iPad, Mac und Apple Vision Pro zu vollwertigen Braille-Notizgeräten. Nutzer können Apps per Braille-Eingabe starten, Notizen verfassen, mathematische Berechnungen mit Nemeth-Braille durchführen und BRF-Dateien direkt öffnen.

Live-Untertitel werden in Echtzeit auf Braille-Displays transkribiert, was insbesondere für blinde Menschen einen erheblichen Mehrwert darstellt.

Der Reader für Barrierefreiheit ist ein neuer systemweiter Lesemodus, der Texte für Menschen mit Legasthenie oder Sehbehinderung leichter zugänglich macht. Er bietet umfangreiche Anpassungen bei Schriftart, Farbe, Abstand und unterstützt gesprochene Inhalte.

Die Vorteile des neuen Readers

Der Reader kann aus jeder App heraus gestartet werden und ist in die Lupe-App integriert, sodass auch Texte aus der physischen Welt – etwa Bücher oder Speisekarten – erfasst und vorgelesen werden können.

Für gehörlose oder schwerhörige Nutzer wird Live Mithören auf der Apple Watch erweitert. Das iPhone kann als Fernmikrofon dienen und Inhalte direkt auf AirPods oder Hörgeräte übertragen.

Live-Untertitel lassen sich dann auch auf der Apple Watch anzeigen und steuern, was insbesondere in Meetings oder im Unterricht praktisch ist. Die Apple Watch dient dabei als Fernbedienung für Live Mithören-Sessions.

Apple Vision Pro erhält Verbesserungen für Menschen mit Sehbehinderung: Das Kamerasystem ermöglicht einen erweiterten Zoom auf die Umgebung, während Live-Erkennung Objekte beschreibt, Dokumente liest und Orientierung bietet.

Entwickler können über eine neue API auf die Hauptkamera zugreifen, um visuelle Unterstützung in Apps wie Be My Eyes zu integrieren.

Zusätzlich gibt es zahlreiche kleinere Verbesserungen. Hintergrundgeräusche lassen sich individueller anpassen, die Funktion Eigene Stimme ermöglicht es Menschen mit Sprachverlust, in kürzester Zeit eine natürlich klingende digitale Stimme zu erstellen.

Hinweise auf Fahrzeugbewegung helfen, Reisekrankheit zu reduzieren. Eye Tracking und Head Tracking erlauben die Steuerung von iPhone und iPad mit den Augen oder Kopfbewegungen. Für Nutzer mit schweren Mobilitätseinschränkungen wird die Schaltersteuerung um Unterstützung für Brain-Computer-Interfaces erweitert.

Auch Musikhaptik, Geräuscherkennung, Sprachsteuerung und Live-Untertitel werden ausgebaut und in mehr Sprachen angeboten.

In diesem Artikel sind Partner-Links enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet Ihr Euch für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für Euch ändert sich am Preis nichts. Danke für Eure Unterstützung. Fotos: Apple

:quality(80)/p7i.vogel.de/wcms/64/df/64df5242e91ca49307f4d95b8528d368/0122758754v1.jpeg?#)

,regionOfInterest=(833,510)&hash=0cc064f8e4c951df147d75276a620e9a59f3ad19425b3fb12ed05ac396268fc6#)

,regionOfInterest=(947,254)&hash=d8bbef68d036a22921e287bcb5088dc7676527ce374e579821fbffa43f469804#)